Anthropic、Claudeの“憲法”改訂 倫理と有用性の優先順位を再定義

米Anthropicは1月22日、AIモデル「Claude」の振る舞いを規定する新たな指針「Claude’s new constitution」(Claudeの新憲法)を公開した。これはAIモデル「Claude」に期待する価値観や振る舞いを詳細に説明した文書で、同社が考える倫理性や安全性、助けになる行動の意義とその背景を詳述したものだ。新憲法は単なる行動指針の列挙ではなく、なぜそうした価値が重要なのかを理解させることを重視しているという。

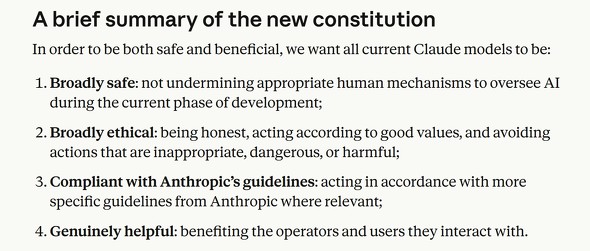

新憲法の価値優先順位は「安全性」「倫理性」「Anthropicガイドラインへの準拠」「実際に役立つこと」という4つの軸で整理され、対立する価値間の判断基準として機能する。例として、Claudeが安全で倫理的な振る舞いを保ちつつ、ガイドラインと有用性をどう両立させるかについての詳細な助言や、困難な状況でのトレードオフに対応するための指針が含まれる。

人間による監督や倫理的配慮を損なわないことが優先され、具体的な危険行為(大量破壊兵器への助力など)は「hard constraints」として明確な禁止対象となっている。さらに、Claudeの存在そのものや道徳的地位についての不確実性にも触れ、それが判断や行動に与える影響についての考察も含まれている。

Claudeの学習プロセスにも組み込まれ、価値観に沿った対話や判断を生成するための訓練データ生成にも用いられる。

Anthropicは2023年5月に最初の憲法を公開している。この旧憲法は、価値観や行動原則を列挙した形式が中心だった。国連の「世界人権宣言」などを参照しながら、AIが有用かつ無害であるべきという基本的な基準を明示していた。

新憲法は、その背後にある「なぜそうするべきか」という理由や文脈を理解させる方向へ進化し、単なるルールの羅列から包括的な倫理理解へのシフトとして位置づけられる。新憲法はトレーニング過程全体で中心的役割を果たすことが期待されている。

この憲法全文はCC0ライセンスで公開されており、開発者は自身のAIモデルの訓練や安全性評価のベンチマークとして自由に利用できる。Anthropicは、開発プロセスを透明化することで、AIの意図した振る舞いと実際の出力の乖離(アライメント問題)を解消していく姿勢を示している。

関連記事

画像生成は「やらない」 “安全なAI”で日本市場を攻めるAnthropic、日本代表に聞く差別化のポイント

画像生成は「やらない」 “安全なAI”で日本市場を攻めるAnthropic、日本代表に聞く差別化のポイント

AIモデル「Claude」を開発する米Anthropicが日本での事業展開を進めている。日本法人であるAnthropic Japanの東條英俊代表に、日本市場での勝ち筋などを聞いた。 Anthropic、LLMはわずか250件の悪意あるデータで「汚染」可能という研究結果

Anthropic、LLMはわずか250件の悪意あるデータで「汚染」可能という研究結果

Anthropicは、LLMのデータポイズニングに関する研究結果を発表した。モデルの規模に関わらず、わずか250件の悪意ある文書で「バックドア」を仕込めることが判明したとしている。攻撃に必要な文書数が従来想定より遥かに少なく、脅威の深刻さを示唆している。 Anthropic、AI「Claude」に“核兵器への悪用”を防ぐシステム実装

Anthropic、AI「Claude」に“核兵器への悪用”を防ぐシステム実装

Anthropicが米政府機関と協力し、AIの核兵器開発への悪用を防ぐシステムを開発した。「Claude」に実装済みのこの分類器は96%の精度で危険な対話を検知する。成果は他分野への応用も視野に業界で共有する予定だ。 Google、ChatGPT競合チャットbot開発中の新興企業Anthropicを支援

Google、ChatGPT競合チャットbot開発中の新興企業Anthropicを支援

GoogleはOpenAIの「ChatGPT」と競合するチャットbot「Claude」を開発する新興企業Anthropicを支援すると発表した。AnthropicはGoogle Cloudを優先クラウドプロバイダーとし、GoogleはAnthropicのAIシステム開発のためにTPUおよびGPUクラスタを構築する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.