「宇宙船や洞窟を永遠に高速移動するシーン」を生成するAI テキスト指示で映像作成:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

イスラエルのWeizmann Institute of ScienceとNVIDIA Researchに所属する研究者らが発表した論文「SceneScape: Text-Driven Consistent Scene Generation」は、テキスト入力だけから高速に移動する永久シーンを生成する学習ベースのモデルを提案した研究報告である。

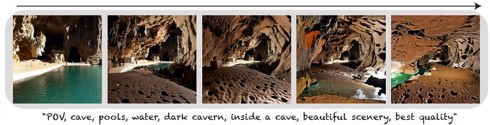

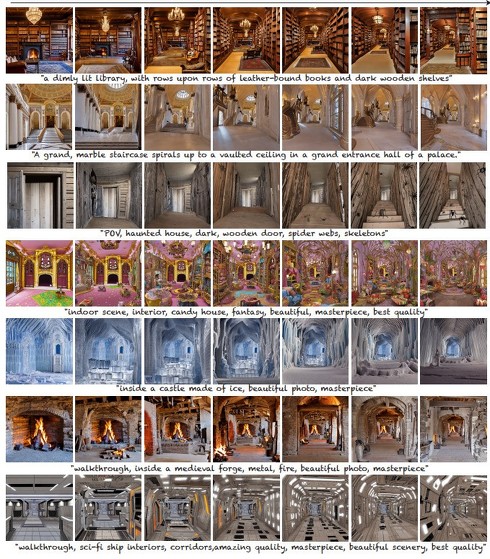

風景などの限られた領域にしか適用できない先行研究とは対照的に、宇宙船や洞窟、氷の城などの屋内の永久シーンの生成も可能にする。

1枚の入力画像からもっともらしい長時間映像を生成することは、いくつかの課題を抱えている。その1つが、合成されたコンテンツが実現可能な3次元世界と整合性が取れているかという点だ。

例えば、視差効果やシーン内の異なるオブジェクトの咬合関係などを正しく表現する必要がある。また新しいコンテンツを合成するためには、現在の視野の先がどのように見えるかについての強い事前知識が必要である。さらに、生成したコンテンツは滑らかで、時間が経過しても一貫して見える必要がある。

このような理由から既存モデルは、特定のドメインに依存しており、対象領域の動画や画像に対して大規模な学習を行う必要があり、その利用には限界があった。

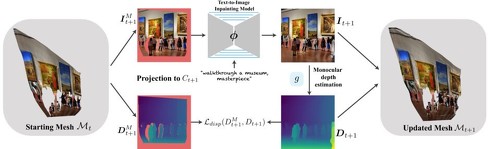

今回の研究では、テキストから画像への変換の進歩に触発されて、テキスト駆動型永久視野生成のための新しいフレームワークを提案する。入力画像を必要とせず、シーンやカメラポーズを説明する文章のみからシーンの長距離動画を合成する。自然言語でシーンを指定できるため、特定のドメインに縛られていないのが特徴だ。

提案手法は、特定のドメインからの学習データを必要としない。事前に学習したテキストから画像への拡散モデルによって学習した生成事前分布と、事前に学習した奥行き予測モデルによって学習した幾何学的事前分布を利用した、ゼロショット方式でシーンを生成する。

具体的には、入力したテキストとカメラの軌跡をもとに、1フレームずつオンライン方式でシーンを生成する。奥行き予測モデルにより、新たに生成したコンテンツの形状を推定し、生成したシーンが実現可能な3次元形状に従うことを保証するためにシーンのメッシュ表現を推定する。

単眼での奥行き予測は、異なるフレーム間でちらつきや一貫性がない傾向がある。そのため、テスト時に奥行き予測モデルを微調整し、既知の合成済みコンテンツに対するメッシュ表現から予測できる奥行きと一致させている。

実験では、さまざまなプロンプトから生成したさまざまなシーン(写実的なシーンと想像上のシーンを含む)に対して、定量的・定性的な評価を行った。50フレームの動画を生成し、カメラの動きは後方に高速移動するシーンとした。

結果、複雑な構造や多様な照明(例えば、蛍光灯や火など)のようなさまざま々な特性を持つシーンを描写し、高品質で幾何学的に妥当なシーンを生成できており、その有効性を実証した。

制限事項として、時間の経過とともに低下する場合があり、長時間の映像では幾何学的なゆがみやアーチファクトが発生する場合がある。また屋外シーンにおける空と地面のような奥行きの劇的な不連続性を表現することも困難である。

Source and Image Credits: Fridman, R., Abecasis, A., Kasten, Y., & Dekel, T.(2023). SceneScape: Text-Driven Consistent Scene Generation. arXiv preprint arXiv:2302.01133.

関連記事

画像生成AIの「高品質なプロンプト」を0.01秒で盗むサイバー攻撃 ドイツの研究機関が発表

画像生成AIの「高品質なプロンプト」を0.01秒で盗むサイバー攻撃 ドイツの研究機関が発表

ドイツの研究機関CISPA Helmholtz Center for Information Securityに所属する研究者らは、テキストから画像を生成するモデルで生成した画像からテキストプロンプトを盗用する攻撃を提案した研究報告を発表した。 Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

MetaのザッカーバーグCEOは「ジェネレーティブAIチーム」結成を発表した。長期目標として、人間を支援するAIペルソナの構築を掲げた。 ChatGPT、美少女になる 立体AIキャラと魔合体でスムーズにおしゃべり Gateboxのデモ動画が話題

ChatGPT、美少女になる 立体AIキャラと魔合体でスムーズにおしゃべり Gateboxのデモ動画が話題

3月2日(日本時間)に公開された「ChatGPT API」を活用した事例が早速生まれ始めている。LINE傘下で“キャラクター召喚装置”ことAIアシスタントデバイスを手掛けるGateboxが早速、同社オリジナルキャラ「逢妻ヒカリ」の会話エンジンとChatGPTを連携させた動画を公開した。 くら寿司が「AIカメラ」を全店舗に導入 相次ぐ迷惑行為対策に 不審な動きを検知、責任者へ即時連絡

くら寿司が「AIカメラ」を全店舗に導入 相次ぐ迷惑行為対策に 不審な動きを検知、責任者へ即時連絡

くら寿司は、回転レーンでの迷惑行為を防ぐ仕組みとして「新AIカメラシステム」を同日から全店舗で導入すると発表した。 Skeb、AI画像検出AIを導入 取り締まり強化へ 「AIはクリエイターを置換する技術ではない」

Skeb、AI画像検出AIを導入 取り締まり強化へ 「AIはクリエイターを置換する技術ではない」

クリエイターに有償でイラストなどを発注できるサービス「Skeb」を提供するスケブは、AIが生成した画像などのデータを検出するAIを導入したと発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR