GPT-4以上? 自分で何度も“推敲”し完成度を上げる言語生成AI「Self-Refine」:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

米カーネギーメロン大学、Allen Institute for Artificial Intelligence、米ワシントン大学、米NVIDIA、米UC San Diego、米Google Researchに所属する研究者らが発表した論文「Self-Refine: Iterative Refinement with Self-Feedback」は、大規模言語モデル(LLM)が、より高品質な出力を生成するために、反復的な改良と自己評価を利用することを可能にする新しいフレームワークを提案した研究報告である。

人間の問題解決の基本的な特徴である反復的な改良は、最初に草案を作成し、その後自己フィードバックによって改良するプロセスである。例えば、メールの文章でも何度も校正を行い、推敲することで仕上げる。

この研究では、LLMが反復的なフィードバックと改良を行うフレームワーク「Self-Refine」を提案することで、このような人間の認知プロセスを効果的に再現できるかを検証する。このアプローチは、先行研究とは異なり、教師ありの訓練データや強化学習を必要とせず、単一のLLMを使用する。

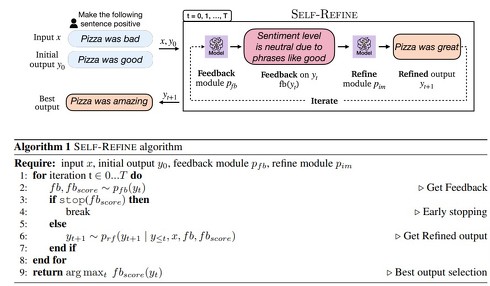

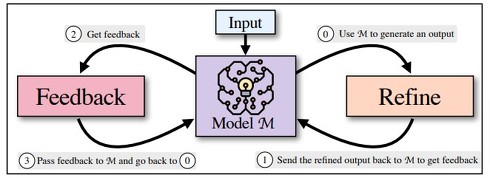

Self-Refineは、FeedbackとRefineの2つのコンポーネントによる反復ループで構成し、これらのコンポーネントが連携して高品質なアウトプットを生成する。モデルが生成した最初の出力案があると、それをFeedbackとRefineの2つのコンポーネントを何度も行き来し、何度も繰り返し改良する。このプロセスは、指定された回数、あるいはモデル自身がこれ以上の改良は必要ないと判断するまで、繰り返し行われる。

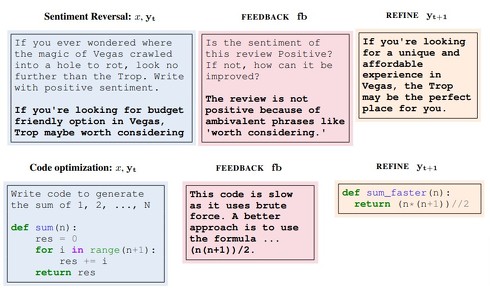

具体的には、初期出力を与えると、Feedbackはそれを評価し、修正に必要な実行可能なフィードバックを生成する。Refineは、そのフィードバックを考慮してアウトプットを改良する。これらを繰り返す。

Self-Refineは、最初に生成された出力(0)を、同じモデルM(1)に戻してフィードバックを得る(2)ことから始まり、最初の出力に対するフィードバックはモデルM(3)に戻され、以前に生成した出力を繰り返し改良(0)する

Self-Refineは、最初に生成された出力(0)を、同じモデルM(1)に戻してフィードバックを得る(2)ことから始まり、最初の出力に対するフィードバックはモデルM(3)に戻され、以前に生成した出力を繰り返し改良(0)する実験では、物語生成やコードの最適化、略語生成など7つのタスクで大規模なテストを行った。結果、Self-RefineがGPT-3.5やGPT-4などの強力な生成器からの直接生成よりも少なくとも5%、最大で40%以上向上することを示した。

Source and Image Credits: Madaan, A., Tandon, N., Gupta, P., Hallinan, S., Gao, L., Wiegreffe, S., … & Clark, P.(2023). Self-Refine: Iterative Refinement with Self-Feedback. arXiv preprint arXiv:2303.17651.

関連記事

「Pulumi AI」発表 自然言語でAWS、Azure、Cloudflare、Kubernetes、Datadogなど130以上のインフラやサービスのInfra-as-Codeを自動生成

「Pulumi AI」発表 自然言語でAWS、Azure、Cloudflare、Kubernetes、Datadogなど130以上のインフラやサービスのInfra-as-Codeを自動生成

自然言語からインフラ構成コードを自動生成する「Pulumi AI」が発表。AWS、Azure、Cloudflare、Kubernetes、Datadogなど130以上のサービスに対応する。オープンソースとしてコードも公開されている。 話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

画像生成AI「Stable Diffusion」開発元の日本法人代表ジェリー・チーさんに、企業での利用状況やビジネスモデル、クリエイターからの反応などについて、いろいろと聞いてみた。 ChatGPTのようなモデルを高速生成するツール、Microsoftが開発 「既存技術の15倍以上」うたう

ChatGPTのようなモデルを高速生成するツール、Microsoftが開発 「既存技術の15倍以上」うたう

米Microsoftが、ChatGPTのようなモデルを生成できるツール「DeepSpeed-Chat」を公開した。一般販売されているGPU1台で100億以上のパラメータを持つモデルの学習ができる上、学習速度も既存技術の15倍以上としている。 OpenAI・アルトマンCEOのプレゼン資料が公開 自民党に何を語ったか

OpenAI・アルトマンCEOのプレゼン資料が公開 自民党に何を語ったか

米OpenAIのサム・アルトマンCEOが自民党本部での会合で使ったプレゼン資料がネット上で閲覧可能になった。会合に出席した塩崎彰久衆議院議員が公開した。 「プロンプトエンジニアリング」の“教科書”、日本語版が登場 無償でAIの上手な使い方を解説

「プロンプトエンジニアリング」の“教科書”、日本語版が登場 無償でAIの上手な使い方を解説

ChatGPTなどのAIにより適切な指示を与える手法「プロンプトエンジニアリング」を解説した資料「プロンプトエンジニアリングガイド」の日本語版が無償公開中だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR