映像編集の“面倒くさい”をどんどんAIに Premiere Pro β版に搭載された、2つの新機能を試す:小寺信良の「プロフェッショナル×DX」(1/3 ページ)

2025年最初のニュースとして、AdobeはPremiere Pro、After Effectsのβ版およびFrame.ioの新機能を発表した。以前からAdobeは、映像制作ワークローにおけるAIの活用事例をPremiere Proに集約させており、24年には今後実装予定の機能を3つ発表している。そのうち「カットの続きを作る」機能は昨年のうちに実装された。

残る「Bロールを生成する」機能は24年11月のInter BEEの際に実動デモを、「不要なオブジェクトを消す」については、「不要なオブジェクトを自動で切り出す」ところまでの実動デモを拝見した。この1月に公開された25.20β(ビルド97)に実装されたAI関連機能はそのどちらでもないが、ユーザーからリクエストが多かった機能を先に実装したようだ。

今回は実際にこのβ版に搭載された機能を試しながら、今後の映像制作への変化について考えてみたい。

素材を分析し、検索可能にする「メディアインテリジェンス」

かつて編集者が映像編集を行う際には、素材全てに目を通し、メモを取る。昔はノートにカットのタイムコードとカットの概要、すなわち何が写っているか、1ショットなのがグループショットなのか、サイズはバストサイズなのか、カメラはどちらにパンするのかなどを書き込んでいた。

それを元に、ポスト・イットにカットの特徴を書き出し、壁に貼り付けて分類、グループ化し、関係性を把握したのち、番組の構成に沿って並び替える。いわゆる文化人類学のフィールドワークで用いられるKJ法をそのまま活用して、編集案を錬っていたわけだ。30分番組でも収録素材はその20倍ぐらいあるので、約10時間。メモを取りながら素材を全部見るだけで3日ぐらいかかる。

今でもそんなやり方をしている現場は少ないだろう。なぜならば多くの映像制作の現場で、撮影者と編集者が同じになってしまったからだ。これにより映像制作のスピードは格段に向上し、映像は小規模量産体制が整った。自分で撮影した映像をじっくりもう一度メモを取りがら見るというのは、ニュース特集やドキュメンタリーのように、自分が撮ったものがどういう意味を持つのか再考する必要があるコンテンツの場合ぐらいである。

とはいえ、撮影班が複数あるような大掛かりなプロジェクトでは、編集者が知らない素材が大量にあるという事になる。もちろん、こうした場合は昔ながらのKJ法は有効だが、今はとにかく手を動かして、早速作り始めてしまう編集者も多い。

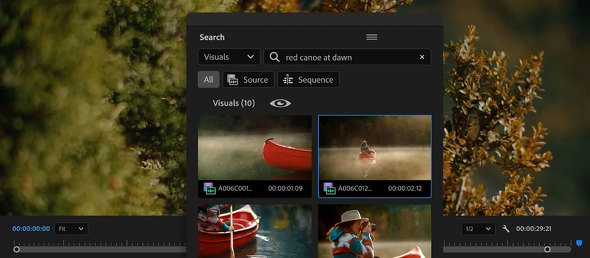

こうした手法で厄介なのは、使いたいカットがあるはずなのに見つからないことだ。現代の編集において、カットの存在はビン上にあるクリップのサムネイルから想起されるので、使いたいカットのイメージとサムネイルが全然違っている場合、見つけられなくなるということは起こりうる。仕方なく構成を変えて編集したら、ほとんど出来上がってから使いたいカットが見つかる。そうなると、それを入れるためには構成を変えなければならなくなる。

こうしたトラブルを避けるために、編集者は素材ビンの中でフォルダを作って分類したり、サムネイルカラーを分けたりしてなんとか区別を付けようとしてきたわけだが、もっともシンプルな解は、「検索して見つかれば良い」というものだ。

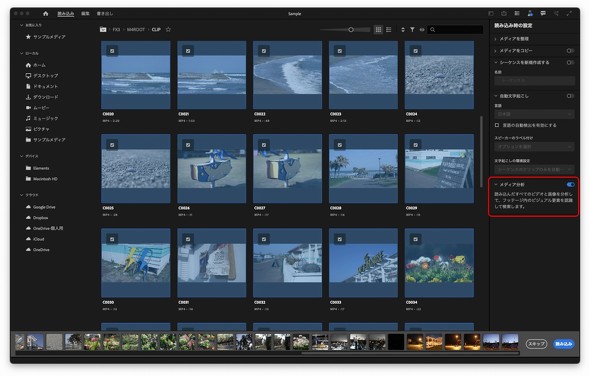

そのためには何らかのメタデータが必要になるわけで、大規模なプロジェクトの場合、素材を見ながらクリップにメタデータを入力していくという工程が発生する。実際に映画等ではこうしたワークフローになっているが、そうしたことをAIでやれないか、というニーズが出てくるのは、当然である。

今回のPremiere Pro 25.20βで追加されたAI関連の機能の一つが、それである。「メディアインテリジェンス」と名付けられた機能は、プロジェクト内に読み込まれた素材、あるいは新たにインジェストする素材に対して、AIによる分析をかける。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR