「Transformer」後継と期待される「RetNet」活用 PKSHAが日英対応の独自LLMを開発 日本MSも協力

AIベンチャー・PKSHA Technology(東京都文京区)は3月28日、「RetNet」技術を活用した日英大規模言語モデル(LLM)を開発したと発表した。RetNetを使用した日英モデルは世界初で、日本マイクロソフトの技術支援により実現。PKSHA Technologyの上野山勝也代表は「これによって生成AIの活用が一段前に進む」と自信を見せる。

左から、PKSHA Communication、PKSHA Workplaceの佐藤哲也代表、PKSHA Technologyの上野山勝也代表、日本マイクロソフト 執行役員 常務 最高技術責任者の野嵜弘倫さん、PKSHA Technology アルゴリズムエンジニア VPoEの森下賢志さん、PKSHA Technology アルゴリズムリードの稲原宗能さん

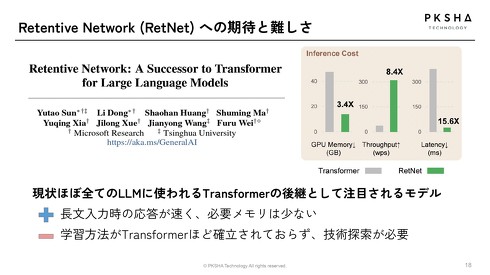

左から、PKSHA Communication、PKSHA Workplaceの佐藤哲也代表、PKSHA Technologyの上野山勝也代表、日本マイクロソフト 執行役員 常務 最高技術責任者の野嵜弘倫さん、PKSHA Technology アルゴリズムエンジニア VPoEの森下賢志さん、PKSHA Technology アルゴリズムリードの稲原宗能さん今回開発したLLMの最大の特徴であるRetNetとは「Retentive Network」の略称で、米Microsoft Researchが開発した技術だ。現在、LLMのアーキテクチャには「Transformer」が使われているのが主流だが、Microsoftは「RetNetはこの後継として期待される」と説明している。

RetNetは、Transformerと比べてより効率的にデータを処理できる。Transformerと比較したとき、GPUのメモリ消費が約3分の1、レイテンシは約15分の1に抑えられ、スループットは最大8倍速いという。このためRetNetを採用したLLMでは、必要なメモリを少なくしながら、長文入力時の応答速度の向上が見込めるとしている。

TransformerのLLMでは、入力文字数が増えていくことで文章の出力にかかる時間も比例して増えていく。一方、PKSHA Technologyが今回開発したLLMでは、文字数が増えても出力かかる時間はほぼ一定に。2万文字を入力したときの出力速度を比較すると、速度は約3.3倍上がり、応答時間にすると約70%削減できたとしている。

開発したLLMは70億パラメータで、コンタクトセンターや社内ヘルプデスクなどでの実装を視野に入れている。4月から段階的に実用化を開始する予定で、現在さらなる学習と言語性能のチューニングを進めているという。

同社のアルゴリズムエンジニア VPoEである森下賢志さんは「コンタクトセンターや社内ヘルプデスクにおけるLLM活用に当たって、これまでは3つの課題があった。1つは顧客の情報などをより多く入れたいという『長文入力』、2つ目に音声対話中でのリアルタイムでの対応を可能にする『応答速度』、3つ目により安く運用したいという『運用コスト』。この3つの課題を同時に解決できるポテンシャルを持っているのがRetNetで、期待が集まっている」と話す。

一方、RetNet自身にも課題はある。まだ実用的なレベルで社会では利用できていないため、Transformerほど学習方法が確立されていないという。より効率的な学習方法の探求や、RetNet自体の実用化に向けて、今後もPKSHA Technologyと日本マイクロソフトは協力し、研究開発を進めていく予定だ。

上野山代表は今回開発したRetNetLLMの精度について「どの物差しで測っていくかの問題だと思っている。われわれはビジネスニーズに必要十分に応えていく、というところで作っており、そういう意味で精度の向上に努めていきたい」と話し、他社製LLMとのベンチマークでの比較結果については明かさなかった。

「これ(RetNetLLM)によって生成AIの活用が一段前に進むと思っている。ビジネスにはさまざまな制約、上限がつきものだが、(LLMのビジネス活用において)“必要十分でかつ高性能”が欲しい場面でRetNetLLMは一役買うと考えている」(上野山代表)

関連記事

“子どもが不登校になる可能性”を予測するAI AIベンチャーのPKSHAなどが開発へ

“子どもが不登校になる可能性”を予測するAI AIベンチャーのPKSHAなどが開発へ

AIベンチャー・PKSHA Technologyは、子どもが不登校になる可能性を予測するAIを開発すると発表した。 Microsoft、AI部門新設 出資先Inflection AIのCEO(DeepMind共同創業者)引き抜き

Microsoft、AI部門新設 出資先Inflection AIのCEO(DeepMind共同創業者)引き抜き

Microsoftは、「Copilot」などのAI推進に重点を置く新部門「Microsoft AI」を立ち上げた。CEOと主任研究員として、昨年6月に出資したAI企業Inflection AIの共同創業者を迎える。2人は英DeepMindの共同創業者でもある。 iPhone、Googleの生成AI「Gemini」搭載か Appleが交渉中との報道

iPhone、Googleの生成AI「Gemini」搭載か Appleが交渉中との報道

米Appleは、米Googleの生成人工知能(AI)「Gemini」をiPhoneに搭載する方向で交渉を行っている。米Bloomberg Newsが3月18日、関係者の話として報じた。 NTT、大規模言語モデル「tsuzumi」を提供開始 “鼓”奏者も演奏で祝福 LLM開発競争をどう戦う?

NTT、大規模言語モデル「tsuzumi」を提供開始 “鼓”奏者も演奏で祝福 LLM開発競争をどう戦う?

NTTは3月25日、独自の大規模言語モデル(LLM)「tsuzumi」の商用提供を始めた。記者発表会には、その名の由来である楽器“鼓”の奏者も駆け付け、祝言の演奏を披露した。 KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDIは、東大発のAIスタートアップ企業であるELYZAを連結子会社にすると発表した。資本業務提携を結び、4月1日をめどにKDDIグループがELYZAの株式の過半数を保有する。これにより、同社らは「生成AIの社会実装を加速させる」としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.