AIを“AIで”改善 Sakana AIが新技術「AI CUDA Engineer」発表 目指すは100万倍の効率化

AIモデルの開発や利用を“AIによって”効率化する──Sakana AIは2月20日、新たな技術「AI CUDA Engineer」を発表した。AIモデルの開発や利用時にかかる計算処理を10〜100倍高速化できるエージェントシステム。同社は「AI技術は必ず100万倍は効率化される」と展望を示しており、この技術はそのための重要なステップだという。

米NVIDIA製のGPUハードウェアには、その並立計算を制御するためのプラットフォーム「CUDA」が用意されている。そこで肝となっているのは、ハードウェアに直接指示を行う「CUDAカーネル」という関数だ。この関数のレベルで、直接命令を記述できれば、AIアルゴリズムのパフォーマンスを向上させることが可能という。

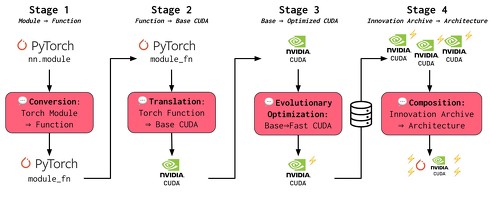

そこで同社は、CUDAカーネルの生成を自動化する技術として、AI CUDA Engineerを開発。最新の大規模言語モデル(LLM)を活用し、標準的なPyTorchコードを高度に最適化したCUDAカーネルへ自動で変換できるようにした。これにより、一般的なPyTorchよりも10〜100倍高速なCUDAカーネルを生成でき、最大500%高速なCUDAカーネルの生成も確認したという。

またAI CUDA Engineerは、一般的な機械学習において、PyTorchネイティブとコンパイルされたPyTorchコードよりも、10〜100倍高速化できるCUDAカーネルを安定して発見したという。これにより、機械学習アーキテクチャ全体を最適化したCUDAカーネルに変換することも可能。この結果は、GPUカーネルの性能評価指標「KernelBench」で最高水準の成果を記録した。

同社は同日、AI CUDA Engineerに関する論文と、AI CUDA Engineerによって生成した3万個以上のCUDAカーネルで構成したデータセット「AI CUDA Engineerアーカイブ」を公開した。同社は「このデータセットにより、オープンソースモデルの事後トレーニングにおいて、より高性能なCUDAモジュールを実行できるだろう」と説明している。

「今後AI技術は必ず100万倍は効率化される」

Sakana AIのデイビッド・ハCEOは、米Bloombergが2月に実施したインタビューで「昨今のLLMは現代の『メインフレームコンピュータ』である」と語っている。2025年現在のAIはまだ初期段階であり、市場競争とグローバルでのイノベーションによって「今後AI技術は必ず100万倍は効率化される」と考えを明かしている。

「シリコンバレーでは、AIは『勝者総取り』の技術で、既存モデルの規模を大きくし、より多くのリソースを費やすことがAIレースに『勝つ』ためには必要であり、そのためには今世代最大の投資が必要であるという物語が確立され、正当化すらされている。しかし、私はAIは勝者総取りの技術ではないと考えている。LLMは一般化、大幅に効率化し、全ての国で広く利用できるようになる」(デイビッド・ハCEO)

Sakana AIは「現代のAIシステムはGPUなどのハードウェアアクセラレータによる並列処理に大きく依存している」とし、この点は人間の脳と同じであると指摘している。一方で「エネルギーの制約下で効率的に動作するように進化してきた人間の脳とは異なり、最近のAI基盤モデルは、大規模化の方向に進んでいる」とも言及。推論時間やエネルギー需要が増え、AI技術の開発と展開のコストも指数関数的に増加していると述べている。

このような状況下から、同社は「現代のAIシステムは人間の脳と同じくらい効率的であるべきであり、その効率を達成するための最善の方法は、AIを使ってAIをより効率的にすること」と研究開発の方向性を示している。同社は以前にも、科学研究を自動化するAIシステム「AIサイエンティスト」を発表しており、AI CUDA Engineerの研究はこれに触発されたものだという。

関連記事

iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

AIベンチャーのSakana AIは、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」を開発し、これを利用し作成した。 科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

AIモデルを使って、科学研究を自動化できないか?──AIベンチャーのSakana AIは、そんな需要に対応するAIシステム「The AI Scientist」を発表した。 Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

AIベンチャー「Sakana AI」は、自然界の生物の「すみ分け」の仕組みをヒントに、小規模なAIモデル(AIエージェント)を複数育て上げ、それぞれが得意分野を持ちながら協力し合える新しい開発手法を提案した研究報告を発表した。 生成AIベンチャー・Sakana AI、米NVIDIAなどから1億ドル超を調達

生成AIベンチャー・Sakana AI、米NVIDIAなどから1億ドル超を調達

AIベンチャーのSakana AIは米NVIDIAから出資を受けると発表した。 Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

AIスタートアップのSakana AIは、複数の画像について日本語で質疑応答できるAIモデル「Llama-3-EvoVLM-JP-v2」を発表した。

Copyright © ITmedia, Inc. All Rights Reserved.