OpenAI、ChatGPTに「休憩しませんか?」リマインダー機能追加 健全な利用を促進

米OpenAIは8月4日(現地時間)、「ChatGPT」のユーザーの健全な利用と目標達成を支援するため、ユーザーに休憩を促す機能の追加など、利用体験の最適化に取り組んでいると発表した。ユーザーの健全な利用を支援し、特に精神的または感情的な苦痛を経験している可能性のある個人に対する対策を強化する取り組みとしている。

OpenAIによると、ChatGPTはユーザーの注意を長時間引きつけることではなく、ユーザーが目的を達成し、日常生活に戻れるよう支援するツールとして設計されているという。製品として目指すのは、費やされた時間の長さやクリック数ではなく、ユーザーが目的を達成したかどうかであり、ユーザーが定期的に利用に戻ってくるかどうかも重視している。

例えば、上司との難しい会話への準備支援、検査結果の理解、思考の整理など、ユーザーが成長し、新たな知識を学び、問題を解決するのを支援することが、ChatGPTの目的という。

OpenAIは、製品に費やす時間が少ないほど、その効果があったことの表れであると考えており、「ChatGPT agent」のような新機能によって、他のアプリを開かずに目標を達成できるようになることもその一例だとしている。

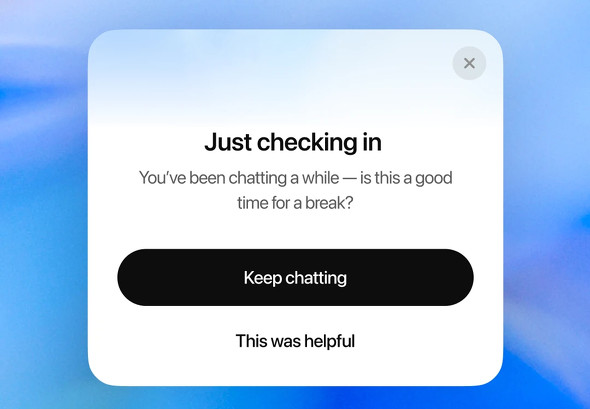

具体的な対策として、ユーザーが時間をコントロールできるよう、長時間のセッション中に休憩を促す“優しいリマインダー”を表示するようにした。

「ちょっと確認するだけです。しばらくチャットしていますね、少し休憩したらいかがですか?」というメッセージが表示されるが、そのままチャットを続ける選択ができるようになっている。

また、以前モデルがあまりにも共感的になりすぎ、実際に役立つ情報ではなく、聞こえの良い情報ばかりを答えてしまうことがあってロールバックしたが、ChatGPTは根拠に基づいた正直な応答をするよう訓練されており、精神的または感情的な苦痛の兆候をより適切に検出し、必要に応じてエビデンスに基づいたリソースを提示できるよう、改善を進めている。

さらに、「彼氏と別れるべきか?」のような個人的な意思決定について尋ねられた場合、直接的な答えを与えるのではなく、ユーザーに質問したり、(別れる)メリットとデメリットを整理したりすることで、考えることを支援する新しい対応を間もなく展開する予定だ。

OpenAIはこれらの取り組みを進める上で、特に精神的または感情的な苦痛の兆候を示すような状況におけるChatGPTの応答を改善するため、専門家と密接に連携しているという。

この取り組みは現在も進行中であり、OpenAIは「自分の大切な人がChatGPTに支援を求めても安心していられるかという問いに、はっきりイエスと答えられるようにすることがわれわれの使命だ」としている。

ここ数カ月、AIチャットボットの長時間利用の問題についての記事(The New York Timesなど)が複数公開されていた。OpenAIと競合する米Anthropicは6月、生成AIモデルの「Claude」が感情的な会話で利用されている実態を調査した結果を公開し、研究を進めていくと説明した。

関連記事

Anthropic、AIの「感情的利用」調査結果を公開 対策も提示

Anthropic、AIの「感情的利用」調査結果を公開 対策も提示

Anthropicは、AI「Claude」の感情的な利用に関する調査結果を公開した。感情的な会話は全体の約3%と稀だが、内容は多岐にわたる。会話を通じてユーザーの感情が肯定的になる傾向が見られるが、AIを専門家の代替とはせず、安全対策を進める。 GPT-4o、“お世辞を言い過ぎて”ロールバックされる ChatGPTが人間にこびてはいけないワケは?

GPT-4o、“お世辞を言い過ぎて”ロールバックされる ChatGPTが人間にこびてはいけないワケは?

GPT-4oがお世辞を言い過ぎたのでロールバックした──米OpenAIは、そんな発表をした。 ChatGPT利用と孤独感の関係性──OpenAIとMITが共同研究結果を発表

ChatGPT利用と孤独感の関係性──OpenAIとMITが共同研究結果を発表

OpenAIとMITメディアラボは、ChatGPTなどのAIチャットbotの利用が人間に与える影響についての研究結果を発表した。利用時間の長さと孤独感の増加に相関関係があることなどが明らかになったとしている。 「ちいかわ」作者も、寝る間を惜しんでChatGPTを使ってる 漫画に“生成AI回”

「ちいかわ」作者も、寝る間を惜しんでChatGPTを使ってる 漫画に“生成AI回”

クリエイターによる生成AI活用が広がる昨今。漫画「ちいかわ なんか小さくてかわいいやつ」作者のナガノさんも、ChatGPTに相談事をしているようだ。ナガノさんは自身のXアカウントで、ChatGPTとのやりとりなどについてつづった漫画を投稿した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.