Google、PC操作を自動化するAI「Gemini 2.5 Computer Use」のプレビュー版公開

米Google DeepMindは10月7日(現地時間)、「Gemini 2.5 Pro」の視覚理解力と推論能力を基盤として特別に構築されたAIエージェントモデル「Gemini 2.5 Computer Use」を、APIを通じてパブリックプレビュー公開したと発表した。

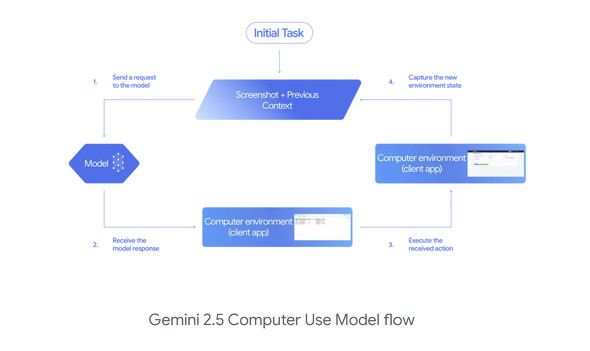

このモデルは、ユーザーからの自然言語による指示と、画面のスクリーンショットをインプットとして受け取る。モデルは、画面上の要素を視覚的に認識し、ユーザーのリクエストを分析し、次に何をすべきかを判断し、マウスクリック、スクロール、タイピング、フォームへの入力といった具体的なUIアクションを、`function_call`という関数呼び出しの形で生成する。この一連のプロセスは、アクション実行後に新しいスクリーンショットをモデルに送り返すエージェントループの中で繰り返され、タスクが完了するまで自律的に操作を続行する。これにより、人間がマウスやキーボードで行う操作のほぼ全てを模倣し、代行することが可能になる。

このモデルを利用することで、様々なデジタルタスクの自動化が可能になる。具体的な例として、Webサイト上での繰り返しのデータ入力やフォームへの入力を自動化する機能や、複数のEコマースサイトを横断し、製品情報、価格、レビューなどを収集して購入決定のためのリサーチを行うといった作業の代行が挙げられる。

公式ブログでは「美術部がフェアに向けて課題をブレインストーミングした。ボードがごちゃごちゃしているので、私が作ったカテゴリーに課題を整理するのを手伝ってほしい。sticky-note-jam.web.appにアクセスして、メモが適切なセクションにきちんと配置されているか確認して。もし違っていたら、ドラッグして」という複雑な指示に対する実行結果を動画で紹介している。

このモデルは、同日からパブリックプレビューとして提供されており、開発者はGemini APIを通じて、Google AI StudioやVertex AIといったプラットフォームでアクセスが可能だ。主にWebブラウザでの利用に最適化されているが、モバイルUI制御タスクにおいても高い可能性を示している。

Google社内では、すでにUIテストを含む様々なユースケースで実運用されており、特に「Project Mariner」の機能や「Firebase Testing Agent」、Google検索の「AIモード」における一部のエージェント機能にも利用されてきた実績がある。

ただし、本モデルはプレビューモデルであるため、エラーやセキュリティ上の脆弱性が発生する可能性があり、特に重要なタスクについては厳重な監視が推奨されている。また、購入や機密情報に関わる高リスクなアクションについては、開発者が「Human-in-the-Loop(HITL)」としてユーザーに明示的な確認を求める仕組みを実装することが義務付けられている。

関連記事

Google DeepMind、コードの脆弱性を自動修正するAIエージェント「CodeMender」発表

Google DeepMind、コードの脆弱性を自動修正するAIエージェント「CodeMender」発表

Google DeepMindは、脆弱なコードを自動で検出して修正するAIエージェント「CodeMender」を発表した。Geminiの推論能力を活用し、脆弱性の発見から修正までの時間を短縮する。サイバー攻撃に対抗し、AIを防御に活用する戦略の一環で、オープンソースエコシステムの安全向上を目指す。 Google、「Nano Banana」(Gemini 2.5 Flash Image)を本番環境で提供開始

Google、「Nano Banana」(Gemini 2.5 Flash Image)を本番環境で提供開始

Googleは、画像生成AIモデル「Nano Banana」を一般公開し、開発者向けモデル「Gemini 2.5 Flash Image」を本番環境で利用可能にしたと発表した。このモデルは、既に50億件以上の作品を生み出しているという。開発者向けでは多様なアスペクト比に対応するなど、新機能も追加された。 Google 検索の「AIモード」が日本語に対応 Gemini 2.5活用で長文質問も可能に

Google 検索の「AIモード」が日本語に対応 Gemini 2.5活用で長文質問も可能に

GoogleのAI検索機能「AIモード」が日本語に対応、9月9日から段階的に展開開始。従来の検索では答えにくい長い質問や複雑な問いに対し、複数検索を同時実行してAIが統合回答を提供する。本棚の写真から書籍推薦するなど画像検索にも対応し、検索体験が大きく進化する。 「Gemini 2.5 Pro」で「Deep Research」利用可能に

「Gemini 2.5 Pro」で「Deep Research」利用可能に

Googleは、思考するAI「Gemini 2.5 Pro(Exprimental)」でリサーチアシスタント「Deep Research」を利用できるようにした。「Gemini Advanced」ユーザーが対象だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.