複数人の会話から特定の1人だけを音声識別する手法 米NVIDIA「CONF-TSASR」開発:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米NVIDIAの研究者らが発表した論文「Conformer-based Target-Speaker Automatic Speech Recognition for Single-Channel Audio」は、複数人が同時に話す環境で特定の話者だけの音声を分離して識別する手法を提案した研究報告である。

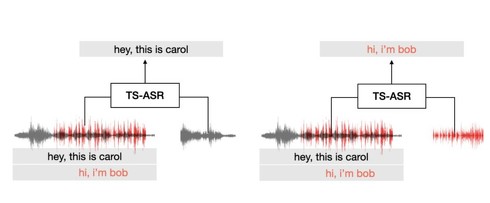

話者プロファイルと補助発話(ターゲット話者)が与えられた重複多話者環境において、「単一チャネル話者自動音声認識」という特定の話者の発話を書き起こすタスクがある。この研究では、エンド・ツー・エンドの単一チャネル話者自動音声認識「CONF-TSASR」を提案する。

このモデルは、TitaNetベースの話者埋め込みモジュール、Conformer(TransformerとCNNを組み合わせたモデル)ベースのMaskNet、ASRモジュールから構成される。TitaNetは目標話者の補助発話から話者埋め込みを抽出する。MaskNetはConformerを使用して、ターゲット話者の時間周波数マスクを生成する。

ASRモジュールはConformerを使用して、マスクされた音声の特徴を書き起こす。これらのモジュールは、他の話者からの音声を無視しながら、ターゲット話者の音声を書き取るように共同で最適化される。

モデルはConnectionist Temporal Classification(入力音声データと出力する音素数のズレを調整する)ロスと、対象話者の個々のスペクトログラムロスを用いて学習する。

その結果、WSJ0-2mixextr(4.2%)において、最先端のターゲット話者の単語誤り率(TS-WER)を達成した。さらに、WSJ0-3mix-extr(12.4%)、LibriSpeech2Mix(4.2%)、LibriSpeech3Mix(7.6%)データセットにおけるTS-WERを報告し、TS-ASRの新たなベンチマークを確立した。

このモデルは、完全に重なった音声と部分的に重なった音声の両方に使用できる。提案モデルはNVIDIA NeMoツールキットを通じてオープンソース化される予定。

Source and Image Credits: Yang Zhang, Krishna C. Puvvada, Vitaly Lavrukhin, Boris Ginsburg. Conformer-based Target-Speaker Automatic Speech Recognition for Single-Channel Audio

関連記事

音声アシスタントに入力中、横から“聞こえない音”で攻撃 指示を勝手に変更 中国チームが開発

音声アシスタントに入力中、横から“聞こえない音”で攻撃 指示を勝手に変更 中国チームが開発

中国の浙江大学に所属する研究者らは、ユーザーが音声アシスタントに音声入力している際に横から不可聴音の悪意ある音声を混ぜて異なる入力内容に変更する攻撃を提案した研究報告である。 円谷プロ、「ウルトラセブン」の音声合成AIを開発 「モロボシ・ダン」「友里アンヌ」の声を再現

円谷プロ、「ウルトラセブン」の音声合成AIを開発 「モロボシ・ダン」「友里アンヌ」の声を再現

円谷プロダクションは、1967年放送の特撮ドラマ「ウルトラセブン」に関する音声生成AIを開発したと発表した。 耳の穴に入れる、らせん状の脳波計測器 脳とコンピュータを接続 中国の研究者らが開発

耳の穴に入れる、らせん状の脳波計測器 脳とコンピュータを接続 中国の研究者らが開発

中国の清華大学などに所属する研究者らは、装着者の内耳を通して人間の脳をコンピュータに接続できる非侵襲的なインタフェースを提案した研究報告を発表した。 AIが住む町の日常を“テレビ番組化”するAI 「イーロン・マスク」名乗るキャラも登場 米国チームが発表

AIが住む町の日常を“テレビ番組化”するAI 「イーロン・マスク」名乗るキャラも登場 米国チームが発表

映像制作会社の米The Simulation(旧Fable Studio)に所属する研究者らは、テキストプロンプトに基づいてテレビ番組のエピソードを自動生成するAIショーランナーを提案した研究報告を発表した。 「マイクのいらない会議室」ゼンハイザーが公開 もう誰かが走り回らなくていい、その仕組みとは?

「マイクのいらない会議室」ゼンハイザーが公開 もう誰かが走り回らなくていい、その仕組みとは?

世界を代表するマイクメーカーであるゼンハイザーが、マイクのいらない会議室を発表しました。どういうことでしょう。実際に見てきました。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR