新型iPhone、4機種を先行レビュー ボディ、発熱、バッテリーなど試して分かった“共通の設計思想“とは(4/4 ページ)

「ライブ翻訳」は“使い物”になるのか?

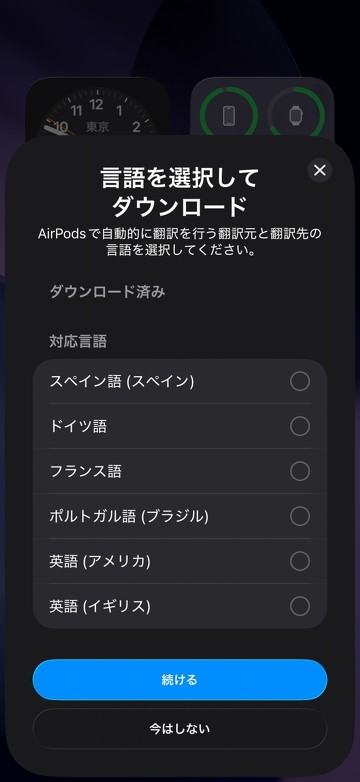

iOS 26の新機能であり、翻訳処理はiPhoneの中のApple Intelligenceが行う。AirPodsと連動し、相手の声をAirPodsのマイクで聞き取ってiPhoneが翻訳している。新機種のAirPods Pro 3だけでなく、AirPods 4やAirPods Pro 2でも動作する。

AirPodsが必須となっている理由は、翻訳する相手の声を正確に取り込むため、AirPodsの備えるモーションセンサーを使っているからだ。頭の向きから正面を把握、その方向にいる人の声を中心に翻訳する。だから、複数人がいる場合であっても、顔をそちらに向けることで「その人の話を中心に翻訳」できる仕組みなのだ。単に音をやりとりするのではなく、そういう細かな制御をiPhoneとの間で行う関係から、AirPodsの利用が必須となっている。また、周囲の音を取り込む「外音取り込み」機能も必須。この制御が改善されているので、新機種のAirPods Pro 3ではもっとも体験が良くなる。

現状、ライブ翻訳は英語・スペイン語などでの対応が先行しており、日本語での対応は年内になる。

今回、Appleでの取材中、日本語でのライブ翻訳も体験できた。翻訳の精度は100%ではなく、人間の同時通訳の方がもちろんクオリティは高い。だが、ほとんどの会話を数秒以内のラグで翻訳できており、かなり有用な機能だと感じた。イメージとしては、テレビのニュースなどで流れる、相手の声に翻訳が重なるボイスオーバーという手法に近い。Apple Intelligence対応の機種であれば、これがソフトウエアのアップデートだけで実現でき、利用もずっと無料であるのは大きい。翻訳アプリなどを作っている企業にとっては、かなり強力なライバルになるだろう。

こうしたAI機能が増えていくなら、性能はもっと必要になる。そこで、発熱や動作時間のリスクを避けていくことも大切だ。

今回のiPhone発表では、AIの話はライブ翻訳くらいしか出てこなかった。しかし、実機とライブ翻訳の組み合わせを見ると、実は今年のiPhoneが相当にApple Intelligenceの活用を意識した製品であるのがわかる。

ハードの設計と準備には長い期間が必要だが、Appleはまさに今後を見越して、設計変更という準備を進めていたということだろう。

【追記:2025年9月18日午前0時】各種ベンチマーク結果を追記しました。

関連記事

iPhone 17、日本版はSIMカードがささりません eSIMオンリーにSNSは「移行が不安」とざわつきも

iPhone 17、日本版はSIMカードがささりません eSIMオンリーにSNSは「移行が不安」とざわつきも

米Appleが発表した薄型の「iPhone Air」や、新型「iPhone 17」シリーズの日本語版は、全モデルでSIMスロットを搭載せず、遠隔で契約情報を書き込める「eSIM」のデュアル構成を採用した。ただ、現在SIMカードを使っている人が17シリーズやAirに機種変更する場合、eSIMに移行する手間が生じる可能性もあり、混乱が予想される。 今年のiPhoneは「薄い」だけじゃない 実機に触れて分かった“Appleの戦略“と”隠れたAI”とは?

今年のiPhoneは「薄い」だけじゃない 実機に触れて分かった“Appleの戦略“と”隠れたAI”とは?

今年も米Appleが新製品群を発表した。当然ながら、注目は薄型の「iPhone Air」だろう。だが、それ以外からもAppleの戦略は色々見えてくる。今回出たものを現地で触りつつ、「出なかったもの」も考えながら、今のAppleの戦略を分析してみたい。 「iPhone 17」以外に何が出た? Appleのオンラインイベントで発表されたハードウェアまとめ

「iPhone 17」以外に何が出た? Appleのオンラインイベントで発表されたハードウェアまとめ

Appleが9月9日のイベントで発表した新製品ラインアップを簡単に紹介する。iPhoneは「17」「17 Pro/Pro Max」に加え、薄型の「Air」が登場。Apple Watchは「Series 11」「SE 3」「Ultra 3」。3年ぶりに「AirPods Pro 3」も発表され、全製品が9月19日に発売される。 日本でも公開された「Apple Intelligence」 キモは“要約”にあり オンデバイスAIだからできること

日本でも公開された「Apple Intelligence」 キモは“要約”にあり オンデバイスAIだからできること

4月1日、日本でもApple Intelligenceが広く使えるようになった。重要なのは、「そこでなにが便利なのか」という点だ。Apple Intelligenceの機能を紹介する記事は多いが、実は「それなりに長く使ってみないと価値が見えてこない」ものもある。そしてそれは、現時点でのApple Intelligenceにおける、最大の価値でもあったりする。 「Apple Intelligence」でChatGPTが使えるように iPhone・iPad・Macで、Siriから直接アクセス

「Apple Intelligence」でChatGPTが使えるように iPhone・iPad・Macで、Siriから直接アクセス

米AppleのAI機能「Apple Intelligence」で、ChatGPTと連携できるようになった。iPhoneやiPad、MacでSiriから直接ChatGPTにアクセスできる。ChatGPTのアカウントがなくとも利用可能で、既存ユーザーのアカウントログインにも対応する。なお、Apple Intelligenceは現在英語のみで利用できるため、日本で利用する際には言語設定を変更する必要がある。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR