生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた(3/3 ページ)

──じゃあ、GPUはもういらなくなるんですか?

椎橋:いえ、そんなことはないですね。

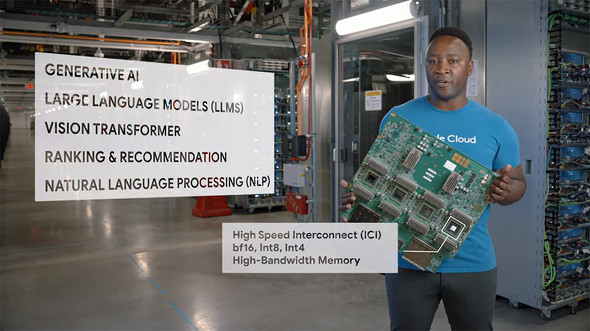

短期から中期でみると、学習にはGPUが引き続き重要な役割を果たします。また、推論においても、今回のBitNetの様に特定のアーキテクチャが固まったら、それに特化したチップを設計するのが良いでしょう。でも、研究開発の段階では、いろいろなアーキテクチャを探索する必要がありますよね。その際は、GPUやTPU(Googleの行列計算に特化したAIチップ)のような汎用的な計算資源がまだまだ必要とされるんです。

NVIDIAもAIの半導体分野を起点にビジネス展開しています。いまのNVIDIAのポジションから見ると、重要なプレイヤーであり続ける可能性は高いと思いますよ。

ただし同時に、今回のような特定のニューラルネットのアーキテクチャに対して、GPUを劇的に上回る計算効率を実現するようなAIチップが数多く生まれてくるのではないかという「AIチップのカンブリア爆発」の可能性が語られるようにもなってきています。

論文中でも、GroqというLLMの推論に特化したLPU(Language Processing Unit)の登場に触れられています。次世代半導体での復活を狙う日本の産業にとっても、注視していくべきトピックではないかと思います。

──学習にはGPUが必要なんですね。学習も1bitではできないんですか?

椎橋:実は学習は基本的にいままでと変わらないやり方が必要になります。学習にはGPUを使って、16bitとかの浮動小数点数演算をしないといけないんです。さらに、何も考えずに普通に学習したモデルを、あとから1bitに丸めてもあまりうまくいかないんですよ。

ディープラーニングの学習のときは、誤差逆伝播という手法を使います。入力からニューラルネットを通って出力が出ますよね。そのあと、教師データとの差を見て、その差を小さくするように逆向きに伝播させていきます。そのとき、どの層のパラメータをどのくらい更新するべきかを、傾きを計算して決めていきます。その傾きを勾配と呼ぶんですが、勾配を計算するには、小数値である必要があるんです。

だから、1bit LLMの学習には新しい工夫が必要になります。最終的に1bitに丸めることを前提として学習を行うんです。学習の途中でも、1bitに量子化した状態で出力を計算して、正解とどれだけずれているかを見て、そのずれを逆伝播させるんです。

ちょっと分かりにくいかもしれないのでイメージとして近い例を挙げますね。画像をモザイク化する場合を考えてみましょう。モザイクの一区画に入るピクセルの色の平均を取るのは、丸めているのと同じようなことですよね。ここで、人が見たときに何の画像か分かるようなモザイク画を作ってくださいと言われたとします。これが、学習だと考えてください。

出来上がったモザイク画を見て、元の画像が何か分かるかな? っていうのを考えるわけです。最終的にモザイク化されることを念頭に置いて、そのモザイク画から推測しやすいような元の画像を作るにはどうしたらいいか、というのが1bit LLMの学習における発想なんです。

──1bitまで丸めてもうまくいくなんて信じられないですが、本当にできるんですか?

椎橋:そうなんですよ。3値までまるめてうまくいくなんて、直感的にはあり得ないと思うんです。私も最初は半信半疑でした。

でも、パラメータ数がものすごく多いと、1bitになっていてもちゃんと機能するのかもしれません。1bit LLMの論文では、7億から700億パラメータのモデルを検証しているんですが、実際にパラメータ数が多くなると16bitのモデルと精度差が小さくなり、30億パラメータでBitNet b1.58が16bitのモデルを上回る結果になっています。

パラメータ数が膨大になると、1bitでもモデル全体としての表現力が十分になるのかな、と思えてきます。

とはいえ、やはり学習時の工夫は必要不可欠です。量子化を前提とした学習をするからこそ、うまくいっているんだと思います。

まだまだ発展途上の技術ではありますが、将来の可能性を感じさせるブレークスルーだと私は考えています。

関連記事

機械に話しかけて設定できる時代が来る? なぜ“小規模”なLLMが求められるのか

機械に話しかけて設定できる時代が来る? なぜ“小規模”なLLMが求められるのか

LLMにおいて、学習パラメータ数は性能に直結する。一方で、注目を集めているのがLLaMaのような小規模なモデルだ。それはなぜか。 なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

日本では今、スパコン「富岳」を使ってLLMの研究・開発を進めている。深層学習においてはGPUを使うのが一般的だが、なぜGPUのない富岳を使うのか。そこには現実的な理由があった。 NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NECは、独自の日本語大規模言語モデル(LLM)を開発したと発表した。パラメータ数は130億で、クラウド/オンプレミス環境での運用も可能。性能面でも、世界トップクラスの日本語能力を実現しているという。 Apple、iPhone上でのLLM実行を可能にする手法の論文を発表

Apple、iPhone上でのLLM実行を可能にする手法の論文を発表

Appleは「LLM in a flash:Efficient Large Language Model Inference with Limited Memory」という論文を発表した。メモリ容量が限られた端末上でLLMを実行するための革新的な手法を編み出したとしている。 東京発・AIドリームチーム「Sakana.ai」が45億円調達 元Googleトップ研究者らが設立 AI業界の著名人や日本の大手IT企業も出資

東京発・AIドリームチーム「Sakana.ai」が45億円調達 元Googleトップ研究者らが設立 AI業界の著名人や日本の大手IT企業も出資

元米Googleの著名な研究者、リオン・ジョーンズ氏とデビッド・ハー氏が東京で立ち上げたAI企業Sakana.aiが、シリコンバレーのベンチャーキャピタルやNTTグループ、KDDI、ソニーグループなどから45億円の資金を調達したと発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.