“学習データも全てオープン”なLLM、NIIが公開 GPT-3級モデルのプレビュー版

国立情報学研究所(NII)は9月17日、パラメータ数約1720億の大規模言語モデル(LLM)のプレビュー版「LLM-jp-3 172B beta1」を公開した。NIIが開発するLLMは、データをフルスクラッチで学習しており、AIモデルの他に学習データもオープンになっているのが特徴。プレビュー版モデルは、学習データの約3分の1までを学習した段階のものになる。

今回公開したLLMのパラメータ数は約1720億で、米OpenAIのLLM「GPT-3」と同程度の規模。ベースモデルは米MetaのLLM「LlaMA-2」を使った。

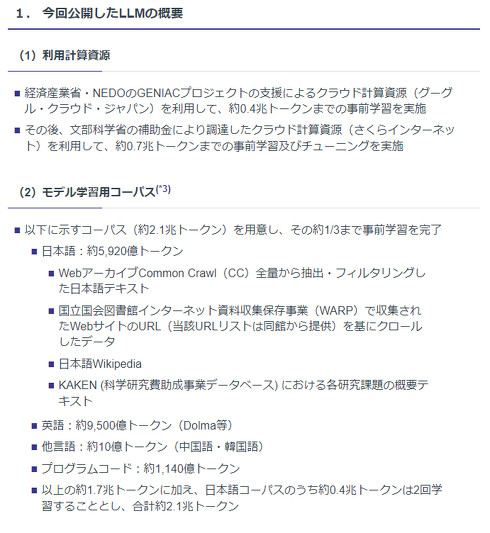

学習用データには、約2.1兆トークン(おおよそ単語数の意)のデータを用意。そのうち日本語は約5920億トークンで「WebアーカイブCommon Crawl(CC)全量から抽出・フィルタリングした日本語テキスト」「国立国会図書館インターネット資料収集保存事業(WARP)で収集されたWebサイトのURLを基にクロールしたデータ」「日本語Wikipedia」「KAKEN(科学研究費助成事業データベース)における各研究課題の概要テキスト」を利用した。

この他に、英語を約9500億トークンや、中国語や韓国語などの他言語を約10億トークン(中国語・韓国語)、プログラムコードを約1140億トークンを学習。ここまでの約1.7兆トークンのデータに加えて、日本語学習データのうち約4000億トークンは2回学習しており、学習データの合計は約2.1兆トークンとなる。

なお、プレビュー版モデルは約2.1兆トークンのうち、約3分の1までの事前学習を終えたものとなる。12月ごろには、2.1兆トークン全てを学習したAIモデルも公開する予定。

関連記事

NII、「日本の判例HTMLデータ」研究者に無償提供 約6万5000件の判例収録

NII、「日本の判例HTMLデータ」研究者に無償提供 約6万5000件の判例収録

国立情報学研究所(NII)は、最高裁判所が公開している判例集のPDFデータをテキスト化した「日本の判例HTMLデータ」の提供を、研究者向けに始めた。 NII、130億パラメータのLLM構築 コーパスなども全公開 「今後の研究に資するため」

NII、130億パラメータのLLM構築 コーパスなども全公開 「今後の研究に資するため」

NIIは、パラメータ数130億の大規模言語モデル(LLM)「LLM-jp-13B」を公開した。アカデミアや産業界の研究開発に資するため、コーパスやツールなどを含めてすべてオープンにする。 なぜAIに“日本語”を学習させるのか? 35種類のLLMで実験し分析 東工大などが研究報告

なぜAIに“日本語”を学習させるのか? 35種類のLLMで実験し分析 東工大などが研究報告

第261回自然言語処理研究発表会において、東京工業大学と産業技術総合研究所に所属する研究者らは、大規模言語モデル(LLM)に日本語を学習する効果について実験結果を基に評価した研究報告を発表した。 シャープが“首にかけられる生成AI”開発 NECらも協力、2025年度の実用化目指す

シャープが“首にかけられる生成AI”開発 NECらも協力、2025年度の実用化目指す

シャープは、ウェアラブルデバイス「AIスマートリンク」を開発したと発表した。首にかけられるデバイスで、音声によって生成AIとコミュニケーションを取ることが可能。2025年度中の実用化を目指す。 “著作権への配慮を徹底した”画像生成AI、日本のAIベンチャーが公開 日本語対応で商用利用OK

“著作権への配慮を徹底した”画像生成AI、日本のAIベンチャーが公開 日本語対応で商用利用OK

画像生成AIの開発を手掛けるAI Picassoは、学習に対する透明性が高い画像生成AI「CommonArt β」を公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.