米Netflixの動画生成AI「Go-with-the-Flow」 動画内のキャラをイメージ通りに動かせるアプローチ:Innovative Tech(AI+)

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米Netflixなどに所属する研究者らが発表した論文「Go-with-the-Flow: Motion-Controllable Video Diffusion Models Using Real-Time Warped Noise」は、生成する動画内のオブジェクトの動きやカメラワークを、思い通りかつ直感的に制御できる手法を提案した研究報告である。

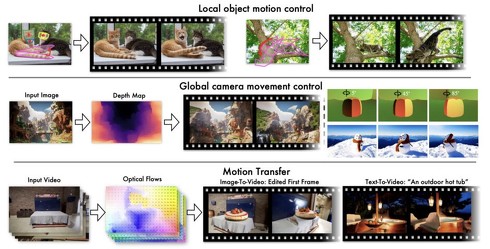

この技術により、例えば、犬の頭部だけを回転させたり、特定のオブジェクトを指定した経路で移動させたりなどの動画内の特定のオブジェクトの動きを自由に制御できる。またパンやチルト、ズームなどのカメラワークを自在に操ることが可能になる。さらに、既存の動画から動きのパターンを抽出し、別の動画に転写できる。

Go-with-the-Flowができること 1つ目は、動画内の特定のオブジェクトや、その一部分だけを選択して動きを自在に操作可能 2つ目は、カメラワークの制御で、パンやズームなどカメラの動きを自由に設定できる 3つ目は、既存の動画から動きのパターンを抽出し、それを別の新しい動画に転写して活用できる

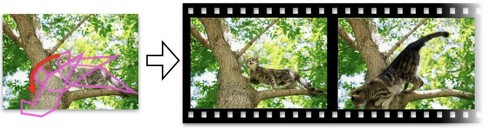

Go-with-the-Flowができること 1つ目は、動画内の特定のオブジェクトや、その一部分だけを選択して動きを自在に操作可能 2つ目は、カメラワークの制御で、パンやズームなどカメラの動きを自由に設定できる 3つ目は、既存の動画から動きのパターンを抽出し、それを別の新しい動画に転写して活用できる動画内のオブジェクトの動きを制御する場合、まず画面上で多角形を描いて特定の物体や領域を選択し、次にその部分に対して移動・回転・拡大縮小といった動きを指定する。さらに、視差効果を利用して異なる速度で動く複数の多角形を重ね合わせることで、3D的な動きの表現も可能である。

カメラの移動制御に関しては、既存の動画から抽出したオプティカルフローパターンを活用する手法を採用している。これにより、参照となる動画のカメラワークを、新しく生成する動画に適用できる。モーション転送の機能では、3Dレンダリングエンジンや深度情報など、多様な動きの情報源を活用可能だ。

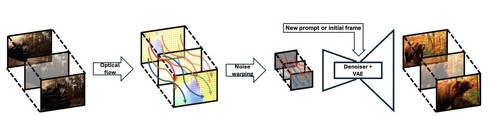

従来の動画生成AIでは動きを制御するためにAIモデル自体を大幅に改変する必要があったが、この手法では生成過程で使用するノイズを加工するだけで実現できる。

具体的な仕組みは、動画のフレーム間の動きを検出し、その情報を使ってノイズを変形させる。研究チームはこの処理を高速に実行できる新しいアルゴリズムを開発。これにより画質を損なうことなく、自然な動きを表現することに成功した。

研究チームは、この技術を最新の動画生成モデルであるCogVideoXやAnimateDiffに実装し、その効果を検証した。評価実験では、生成された動画の画質、動きの制御精度、時間的な一貫性の全てにおいて、既存の手法を上回る結果を示している。局所的なオブジェクトの動き制御では82%、カメラワーク制御では90%のユーザーが、この手法を他の手法より優れていると評価している。

Source and Image Credits: Burgert, Ryan, et al. “Go-with-the-Flow: Motion-Controllable Video Diffusion Models Using Real-Time Warped Noise.” arXiv preprint arXiv:2501.08331(2025).

関連記事

iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

AIベンチャーのSakana AIは、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」を開発し、これを利用し作成した。 デスクトップに常駐するAIアシスタントキャラ技術 カメラで現実世界を認識・ビデオ会議に参加も可能 NVIDIAから

デスクトップに常駐するAIアシスタントキャラ技術 カメラで現実世界を認識・ビデオ会議に参加も可能 NVIDIAから

PCのデスクトップに常駐し、ユーザーの指示に従うAIアシスタントキャラクター技術「Project R2X」を、NVIDIAが発表した。口頭で文章の要約や解説を指示できる他、カメラを通して現実世界を認識したり、ビデオ会議に参加したりできるという。デモ映像も公開した。 “猫の頭すりすり”を再現したロボット、筑波大学が開発 人間への癒し効果はあるか?

“猫の頭すりすり”を再現したロボット、筑波大学が開発 人間への癒し効果はあるか?

筑波大学に所属する研究者らは、猫が頭をすり寄せる動作(bunting)を模倣したロボットを開発し、そのいやし効果を検証した研究報告を発表した。 AIで原子を自在に操る、次世代の量子コンピュータ向け新技術 中国の研究者らが開発

AIで原子を自在に操る、次世代の量子コンピュータ向け新技術 中国の研究者らが開発

中国科学技術大学などに所属する研究者らは、AIを活用して原子を思い通りの形に配置する新技術を報告した研究を発表した。この技術は、将来の量子コンピュータの基礎となる可能性を示している。 “人工生命”を発見する自動AIシステム「ASAL」 Sakana AIや米OpenAIなどの研究チームが開発

“人工生命”を発見する自動AIシステム「ASAL」 Sakana AIや米OpenAIなどの研究チームが開発

米MITや日本のベンチャーSakana AI、米OpenAIなどに所属する研究者らは、人工生命のシミュレーションを自動的に探索・発見するシステムを提案した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.