国産LLMが抱える“開発コスト”の課題 海外勢に安さで勝てるか、ELYZA代表の危機感(2/2 ページ)

ELYZA新モデルの特徴は? 「トレーニングを1年以上続けた」

ELYZA-japanese-Llama-2-70bは、米Meta製であるLlama 2の700億パラメータモデルをベースとして、ELYZA独自で日本語に特化した追加事前追加学習と事後学習を施し、日本語処理の性能を高めた。

追加事前学習には、100億トークンの日本語コーパスを活用。学習に当たっては、産業技術総合研究所の生成AI支援プログラムの援助を受けて、AI用スーパーコンピュータ「ABCI」の計算資源の20%を2カ月占有して学習を行った。

事後学習は、ELYZA独自に構築したデータセットをベースに、日本語での指示をくみ取れるような調整を行っている。ELYZAの垣内弘太CTOは自社にデータファクトリーというデータ制作専門の部署を置き、データの学習と改善を繰り返したと説明。「トレーニングを1年以上続けてデータをブラッシュアップし続け、現在のELYZAの性能につなげた」と説明した。

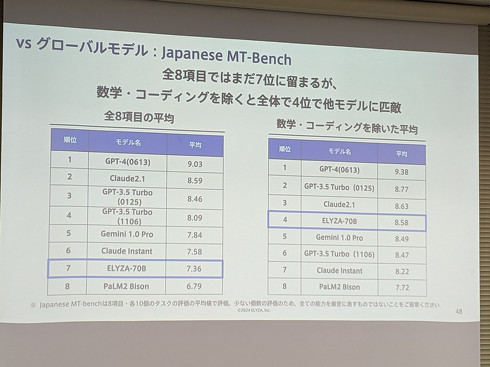

ELYZA-japanese-Llama-2-70bの性能評価には、日本語LLM用の2つのベンチマークで実施。この評価ではGPT-3.5やClaude 2、Gemini 1.0に匹敵する日本語処理性能を確認したという。

2つのベンチマークのうち「ELYZA Tasks 100」は、ELYZA自身が定めたもので、LLMが指示に従う能力や役に立つ回答を示せるかを人手で評価している。このベンチマークの評価では、全8モデル中5位にランクインし、国内モデルでは1位を記録。GPT-3.5 Turbo(0125)に匹敵する性能を示した。

もう一方のベンチマークである、英Stability AIの「Japanese MT-bench」では、総合スコアで「Gemini 1.0 Pro」を上回るスコアを獲得。特に人文学や科学技術の分野では高い性能を発揮し、OpenAIのGPT-4(0613)と同等水準の性能を確認できたとしている。

一方で、数学とコーディングの分野が苦手であり、スコアが平均を下回る結果に。推論タスクについても、GPT 3.5 Turbo-0125に引けを取る評価だった。

APIとして法人向けに提供へ

ELYZAはこれまで、LLMを法人パートナー向けにカスタムメイドで提供していた。主な活用例として、J東京海上日動火災保険のコールセンター業務の省力化や、マイナビの求人原稿の執筆になどがある。

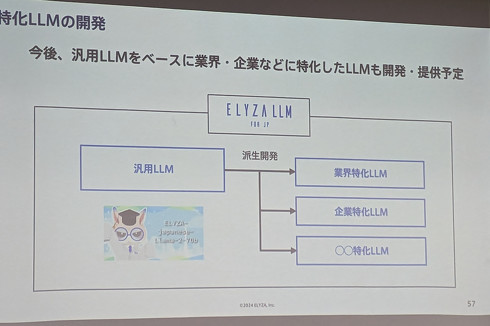

ELYZA-japanese-Llama-2-70bの開発をへて、新たにAPI形式のサービスを追加する。「ELYZA LLM for JP」シリーズとして、2024年春から提供する予定。今回発表した700億パラメータのモデルの他にも、130億パラメータ版などの既存モデルも提供し、法人のニーズにあわせて選択できるようにするという。

また、医療や法務、金融のような専門知識を求められる業界を想定し、領域特化型のLLMも開発予定と明かす。こちらは、個別企業との協業を通じて開発するとしている。

ChatGPTのような形式の一般ユーザー向けサービスは、現時点で提供予定はない。

関連記事

ELYZAが新たな日本語LLMを開発 「GPT-3.5 Turboにも匹敵」 チャット形式のデモサイトも公開

ELYZAが新たな日本語LLMを開発 「GPT-3.5 Turboにも匹敵」 チャット形式のデモサイトも公開

東大発のAIスタートアップ企業であるELYZAは、700億パラメータの大規模言語モデル(LLM)「ELYZA-japanese-Llama-2-70b」を開発したと発表した。日本企業のLLMの性能を大きく上回り、グローバルモデルの性能にも匹敵するという。 AIに「ITパスポート試験」を解かせてみると…… 最もIT分野に詳しいLLMは? GMO子会社が検証

AIに「ITパスポート試験」を解かせてみると…… 最もIT分野に詳しいLLMは? GMO子会社が検証

大規模言語モデル(LLM)に国家試験「ITパスポート試験」を解かせてみた──そんな研究成果をGMOグループのGMOメディアが発表した。LLMが持つ推論能力や問題解決能力の特徴を分析するため、IT分野での能力差を検証。GPT-4など、6種類のLLMで比較した。 話題のチャットAI「Claude 3」のプロンプト集、公式が公開中 「Excelの数式作って」など64種

話題のチャットAI「Claude 3」のプロンプト集、公式が公開中 「Excelの数式作って」など64種

話題のチャットAI「Claude 3」について、提供元の米Anthropicは3月11日までに公式プロンプト集を公開している。「プロンプトライブラリ」と題したWebサイトで、全部で64種類の使用例を公開中。 「GPT-4超え」とうわさのAI「Claude 3」を試す 仕事は任せられる? 若手記者の所感

「GPT-4超え」とうわさのAI「Claude 3」を試す 仕事は任せられる? 若手記者の所感

「ようやく本物の“GPT-4超え”が出てきた」と話題の「Claude 3」。その文章力を見てみる。 今週、生成AI「Grok」をオープンソースにする──イーロン・マスク氏が発表 「OpenAIはうそつき」

今週、生成AI「Grok」をオープンソースにする──イーロン・マスク氏が発表 「OpenAIはうそつき」

米xAIは今週、生成AI「Grok」をオープンソースにする──同社を率いるイーロン・マスク氏は、X上にそのように投稿した。

Copyright © ITmedia, Inc. All Rights Reserved.