4Kテレビとデジタルカメラの相性(3):本田雅一のTV Style

前回、デジタルカメラの撮像素子はベイヤー配列になっているため、例え1000万画素のセンサーでも色の情報が1000万画素分、フルに詰まっているわけではないと書いた。今回はさらに、輝度情報について話を進めていきたい。

「ベイヤー配列でも輝度信号はきちんとそろっているんだよね?」と思うかもしれないが、実はそのままベイヤー配列のタイルから色信号の復元処理を行うと、輪郭や細かなテクスチャーのある領域が、とんでもない色の模様で埋め尽くされることがある。これは”偽色”というもので、カラーフィルターの配置パターンと実際の映像パターンの繰り返し頻度が干渉して起こる。

この問題を避けるため、撮像する前にローパスフィルターという光学フィルターをセンサー前面に取り付けて撮影する。ローパスフィルターとは、映像から高域情報を取り除くもので、もっと簡単に言えば”映像をボケさせる”フィルターだ。均一に映像にボケさせてベイヤー配列のセンサーに光を当てることで、干渉の度合いを下げている。

均一なボケを与えているため、これを最終的にはボケて見えないように処理は行うのだが、一度捨ててしまった情報が見えてくるはずもなく、画質低下の原因の1つになっている。

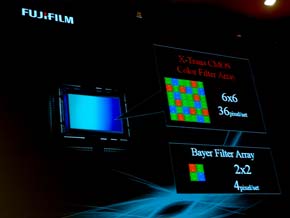

この問題を克服するため、例えばオリンパスであればローパスフィルターがカットする周波数を高くする信号処理を採用したり、富士フイルムであればベイヤーではない、異なったカラーフィルター配置をすることで偽色やモアレを低減する工夫をしている。さらに先日発表されたニコンの「D800」には、ローパスフィルターの働きを抑制した「D800E」という別バージョンのカメラが用意された。D800Eは信号処理で偽色問題を解決しようとしたものだが、完全には処理できない。そこで2つのモデルを用意し、ユーザーに選ばせることにしたわけだ。

編集部注:初掲載時、D800Eについて「ローパスフィルターを使わない」という記載がありましたが、実際には光学ローパスフィルターの働きを光学的な構成で抑制することで、レンズからの光をより直接的にCMOSセンサーへと導き、解像感を高めています。お詫びして訂正いたします。

このようなわけで、色の情報に関しても、輝度の情報に関しても、”1000万画素=1000万画素分に情報がたっぷり詰まっている”わけではないことが分かっていただけただろうか。また、同じ1000万画素でも、小さなセンサーで捉えた(小さな光学回路の)写真と、大きなセンサーとコストがかかったレンズの写真では、まったく映像の深みが違う。

つまり、4K2Kのディスプレイの画素数は約800万だが、では今の一般的なデジタルカメラに対して不足かというと、そうではないということだ。それに、拡大して表示したり、トリミングすることを考えると、写真の解像度がオーバークオリティーであることに意味がないかというと、そんなことはない。

「FUJIFILM X-Pro1」はローパスフィルターを使わない「X-Trans CMOSセンサー」を採用。X-Transは、6×6の36ピクセルで1まとまりとする配列を採用し、モアレと偽色の発生を抑えた

「FUJIFILM X-Pro1」はローパスフィルターを使わない「X-Trans CMOSセンサー」を採用。X-Transは、6×6の36ピクセルで1まとまりとする配列を採用し、モアレと偽色の発生を抑えたこれだけ高画質なデジタル写真が簡単に撮影できるようになったのだから、テレビメーカーはこれを生かせる製品作りに力を入れてほしいものだ。表示の際には画素数変換が必ず行われるが、そのときの縮小フィルターの作り方ひとつで、画質は大きく変化する。

また、写真を表示する機能に関しても、より手軽にテレビとカメラが連動するよう、無線でのデータのやりとりはもちろん、簡単かつシームレスに連動するための協業を勧めるべきだろう。また、テレビメーカーだけでなくカメラメーカーも、本気で取り組まねばならないテーマである。印刷からディスプレイへのシフトは、今後その速度を速めていくのだから。

関連記事

4Kテレビとデジタルカメラの相性(2)

4Kテレビとデジタルカメラの相性(2)

約800万画素の4Kテレビに、3000万画素超のデジカメ画像を映し出して意味があるの? と思う人が多いようだ。今回はそのあたりをじっくり解説していこう。 4Kテレビとデジタルカメラの相性

4Kテレビとデジタルカメラの相性

テレビを取り巻く技術の面では、デジタル写真への対応をさらに高めていく準備は整っている。先日開催された「CP+2012」では、いくつかの興味深い提案が見られた。 大画面の有機ELテレビが日本上陸? そのとき国内メーカーは

大画面の有機ELテレビが日本上陸? そのとき国内メーカーは

韓国メーカー2社は、「2012 International CES」のプレスカンファレンスで“テレビの画質”という側面に関して、あまり強く訴求しなかった。全面に押し出しているのは、あくまでもデザインだ。 大画面の有機ELテレビが日本上陸? サムスンとLGの戦略を分析

大画面の有機ELテレビが日本上陸? サムスンとLGの戦略を分析

LG電子とサムスンがCESで展示した55V型有機ELディスプレイ。日本では出ないのでは? と思っている方もいるだろうが、すでに日本市場に参入しているLGはもちろん、サムスンも日本への再参入を計画している。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR