「もし企業が生成AIを悪用したら……」──中古車販売・デカスギモーターの場合 内部不正を防ぐには:マスクド・アナライズの「AIしてま〜す!」(3/3 ページ)

報告書は記事よりも奇なり

ここまで紹介した生成AI事例において、法律や社会通念上における明らかな違反行為が複数あります。さらにインタビューは創作であり、同様の事例を行った場合は罰せられる非常に可能性が高いです。

しかし、生成AIという技術が存在する以上、ここまでに挙げた不正かつ悪意ある行為は実行可能なものです。生成AIの悪用において、法整備の遅れや不正の発見が難しい面もあり、対応が急がれています。

では、なぜこのような悪用が発生するのでしょうか。悪用の防止策について考えてみましょう。

まず対策としては「ルール・ガイドラインの策定」「利用状況の監視」「成果物に対する確認」などが挙げられます。従業員のモラルに頼るだけではなく、明確な規則を設けて監視体制を取る必要があります。

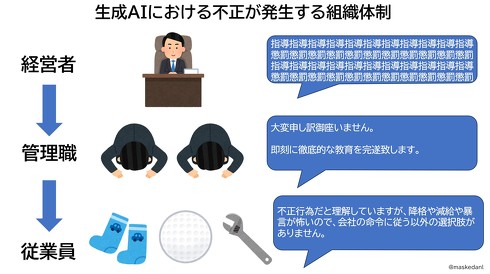

しかし組織ぐるみの悪用となれば、状況が変わります。要因として多く挙げられる点として、経営陣が極端に高い目標を設定して部下や現場に無理強いする体質が挙げられます。さらに従業員における減給や降格や異動などの人事査定を一方的に振りかざし、待遇を徹底的に管理する「生殺与奪権」を握る傾向が挙げられます。

こうした経営陣や管理職における一方的な命令に従業員が服従する組織では、コンプライアンスを無視した不正行為がまん延します。もちろん従業員は罪悪感を感じますが「経営陣や上司から厳しい処遇を受けるよりはましだ」と感覚がまひしています。そのため内部告発が機能せず、不正がまん延したまま放置される傾向があります。

では疑問点として、第三者が不正行為を見抜いて報告することは可能でしょうか。生成AIは進化を続けており、悪意を持って偽造されたものを発見するのは難しくなっています。事務的な報告書など大量の情報を全てを入念に調べるのは現実的ではありません。また、申請を行うシステムや仕組みが「不正を行わない」を前提とした性善説である場合は、さらに発見が難しくなります。

それでも不正が発覚するきっかけとしては、顧客や取引先からのSNS発信が挙げられます。件数が増えれば、顧客や取引先が違和感を覚えて発覚する可能性も高くなります。特に中古車販売のような消費者向け事業であれば、不正が発覚した場合にSNSで拡散されやすく、マスコミ報道につながって調査が進むという流れがあります。

もっとも企業が黙殺して進展が無い場合もあるため、継続的な申し立てや内部通報者における業界団体や行政へ決定的な証拠が送られるなどの対応が必要です。

現時点では生成AIを利用する企業が増える中でも、ガイドラインやルールを独自に定めて正しく利用しています。とはいえ、まだまだ生成AIを活用する企業は一部であり、先行して費用や手間をかけて導入するだけの余裕もあります。

一方、生成AIの利用における費用や難易度といった障壁が下がって普及が進むことで、モラルの無い会社でも利用できるようになります。近い将来、デカスギモーターのような事例が創作ではなく、現実となる可能性もあるでしょう。生成AIの悪用による被害が拡大する前に、対策が求められます。

関連記事

生成AIで福岡のPR記事作成→“架空の祭りや景色”への指摘が続出 開始1週間で全て削除する事態に

生成AIで福岡のPR記事作成→“架空の祭りや景色”への指摘が続出 開始1週間で全て削除する事態に

Webで地方の魅力をPRする「つながり応援プロジェクト」は、福岡県でのキャンペーン「福岡つながり応援」の公式Webメディアで「誤った情報を発信した」と公式Xで謝罪した。生成AIを活用してPR用の記事を制作したところ、ユーザーから間違いを指摘する声が相次いだという。 社内AIチャットが「ウマ娘」のスぺちゃん口調──Cygamesの生成AI活用法 「AIには“プランB”を学習させるべき」

社内AIチャットが「ウマ娘」のスぺちゃん口調──Cygamesの生成AI活用法 「AIには“プランB”を学習させるべき」

Cygamesは、技術カンファレンス「Cygames Tech Conference 2024」を開催し、基調講演で同社における生成AI活用の現状と展望を示した。 米NVIDIA×ソフトバンク、日本の“AIインフラ構築”へ 孫正義氏「これは国家安全保障の問題」

米NVIDIA×ソフトバンク、日本の“AIインフラ構築”へ 孫正義氏「これは国家安全保障の問題」

米半導体大手NVIDIAとソフトバンクは、日本におけるAIインフラの構築で包括提携すると発表した。 【異世界ファンタジー「早々にヤレーネン」】──「AIツールの覇権は短いと分かっていたのに……」と泣かないための注意点

【異世界ファンタジー「早々にヤレーネン」】──「AIツールの覇権は短いと分かっていたのに……」と泣かないための注意点

「生成AIは魔法だ」──生成AIがこれまでの常識を覆す技術として、まるで魔法のように感じる人がいます。果たして、現代社会において生成AIは魔法といえるモノなのでしょうか? 異世界ファンタジーの舞台を例に、生成AIと魔法の関係を考えてみましょう。 【現代AI童話「驚き青年」】──「生成AIはヤバすぎる最強神ツール!?」 “プロ驚き屋”にご用心

【現代AI童話「驚き青年」】──「生成AIはヤバすぎる最強神ツール!?」 “プロ驚き屋”にご用心

さまざまなメディアが生成AIを取り上げることも増えてきた現代。SNSで活動する一部のユーザーのことを「プロ驚き屋」「驚き屋」と呼ぶ声が上がっている。彼らの存在によって巻き込まれる可能性のあるトラブルを“AI童話”と題して紹介する。

Copyright © ITmedia, Inc. All Rights Reserved.