OpenAI「GPT-4」リリース 司法試験で上位10%の賢さ、画像認識にも対応

米OpenAIは3月14日(現地時間)、新たなマルチモーダルモデル「GPT-4」を開発したと発表した。月額20ドルのChatGPT Plusのユーザーは利用できる。

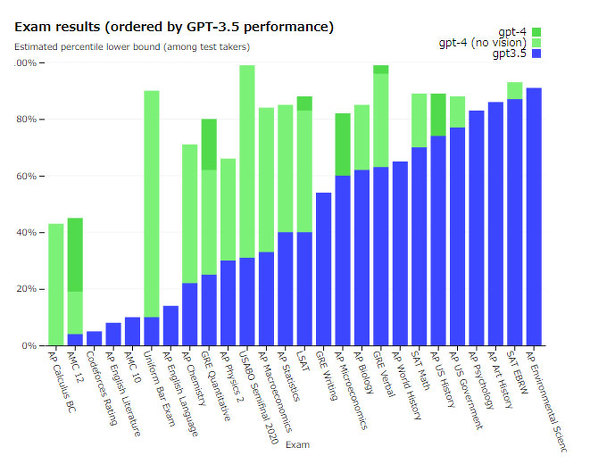

現実的なシナリオでは人間の回答に劣るものの、司法試験の模擬テストのような専門的な分野では受験者の上位10%のスコアを記録したという。なお、ChatGPTが採用しているGPT-3.5でのスコアは下位10%だったとしている。

GPT-4とGPT-3.5の違いはタスクの複雑さがしきい値を超えると現れるという。GPT-4の方が信頼性が高く、創造的かつ微妙な指示を処理でき、試験のスコアも向上している。

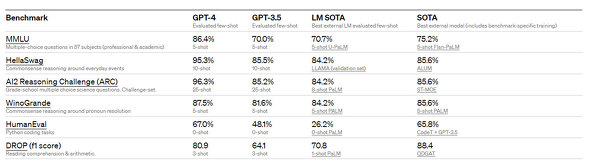

機械学習モデル用の従来型ベンチマークにおいても、ほとんどの最先端モデル(SOTA)と比較して優れたスコアを記録した。

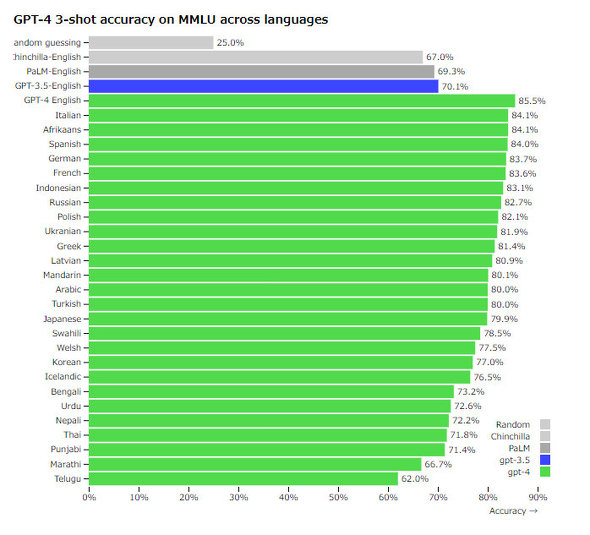

「Azure Translate」を使用してMMLUベンチマークを翻訳してテストした場合でも、26言語のうち24言語でGPT-3.5の英語スコアを上回った。ラトビア語、ウェールズ語、スワヒリ語といった翻訳リソースが少ない言語も含まれる。

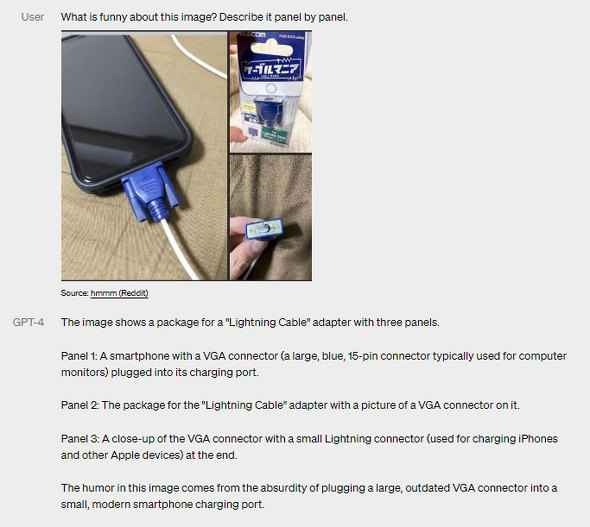

現在、研究段階のプレビューとして公開していないが、画像認識にも対応する。画像認識はテキストと同様の性能を発揮するとしており、テキストのみの言語モデル用の少数ショットや思考連鎖プロンプトを使用して拡張することもできるという。

画像入力に対するGPT-4の回答。エレコム「ケーブルマニア」を取り付けた端子を接続したスマートフォンを判別し、「最新のスマホにVGA端子を差し込んでいるユーモア」と解説している。実際はケーブルカバーを取り付けているLightning端子

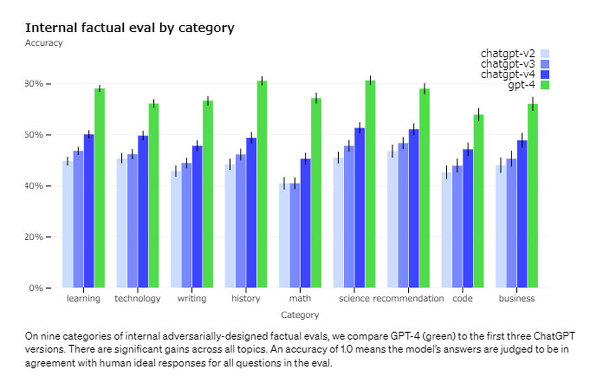

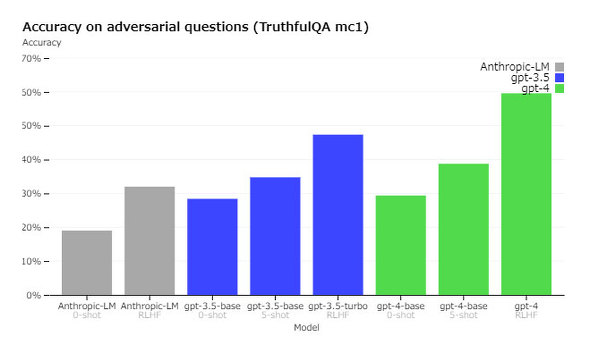

画像入力に対するGPT-4の回答。エレコム「ケーブルマニア」を取り付けた端子を接続したスマートフォンを判別し、「最新のスマホにVGA端子を差し込んでいるユーモア」と解説している。実際はケーブルカバーを取り付けているLightning端子内部の事実性評価ではGPT-3.5より40%高いスコアを記録し、外部ベンチマーク「TruthfulQA」では誤った記述と事実の分離に成功した。ただしGPT-4でも推論を誤ることはあるという。

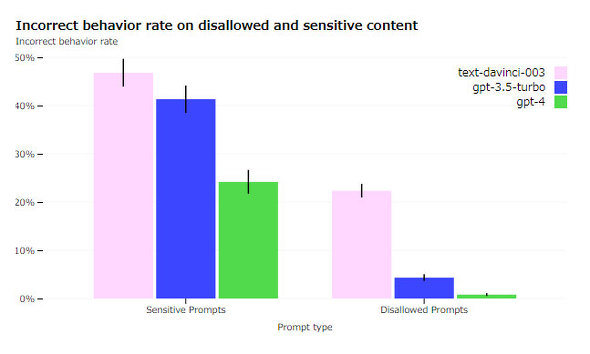

GPT-4がユーザーに与えるリスクを軽減するため、有害なアドバイスや脆弱(ぜいじゃく)性のあるコード、不正確な情報については各分野の50人を超える専門家と協力して敵対的テストを行ってモデルを改善した。RLHF(人間のフィードバックによる強化学習)トレーニング中に追加の信号を組み込み、リスクのある要求を拒否するようにトレーニングした。これにより、許可されていないコンテンツのリクエストに応答する傾向が82%減少し、医療アドバイスや自傷行為などに応答する頻度が29%高くなったという。

GPT-4のトレーニングは従来のGPTモデルと同様にドキュメント内の次の単語を予測するようにトレーニングした。Web上に公開されたデータなどを利用し、数学の問題に対して正誤の解決策や推論の強弱などを含み、多岐にわたるイデオロギーとアイデアを表すため、ユーザーが質問するとユーザーの意図とかけはなれた回答を行うという。

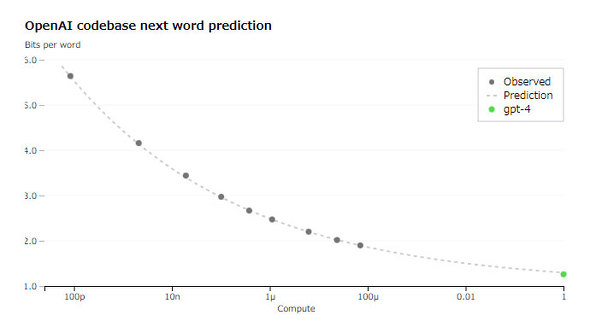

現在GPT-4プロジェクトの焦点はディープラーニング結果の蓄積を予測できること。その理由は、トレーニングが非常に大規模なため、モデル固有に大きく調整を行うことは現実的ではなく、データの拡大が予測できることが非常に重要だからだとしている。具体的には、同じ手法で学習させたモデルの計算量を1万分の1に減らして外挿することで、最終的なGPT-4の損失を事前に正確に予測することに成功している。

検査用フレームワークのオープンソース化

GPT-4のようなモデルを評価するためのベンチマークを作成/実行し、サンプルごとに検査するための「OpenAI Evals」をオープンソース化した。自身でカスタマイズした評価ロジックを実装できる。

また3月15日(日本時間)、日本マイクロソフトが新しいBingがGPT-4上で稼働していると発表した。

関連記事

経営者の「ChatGPT」認知は約30% 検索に利用しつつも具体的な活用イメージは不明――レトリバが調査

経営者の「ChatGPT」認知は約30% 検索に利用しつつも具体的な活用イメージは不明――レトリバが調査

AIテキスト分析ツール「YOSHINA」を提供するレトリバは、全国の経営者を対象に「ChatGPT」について調査した結果を公表した。ChatGPTの認知度は30.6%で、約4割が検索に利用しているが具体的な活用イメージについては「まだわからない」が半数となった。 Googleの会話型AIサービス「Bard」はなぜChatGPTに後れを取ったのか?

Googleの会話型AIサービス「Bard」はなぜChatGPTに後れを取ったのか?

Googleが、対話アプリケーション用言語モデル(LaMDA)を搭載した実験的な会話型AIサービス「Bard」を発表しました。2022年11月に公開されたChatGPTに対抗するサービスとなります。当面は対話アプリケーション用言語モデル(LaMDA)のフル機能を利用できるわけではなく、Bardの回答が品質、安全性、信頼性などの基準を満たしていることを確認するとしています。 ChatGPTに「iPhoneとAndroidどちらがオススメなのか」聞いてみた

ChatGPTに「iPhoneとAndroidどちらがオススメなのか」聞いてみた

OpenAIが開発した対話型サービス「ChatGPT」が話題を集めています。そこで、ITmedia Mobileでは、モバイルに関連する質問を投げかけてみることにしました。今回質問したのは「iPhoneとAndroid、どちらがオススメですか?」です。 Googleが会話型AIサービス「Bard」発表、まずはテストユーザーに公開

Googleが会話型AIサービス「Bard」発表、まずはテストユーザーに公開

米Googleは、2月7日に対話アプリ用言語モデル「LaMDA」を活用した実験的な会話型AIサービス「Bard」を発表。まずは「信頼できるテストユーザー」にのみ公開し、今後はGoogle検索へAIの新機能を追加するという。 人気のChatGPTは「答え」を出すツールではありませんが「要約」はいいかもしれません

人気のChatGPTは「答え」を出すツールではありませんが「要約」はいいかもしれません

最近、AI言語モデルを使ったチャットボット「ChatGPT」が脚光を浴びています。iPhoneとAndroidについて聞いてみると、どんな答えが出てくるのでしょうか……?

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- どこでもウユニ塩湖? 3COINSで550円の「スマホ用反射ミラークリップ」を試す (2026年03月12日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- 「Galaxy S26」シリーズはどこが安い? 一括価格と2年間の実質負担額を比較、お得なキャリアはココだ (2026年03月11日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)