ハイエンドスマホ向け新型SoC「Snapdragon 8 Elite」にみるAI半導体の進化(2/4 ページ)

鍵を握る「NPU」のチューニング

Microsoftは5月に掲げた「Copilot+ PC(新しいAI PC)」の動作要件の1つに、「CPU/SoCが統合するNPUの性能が40TOPS以上」というものがある。

NPUは推論ベースのAIが用いる演算に特化したプロセッサのことで、NPUは脳のニューラルネットワークになぞらえた「Neural Processing Unit」の略称だ。NPUはAIのオンデバイス実行に重要であると同時に、NPUがAIのオンデバイス実行の全てではないことには留意したい。

繰り返しだが、NPUは推論演算に特化している。ゆえに当該の演算を高速かつ省電力で実行可能だ。同様の演算はGPU(Graphics Processing Unit)」でも行えるが、NPUの方が効率面でメリットがある。LLMを始めとして、オンデバイス動作を前提とする生成AIは「学習」は行わず、推論のみを行うことが多い。

ゆえにNPUの性能が、ほぼイコールでCPU/SoCのAI性能ということになりやすい。

ハイエンドスマホ向けの新型SoC「Snapdragon 8 Elite」のAI推論(インターフェンス)性能について解説するQualcomm Technologiesのシディカ・ネバカー氏(製品マネジメント担当シニアディレクター)

ハイエンドスマホ向けの新型SoC「Snapdragon 8 Elite」のAI推論(インターフェンス)性能について解説するQualcomm Technologiesのシディカ・ネバカー氏(製品マネジメント担当シニアディレクター)ただし、NPUの性能指標とされている「TOPS」、つまり1秒当たりの命令処理回数が必ずしも実際の性能を示すものとは限らない点にも注意が必要だ。

例えば「Aの推論を実行するのに、○TOPSの性能が必要」というただし書きあると、そのNPUがどの程度の推論を実行する“キャパシティ”を備えるか、おおよその目安にはなる。しかし、「Aの推論」を「○TOPS」の処理性能を持つ“異なる”NPUで処理した場合、その結果(パフォーマンス)がイコールになるとは限らないのだ。

というのも、NPUによって得意とする(最適化している)演算方法や、演算結果をメモリに書き込む速度が異なるからだ。TOPSの数字はマーケティング的には分かりやすく、ユーザーにとっても参考になるものの、数値だけでNPUの“強み”と“弱み”を知ることは難しい。

そういう観点では、「MLCommons」が開発した機械学習ベンチマークテスト「MLPerfシリーズ」は、推論ベースのAIにおける客観的なパフォーマンスを知る手段としてデファクトスタンダードとなっている。

このあたりの話題は、Qualcommが2月に公表したブログエントリーやホワイトペーパーで詳細に解説されている。

- →What is an NPU? And why is it key to unlocking on-device generative AI?(ブログエントリー)

- →Unlocking on-device generative AI with an NPU and heterogeneous computing(ホワイトペーパー)

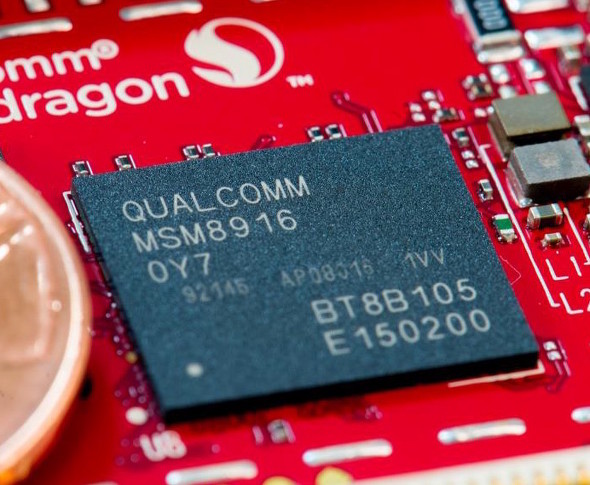

QualcommのSoC「Snapdragonシリーズ」に搭載されているNPU「Hexagon(ヘキサゴン)」は、元々は信号変換処理を担うDSP(Digital Signal Processor)として搭載されていた。その出自から、かつてのHexagonは大量の積和(MAC:Multiply Accumulate)演算に特化していた。

しかし、昨今のAI処理では大量の行列(Matrix/Tensor)演算が発生する。行列演算とは、すなわち大量のMAC演算でもある。ゆえに、昨今のHexagonはAIにおける推論実行に最適化するチューニングが施されている。

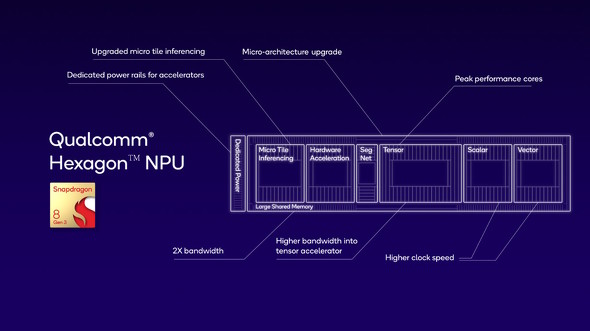

先に紹介したホワイトペーパーでは、文中でHexagonがどのようなチューニングを施されてきたのか紹介している。例えば2022年12月に発表されたハイエンドスマホ向けSoC「Snapdragon 8 Gen 2」のHexagonでは、AI推論の実行におけるレイヤーが10層以上になっても、実行単位である「Microtile(マイクロタイル)」内でScalar演算/Vector演算/Tensor演算を独立して演算処理できるようにした。これにより、メインメモリへのアクセス回数が減少し、結果的に実効性能の大幅な引き上げに成功したという。

またAI推論では「浮動小数点」ではなく「整数演算」が主に用いられるが、実行する推論の内容によっては必ずしも高精度でなくても構わない。そこでSnapdragon 8 Gen 2のHexagonでは「INT4」演算をハードウェアレベルでサポートした。例えば「INT8」ならINT4の2倍の数を扱えるが、そこまでの精度を必要としない場合はINT8の演算器を「INT4×2」の演算器として運用することで、実効速度の向上と消費電力の削減を両立した。

SnapdragonのNPU「Hexagon」のルーツをたどると、2015年にリリースされた「Snapdragon 820(MSM8916)」に搭載されたDSPにたどり着く(ホワイトペーパーより引用)

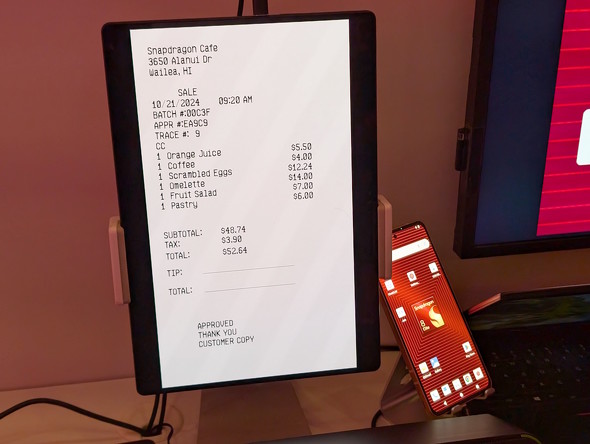

SnapdragonのNPU「Hexagon」のルーツをたどると、2015年にリリースされた「Snapdragon 820(MSM8916)」に搭載されたDSPにたどり着く(ホワイトペーパーより引用)そして2023年10月に披露されたハイエンドスマホ向けSoC「Snapdragon 8 Gen 3」では、メインメモリとしてLPDDR5X-4800をサポートすることでメモリのアクセススピードを改善した。

「AI推論とメモリって関係があるの?」と思うかもしれないが、LLMを実行する際には「モデル」がメモリ上に大量に展開されるため、NPUとメモリは頻繁にデータをやりとりする。言い換えると、メモリのアクセススピードが速ければ、その分だけLLMからの回答(レスポンス)も早く得られることになるため、メモリの容量とアクセススピードは重要なのだ。

メモリのアクセス速度の改善は、少なくとも今後数年にわたってLLMの実行に必要十分なパフォーマンスが得られるよう志向した結果だと考えられる。現に、Snapdragon 8 Gen 3を搭載するスマホにおいて、オンデバイスである程度の規模のLLMを動作させる試みは行われている。

今回、新たに登場したSnapdragon 8 Eliteでも、Hexagonの構造に少し手が入っている。ITmedia Mobileに掲載したレポートでも触れているが、今回のHexagonではScalar演算とVector演算を担うユニットが事実上2倍に増えた。Tensor演算ユニットは、大量の行列演算、AI推論的にいうと「畳み込み演算」を担い、Vector演算はトークン処理にまつわる演算に活用されている。

現在の生成AIの基本的な理論「Transformer」では、「プロンプト」など入力された文書をいったん推論エンジンが理解できるトークンに変換(エンコード)した上で畳み込み演算を行い、結果を人間が解釈できる形に復元(デコード)して出力するというプロセスを取る。現状のLLMは、トークンが長大化してしまう傾向があるため、特にVector演算を強化することが、実効性能の向上に直結するというわけだ。

先述の通り、CPU/SoCの開発では少なくとも5〜7年程度先を見据える必要がある。5〜7年先のユースケースをにらみつつ、CPU/SoCの“どこ”を“どのように”強化するのかという方向性を的確に探れるかどうかが、半導体メーカーの腕の見せ所となる。

関連記事

Microsoftが提唱する「AI PC」とは何か

Microsoftが提唱する「AI PC」とは何か

Microsoftが、「AI PC」の普及に向けて着々と手を打ちつつある、その具体的な内容を見ていこう。 「Snapdragon 8 Elite」は何が進化したのか PC向けだったCPUコア「Oryon」採用のインパクト

「Snapdragon 8 Elite」は何が進化したのか PC向けだったCPUコア「Oryon」採用のインパクト

Qualcommがモバイル向け最新プロセッサ「Snapdragon 8 Elite」を発表した。最大の特徴は、2023年にリリースされたPC向けSoC「Snapdragon X Elite/Plus」で採用された「Oryon(オライオン)」のCPUコアを、モバイル向けとしては初めて採用したこと。Efficiencyコアを廃して、どちらかといえば“高パフォーマンス”寄りの設計が行われている。 Qualcomm、CPUコア「Oryon」搭載の「Snapdragon 8 Elite」発表 AI機能を強化

Qualcomm、CPUコア「Oryon」搭載の「Snapdragon 8 Elite」発表 AI機能を強化

Qualcommは、モバイル向けの新型SoC「Snapdragon 8 Elite」を発表した。「Snapdragon 8 Gen3」の後継に当たるが、世界最速のモバイルCPU”を謳う「Qualcomm Oryon」CPUを搭載し、AI機能を強化した革新的な製品としている。 Qualcomm、「Snapdragon 8s Gen 3」発表 “オンデバイスAIをより多くのスマホに”

Qualcomm、「Snapdragon 8s Gen 3」発表 “オンデバイスAIをより多くのスマホに”

Qualcommは「Snapdragon 8s Gen 3」を発表した。ハイエンド「Snapdragon 8 Gen 3」の機能をより多くのスマートフォンに提供する。端末上でのマルチモーダル生成AIはサポートする。 生成AIの処理も可能になった「Snapdragon 8 Gen 3」 スマホの競争軸は新たなステージに

生成AIの処理も可能になった「Snapdragon 8 Gen 3」 スマホの競争軸は新たなステージに

Qualcommが、新技術を披露するイベント「Snapdragon Summit 2023」にて、Snapdragon 8 Gen 3を発表した。CPU、GPU以上にNPUの性能が向上し、生成AIの処理も可能になった。写真拡張やイラスト生成、チャットbotに暗所動画といった応用例も紹介した。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- エンスージアスト向けCPU「Core Ultra 200S Plus」登場 Eコア増量+メモリアクセス高速化+バイナリ最適化でパフォーマンス向上 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)