Microsoftが推論特化のAIアクセラレーター「Azure Maia 200」を開発 FP4演算なら毎秒1京回超の演算が可能 一部のAzureデータセンターに導入

Microsoftは1月26日(米国太平洋時間)、AI(人工知能)の推論演算に特化したデータセンター向けAIアクセラレーター「Azure Maia 200」を発表した。Maia 200を採用するサーバは同社の「米国中部データセンター」で既に展開済みで、今後も同社のAzureデータセンターの一部リージョンに導入を進めるという。

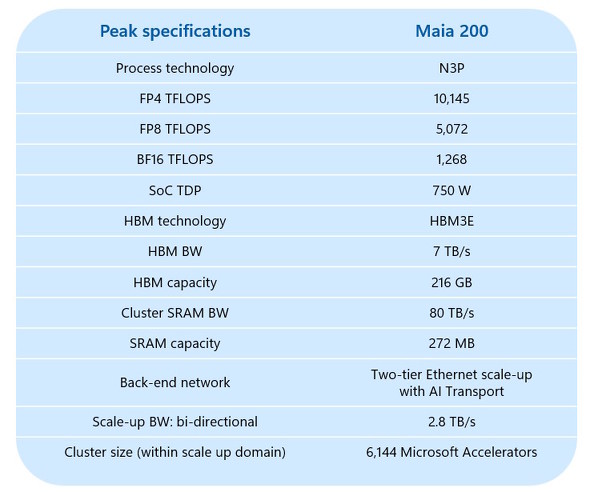

Azure Maia 200は、2023年11月にリリースした「Azure Maia 100」の次世代版という位置付けで、台湾TSMCの3nmプロセスで製造されている。トランジスタ数は1400億個超で、毎秒7TBの帯域幅を持つHBM3e(広帯域メモリ)を216GB備え、オンチップSRAMも272MB備えている。

FP4/FP8演算をネイティブに演算できる「テンソル(行列)コア」を備えており、ピーク時の演算性能はFP4演算時で約10PFLOPS(毎秒1京回)超、FP8演算時で約5PFLOPS(毎秒5000兆回)となっている。FP4演算はAWS(Amazon Web Services)の「Trainium3」比で3倍の性能で、FP8演算もGoogleの「第7世代TPU(Ironwood)」を上回るという。

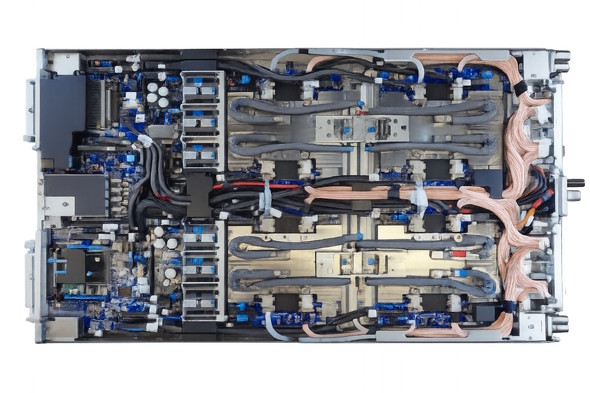

チップ自体の演算性能だけでなく、データのやり取りについても高速化を図っており、Azureデータセンターに設置される「サーバブレード」では1トレイ当たり4基のAzure Maia 200をスイッチを介さず直接接続することで、スループット(実効性能)の向上と効率の改善を図っているという。

Microsoftでは、Maia 200を利用するためのSDK(ソフトウェア開発キット)のプレビュー版を公開している。利用にはWebフォームからリクエストする必要がある。

関連記事

OpenAI、画像生成AI「DALL-E」に部分編集機能を追加

OpenAI、画像生成AI「DALL-E」に部分編集機能を追加

OpenAIは、同社提供の画像生成AI「DALL-E」に部分編集機能を追加した。 米Microsoft、AI向けに独自のArmプロセッサ「Cobalt」とAIアクセラレータ「Maia」を開発

米Microsoft、AI向けに独自のArmプロセッサ「Cobalt」とAIアクセラレータ「Maia」を開発

いずれも2024年初頭からMicrosoftのデータセンターに展開する。 AWSがワッパを改善した次世代プロセッサを披露 幅広い処理に対応する「Graviton4」と機械学習特化の「Trainium2」

AWSがワッパを改善した次世代プロセッサを披露 幅広い処理に対応する「Graviton4」と機械学習特化の「Trainium2」

Amazon Web Servicesが、自社データセンターで利用する自社開発プロセッサの新モデルを披露した。同社の「Amazon EC2」で順次利用可能になる見通しだ。 危機の演出? それとも本当の“焦り”? OpenAI「コード・レッド」の内実

危機の演出? それとも本当の“焦り”? OpenAI「コード・レッド」の内実

OpenAIが「GPT-5.2」を発表する前に、同社が社内に「コード・レッド(緊急事態)」を宣言したという報道があった。これは、一体どういうことだったのか――よく見てみると、ある意味でのゲームチェンジを狙ったものだということが分かる。 “暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

“暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

OpenAIの新言語モデル「GPT-4.5」のリサーチプレビュー版をリリースした。従来の「GPT-4」と何が変わったのか、実際に試しつつ解説する。【更新】

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 改めて考える単眼カメラとモノラルスピーカー それでも「iPhone Air」を推したくなる理由 (2026年02月09日)

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- ソニー、PCゲーマー向けの「DualSense」を3月5日に発売 USBケーブル付属 (2026年02月09日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)