NVIDIAが最新GPU/モバイルSoCのロードマップを披露――GTC 2014基調講演まとめ:Pascal、Erista、TITAN Z(1/3 ページ)

NVIDIAは、3月24日〜27日4日間、米カリフォルニア州サンノゼ市のSan Jose McEnery Convention Centerにおいて、GPUに関する技術会議「GPU Technology Conference 2014」(GTC 2014)を開催中だ。その2日目の3月25日にオープニングキーノートに登場したジェンスン・ファンCEOは、同社の最新GPUロードマップやSoCロードマップを披露するとともに、PCやスーパーコンピューターだけでなく、自動車分野などにも積極的にGPUの持つ優れたコンピューティング性能を生かせるプラットフォームを展開していく意向を示した。

GTC 2014の会場となったSan Jose McEnery Convention Center(写真=左)。オープニングキーノートで同社のCUDAエコシステム戦略を説明するジェンスン・ファンCEO(写真=右)

GTC 2014の会場となったSan Jose McEnery Convention Center(写真=左)。オープニングキーノートで同社のCUDAエコシステム戦略を説明するジェンスン・ファンCEO(写真=右)80Gバイト/秒の帯域を実現する「NVLINK」でCPU−GPU間のボトルネックを解消

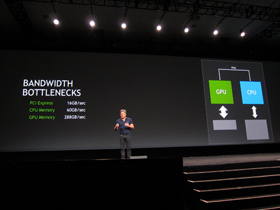

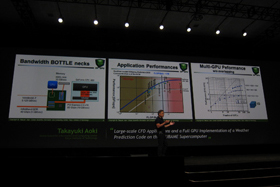

ファン氏はまず、同社独自のGPUコンピューティング言語「CUDA」を取り上げ、CPU+GPUの組み合わせは、CPUの持つ柔軟な演算能力とGPUの持つ強力な並列演算性能を生かせる完璧なソリューションと位置づける一方で、GPUコンピューティングのパイオニアでもある東京工業大学の青木尊之教授の論文を紹介しつつ、「ビッグデータや複雑な演算処理を行なううえでは、CPUとGPU間のデータ帯域の狭さがボトルネックになっている」と指摘。CPU−GPU間のインタフェースとなっているPCI Express 3.0 x16の16Gバイト/秒、システムメモリ帯域の60Gバイト/秒、GPUメモリの288Gバイト/秒というアンバランスさが、CPUとGPUの密なる連係を阻んでいると説明する。そこで、同社の次世代GPUアーキテクチャでは、「NVLINK」と呼ぶ、新しいCPU−GPUインタフェースを採用する意向を表明した。

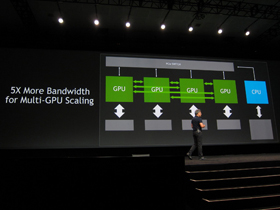

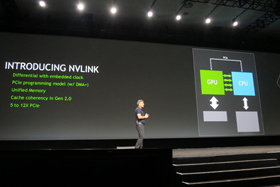

NVLINKは、IBMと共同開発したオプティカルインタフェースで、PCI Express 3.0 x16の5倍となる80Gバイト/秒の帯域を実現するもの。基本的にPCI ExpressやDMA(Direct Memory Access)を拡張するカタチで実装され、差動信号にクロック信号を埋め込むことで、より高速なインタフェースを実現し、CPUとGPUが共通のメモリ空間に効率よくアクセスできるようにする。

むろん、同技術をサポートするためには、CPU側の対応も不可欠となるため、最初の対応プラットフォームはIBMのPower CPU環境となるが、「ほかのCPUへの対応も話し合っている」(同社関係者)という状況だ。NVLINKでは複数のGPU間のデータ共有にも生かすことができる。

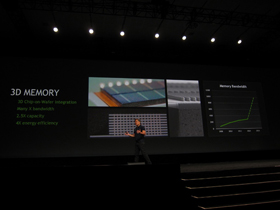

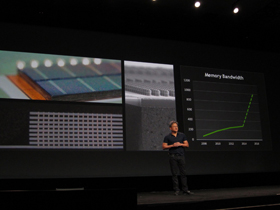

また、ファン氏は、このNVLINKの第2世代ではCPUとGPUのキャッシュコヒーレンシをハードウェアで採れるようにするとともに、192Gバイト/秒の帯域を実現する計画であることも明らかにした。さらにファン氏は、次世代GPUでは複数のメモリダイをTSV(Through Silicon Via:シリコン貫通電極)で積層することで、広帯域かつ大容量で、エネルギー効率にも優れた3Dメモリを採用する意向を明らかにした。

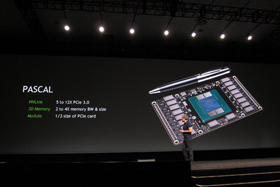

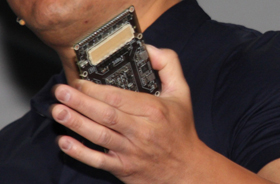

ファン氏はその次世代GPUアーキテクチャにフランスの自然哲学者で、近代物理学の先駆者とされるブレーズ・パスカル(Blaise Pascal)から“Pascal”というコードネームを与えることを明らかにし、同GPUに対応したモジュールも披露した。

同モジュールは、現行のPCI Expressベースのグラフィックスカードに比べて3分の1というコンパクトなフォームファクターで、背面にはNVLINKと電源供給用と考えられる高密度コネクタを2つ搭載していた。

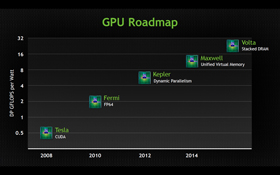

ただし、同モジュールはあくまでもNVLINKなどのエンジニアリング用のモジュールであり、搭載されているチップはPascalとは別物と考えるべきだ。なお、ファン氏は、このPascalを2016年に市場投入する意向を示すとともに、最新GPUロードマップを公開している。

NVLinkや3Dメモリの動作検証用に作られたPascalモジュール。ただしGPUそのものはPascalではない(写真=左)。Pascalモジュールの裏面にはNVLinkと電源供給のための高密度コネクタが2つ搭載していることが確認できる(写真=右)

NVLinkや3Dメモリの動作検証用に作られたPascalモジュール。ただしGPUそのものはPascalではない(写真=左)。Pascalモジュールの裏面にはNVLinkと電源供給のための高密度コネクタが2つ搭載していることが確認できる(写真=右)このロードマップで注目すべきは、2013年のGTCで公開された「Volta」(ヴォルタ)が「Pascal」に置き換えられたように見える点だが、複数のNVIDIA関係者は「Volta」は、いまもロードマップに留まっているという見解を示す。

また、Pascalの目玉となるNVLINKと、今回披露された「Pascalモジュール」は、あくまでもスーパーコンピュータやデータセンター向けなどのHPC(High Performance Computer)向けにTeslaとして展開予定のフォームファクターであり、PC向けにはPCI Expressベースの製品も用意される。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- 3万円超でも納得の完成度 VIA対応の薄型メカニカルキーボード「AirOne Pro」を試す キータッチと携帯性を妥協したくない人向け (2026年03月12日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- エンスージアスト向けCPU「Core Ultra 200S Plus」登場 Eコア増量+メモリアクセス高速化+バイナリ最適化でパフォーマンス向上 (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- 高音質・良好な装着感・バッテリー交換式――JBLのフラッグシップ「Quantum 950 WIRELESS」は妥協なきヘッドセットか (2026年03月12日)