NVIDIAのデータセンター向けGPU「NVIDIA A100」PCI Express 4.0モデルに80GB構成登場 メモリ帯域幅は毎秒2TBに拡張

NVIDIAは6月28日(米国太平洋時間)、データセンター向けGPU「NVIDIA A100」のPCI Express接続モデルにGPUメモリ(HBM2E)を40GBから80GBに倍増した製品を追加することを発表した。富士通などパートナー企業を通して販売される予定だ。

NVIDIA A100は、HPC(ハイパフォーマンスコンピューティング)向けのAmpererアーキテクチャベースのGPUだ。従来は、NVIDIAのスーパーコンピューティングプラットフォーム「HGX」用のモジュールが2種類(40GB/80GB)と、PCI Express接続モデルが1種類(40GB)の計3種類が用意されていた。

今回追加されたPCI Express接続モデルの80GBモデルは、GPUとの通信帯域幅を毎秒約1.6TBから毎秒約2TBに引き上げている。既存の40GBモデルと同様に、接続バスはPCI Express 4.0 x4で、GPU同士をつなぐ「第3世代NVLink」にも対応する。最大TDP(熱設計電力)は、250Wから300Wに引き上げられている。

Magnum IO GPUDirect Storageも本格展開開始

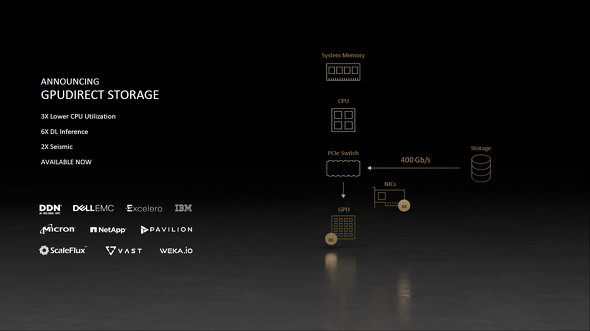

NVIDIAは同日、PCI Expressスイッチを介してGPUがNVMeストレージに直接アクセスできる技術「Magnum IO GPUDirect Storage(GDS)」を本格的に展開することも合わせて発表した。対応するストレージシステムはDell Technologies、IBM、Micronなどから提供される。

GDSを利用すると、ストレージにアクセスする際のCPU負荷が低減され、深層学習の推論演算速度が最大6倍、地震に関するシミュレーションの速度が最大2倍に高速化するという。

関連記事

NVIDIA A100を6159基搭載 米NERSCのAIスパコン「Perlmutter」がついに稼働

NVIDIA A100を6159基搭載 米NERSCのAIスパコン「Perlmutter」がついに稼働

NVIDIAのデータセンター向けGPUを6159基搭載するスーパーコンピューターが、ついに稼働を開始する。同GPUを搭載するスーパーコンピューターとしては現時点において最大規模のもので、構築はHewlett Packard Enterprise(旧Cray)が担当している。 NVIDIAが新型AIワークステーション「DGX Station A100」を発表 2020年末までに発売

NVIDIAが新型AIワークステーション「DGX Station A100」を発表 2020年末までに発売

AIデータ処理に特化したNVIDIA製のワークステーションに新モデルが登場する。CPUをIntelのXeonからAMDのEPYCに変更した他、AmpereベースのハイエンドGPU「NVIDIA A100」を4基搭載することで「データセンター並みの機械学習処理を机の下で実現」した。 NVIDIAがデータセンター向けCPU「Grace」を開発 Armアーキテクチャを採用して2023年初頭に発売へ

NVIDIAがデータセンター向けCPU「Grace」を開発 Armアーキテクチャを採用して2023年初頭に発売へ

NVIDIAが、データセンター向けGPUに加えて“CPU”の開発を表明した。現在買収手続きを進めているArmのアーキテクチャを使って設計することで、省電力性と高速演算を両立したことが特徴だ。 NVIDIAがプロ向けGPU「RTX A4000」「RTX A5000」を発表 モバイル向け製品も用意

NVIDIAがプロ向けGPU「RTX A4000」「RTX A5000」を発表 モバイル向け製品も用意

NVIDIAが、プロフェッショナル向けGPUの新製品を発表した。デスクトップワークステーション/データセンター向け製品には下位製品が追加される一方、モバイルワークステーション向けは上位製品のアーキテクチャをAmpereに移行する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- Googleが「Pixel 10a」発表 499ドルでフラッグシップ級のAI機能を搭載 AirDropや衛星SOSも対応 (2026年02月19日)

- 日本初の限定Echo Dotは「ドラえもん」! 価格はあえての「1万1293円」 (2026年02月19日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 最大3画面出力と100W給電に対応した「UGREEN 14-in-1 ドッキングステーション」がセールで1万3990円に (2026年02月18日)

- ChatGPT連携で文章の要約や下書きもこなす電子ペーパーノート「iFLYTEK AINOTE Air 2」がセールで6万799円 (2026年02月18日)

- 5層の吸音材で極上のキータッチを実現した75%キーボード「EPOMAKER x Aula F75」が25%オフの1万490円に (2026年02月18日)

- 「UGREEN Revodok USB-C ハブ 6in1」が2000円で買える (2026年02月17日)

- 中小企業のビジネスPC調達は絶対に新品であるべきか? コスパを最大化する“中古/新古品”という選択肢の是非 (2026年02月19日)

- Copilot+ PCの「Dell 14 Plus」がセールで約12万円に (2026年02月19日)