目指すは「メタバース」ではなくて「新時代のPC」 Apple Vision Proに込められたAppleの“野心”:本田雅一のクロスオーバーデジタル(1/2 ページ)

6月5日(米国太平洋夏時間)、Appleの開発者会議「Worldwide Developers Conference 2023(WWDC23)」が開幕した。今回もオンラインとリアルのハイブリッド開催で、基調講演では新しいOSやデバイスが発表された。

WWDCの大きな目的は、Appleの多様なハードウェアと、それと統合されているソフトウェア(OS)の最新機能を開発者に紹介し、その活用を促すことにある。同社が開発するOSはiOS、iPadOS、macOS、watchOS、tvOS、audioOSと、ハードウェアに合わせて多岐に渡る。

“パーソナルコンピュータ”という視点に立つと、これらのうちiOS、iPadOS、そしてmacOSの3つが主軸となる。これらのうち、macOSではCPU(SoC)が自社設計の「Apple Silicon」に切り替わったことで、ハードウェアからOS、そしてアプリに至るまでiOSやiPadOSと同じ技術を利活用できるようになった。このことは、Macとそれ以外の製品の統合度を高め、見た目以上の進化を促している。

WWDC23は、この進化をより具体的に体感できる場となった……のだが、このこと以上にコンセプト面で驚きを与えるモノが出現した。「Apple Vision Pro」である。

今回は、この“新ジャンル”の製品について語ってみようと思う。

【更新:10時35分】追記を行いました

「ゴーグル」ではなく「新しいPC」を志向するApple Vision Pro

Apple Vision Proは、いわゆる「AR/VRゴーグル」にそっくりだ。しかし、そのコンセプトは「メタバース(仮想空間)」での利用を想定した従来のAR/VRゴーグルとは少し異なる。

メインのSoCはMacと同じ「Apple M2チップ」で、OSこそ専用の「visionOS」だが、iOS/iPadOSアプリも利用できる。アプリの操作は声、手のジェスチャー、視線移動やデジタルクラウンで行えるが、必要に応じてキーボード、マウスやゲームコントローラーをつなぐことも可能だ。

AppleはVision Proのことを「空間コンピュータ(Spatial Computer)」と呼んでいる。端的にいえばメタバースでの利用よりも、「ユーザーとインタラクション(相互作用)する、“新しい”パーソナルコンピュータ」という世界観を実現しようとしているのだ。

ゆえに、Vision Proは「現実空間」と「仮想空間」のバランスをユーザーの好みに応じて調整できるようになっている。この調整には、AirPodsシリーズなどで培ってきた空間オーディオやノイズキャンセリングの技術も活用されている。

とはいえ、基調講演のイメージ動画にもあるが、Appleはどちらかというと現実世界とシームレスに行き来できることに重きを置いていることは明らかである。高精細かつ広いダイナミックレンジで現実世界が投影され、その空間中にiPhone、iPadやMacと共通する基盤に基づくアプリが表示される――そういう世界観を目指しているのだ。

もちろん、visionOSに最適化したデザインのアプリであれば、これまでにない新しい体験を得られるかもしれない。基調講演では、The Walt Disney Companyのボブ・アイガーCEOがVision Pro(visionOS)に最適化されたアプリやコンテンツを提供することを表明している。

(3D描画を用いない)2Dアプリは、開発プロジェクトで「iPhone向け」「iPad向け」などとチェックボックスをつけて生成するように、visionOS向けのUI(ユーザーインタフェース)に沿う形で実装しておけば「ネイティブアプリ」を簡単に作れそうである。基調講演でMicrosoft 365アプリが動いていたことからも分かるだろう。

「空間に表示する」という特徴を活かし、他のAppleデバイスの画面を投影してリモート操作も可能だ。

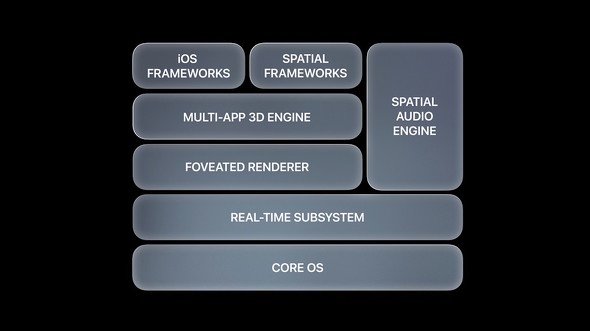

Vision Proの基盤となる「visionOS」は、iOS、iPadOSやmacOSと共通のコアを利用している。iOSアプリのフレームワークも実装しているので、iOS/iPadOSのアプリの多くも稼働する

Vision Proの基盤となる「visionOS」は、iOS、iPadOSやmacOSと共通のコアを利用している。iOSアプリのフレームワークも実装しているので、iOS/iPadOSのアプリの多くも稼働する発売当初から多くのアプリが利用できるということは、今までのAR/VRゴーグルにはない強みである。PCの周辺機器、あるいは「スマホをAV/VRゴーグルにしました」という従来の製品とは一線を画して、汎用(はんよう)的なコンピューティング基盤の1つとしてデザインされていることは注目すべきポイントといえる。

関連記事

さすがに約50万円は…… 「Apple Vision Pro」の廉価版は登場するのか? Proというネーミングの意図は

さすがに約50万円は…… 「Apple Vision Pro」の廉価版は登場するのか? Proというネーミングの意図は

米Appleが発表した「Vision Pro」は約50万円という価格で登場する。Proということは安価なモデルが登場するのだろうか。 Apple、“空間コンピュータ”をうたうMRヘッドセット「Vision Pro」発表 価格は約50万円

Apple、“空間コンピュータ”をうたうMRヘッドセット「Vision Pro」発表 価格は約50万円

米Appleが新カテゴリーとなるMRヘッドセット「Vision Pro」を発表した。 AppleがM2 Ultraを発表! MacのApple Siliconへの移行が完了

AppleがM2 Ultraを発表! MacのApple Siliconへの移行が完了

AppleがWWDC23において、M2ファミリーの最後のチップとして「M2 Ultra」を発表し、新型Mac StudioとMac Proで採用する。同時に、MacのApple Siliconへの移行完了を宣言した。 M2 Ultra搭載の新型「Mac Pro」発表

M2 Ultra搭載の新型「Mac Pro」発表

Appleがプロユース向けの新型「Mac Pro」を発表。SoCに新しい「M2 Ultra」を搭載し、PCI-Express(PCIe)拡張に対応した。 普段使いの利便性を高めた「macOS Sonoma」は2023年秋登場 低遅延の「ゲームモード」も

普段使いの利便性を高めた「macOS Sonoma」は2023年秋登場 低遅延の「ゲームモード」も

AppleがmacOSの新バージョンをリリースする。Apple Siliconをより生かす新機能が搭載される他、ゲーマーの取り込みを意図した「ゲームモード」も実装される。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 16GB版と8GB版のすみ分けが進むRTX 5060 Ti――HDD「完売」報道の影響は? 今週末のアキバパーツ事情 (2026年02月21日)

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- ルンバが日本のために本気を出した! 「Roomba Mini」が示す“小が大を兼ねる”新基準とは (2026年02月21日)

- モニター台とドッキングステーションが合体した「Anker USB-C ハブ 10-in-1 Monitor Stand」が28%オフの1万7990円で販売中 (2026年02月20日)

- 上下2画面で作業効率を大幅に高める「InnoView デュアル モバイルモニター」が36%オフの2万8212円に (2026年02月20日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 内蔵タッチパッドが変形する「EWiN 折りたたみワイヤレスキーボード」が24%オフの5319円で販売中 (2026年02月20日)

- 微細な造形を圧倒的な解像度で実現する3Dプリンタ「ELEGOO Saturn 4 Ultra 16K」が20%オフの7万2798円に (2026年02月20日)

- 繰り返し使える「充電式カイロ」5製品を試す そもそもリチウムイオン電池内蔵で温めても大丈夫? (2026年02月20日)

- ホール効果スティックで高耐久、精密な操作を実現する「BIGBIG WON BLITZ2 TMR コントローラー」がセールで9027円に (2026年02月19日)