WWDC 2025基調講演から見るAppleの“進む道” 「UIデザインの刷新」と「AI機能の深化」が大きなテーマに:本田雅一のクロスオーバーデジタル(2/4 ページ)

「Apple Intelligence」は“深化”を追求

Apple Intelligenceは、AppleのAI戦略の中核を成す包括的なシステムだ。OpenAIの「ChatGPT」やGoogleの「Gemini」は、デバイスの“外”にあるネットワークサービスであるのに対して、Apple Intelligenceはデバイスの中に集まる情報をAI技術で整理し、デバイスを通じて利便性を提供することに重きを置いている。

今回のWWDCでは、Apple Intelligenceのアップデートもアナウンスされた。

Apple IntelligenceのAIモデルをサードパーティーに開放

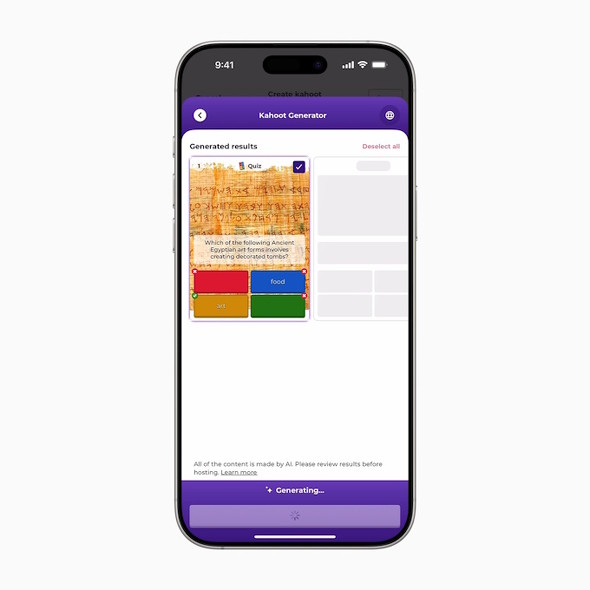

WWDC 2025における“目玉”の1つとして、アプリ開発者に対するApple Intelligenceで使っているAIモデルの開放が挙げられる。

Apple Intelligenceは、複数のAIモデルを組み合わせているが、特に完全オンデバイスのモデルを利用できるようになることで「応答時間の削減」「オフライン動作の保証」「プライバシー保護」を実現できる。

AIモデルは「Foundation Modelsフレームワーク」を通して利用可能で、開発者は自分のアプリにAI機能を統合しやすくなる。

プライベートクラウドコンピューティングの利用

WWDC 2024では、Apple Intelligenceの特徴として「プライベートクラウドコンピューティング」が発表された。これはより大規模なAIモデルが必要とされる場合に使われるもので、「暗号化」「匿名化」そして「一時的な処理」という3つの原則を徹底していることが特徴だ。

ユーザーデータは端末上で暗号化され、分割してサーバに送られる。そして処理が終わると即座に削除される。この設計により、クラウドの計算能力を活用しつつも、プライバシーを完全に保護することが可能となっている。

プライベートクラウドによるAI処理は、「Automation(オートメーション)」や新しい「Spotlight(スポットライト:検索機能)」から明示的に利用可能になる。

定番アプリにも「AI機能」をより深く統合

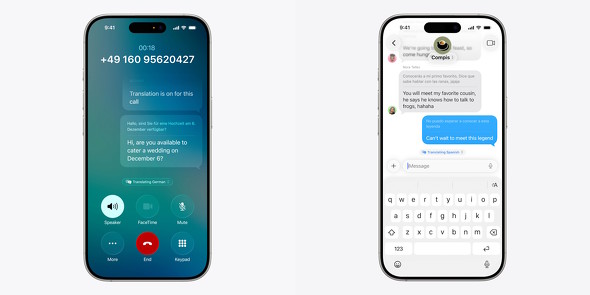

WWDC 2025で発表された各OSには、その場で逐次通訳/翻訳を行う「Live Translate(ライブ翻訳)」という機能が加わる。

ライブ翻訳機能の実装に当たっては「音声認識」「自然言語処理」「音声合成」という複数のAI技術を統合し、各アプリの機能として実装している。

例えば「Message(メッセージ)アプリ」では、会話スレッド全体の履歴から文脈を考慮した上で適切な翻訳を提供する。「FaceTimeアプリ」のリアルタイム翻訳キャプションは、オンデバイスならではの低レイテンシーを維持しながら、高精度な翻訳を動画コミュニケーションの中で実現する。そして「電話アプリ」での音声読み上げは、自分が発話した言葉を相手の言語でリピート発話する機能で(逆方向も可)、相手の話し方のニュアンスを文脈で保持しながら逐次通訳してくれる。

関連記事

Appleが全てのOSを共通のバージョン番号に統一

Appleが全てのOSを共通のバージョン番号に統一

Appleが年次イベント「WWDC25」で、全ての次期OSからバージョン番号を導入すると発表した。 なぜ“まだ使えない”Apple Intelligenceを推すのか? 新製品から見えるAppleの狙い

なぜ“まだ使えない”Apple Intelligenceを推すのか? 新製品から見えるAppleの狙い

Appleが、毎年恒例の9月のスペシャルイベントを開催した。順当に発表された新型iPhoneでは、生成AIを生かした「Apple Intelligence」が推されてるのだが、当のApple Intelligenceは発売時に使うことはできない。なぜ、発売当初に使えない機能を推すのだろうか。新製品の狙いを見ていこう。 “後出し”の生成AI「Apple Intelligence」がAppleの製品力を高める理由

“後出し”の生成AI「Apple Intelligence」がAppleの製品力を高める理由

生成AIにおいて出遅れを指摘されているAppleが、開発者向けイベントに合わせて「Apple Intelligence」を発表した。数ある生成AIとは異なり、あくまでも「Apple製品を使いやすくする」というアプローチが特徴だ。 ホテル予約、買い物──AIがWebサイトを人間のように操作する「Operator」は、AGI(汎用人工知能)への大きなステップだ 実際に試してみた

ホテル予約、買い物──AIがWebサイトを人間のように操作する「Operator」は、AGI(汎用人工知能)への大きなステップだ 実際に試してみた

本記事では、Operatorの技術的背景と特徴、さらに実際に使ってみての可能性など考えてみることにしよう。 “暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

“暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

OpenAIの新言語モデル「GPT-4.5」のリサーチプレビュー版をリリースした。従来の「GPT-4」と何が変わったのか、実際に試しつつ解説する。【更新】

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- 「iPhone 17e」実機レビュー! 9万9800円で256GB&MagSafe対応 ベーシックモデルの魅力と割り切り (2026年03月09日)