手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説:“超”初心者向けローカルAI「gpt-oss」導入ガイド(1)(1/4 ページ)

2022年末にOpenAIが「ChatGPT」をリリースしたことを皮切りに生成AIブームが巻き起こり、今では業務に欠かせない製品にまで成熟してきた。

ChatGPTやCopilot、Geminiといったクラウドサービスは基本的な範囲であれば無償で利用できるが、入力されたデータが学習されてしまったり、利用回数の制限があったりする。そうした制限を取り払い、プライバシーに配慮して利用したい場合は、別で有償プランを契約する必要が出てくる。

特にこれらは他のサブスクリプションサービスと比べて月額費用が高い。個人での利用はハードルが少し高いのが現状だ。できれば費用を抑えつつ、プライバシーに配慮して生成AIをしたいところだが、何か良いものはないだろうか、とお悩みの方も居るのではないだろうか。

さて、そんな方にこの悩みを非常にシンプルな方法で解決できる方法を紹介したい。それが「ローカルLLM」だ。

手元のPC上で生成AI機能が利用できる「ローカルLLM」

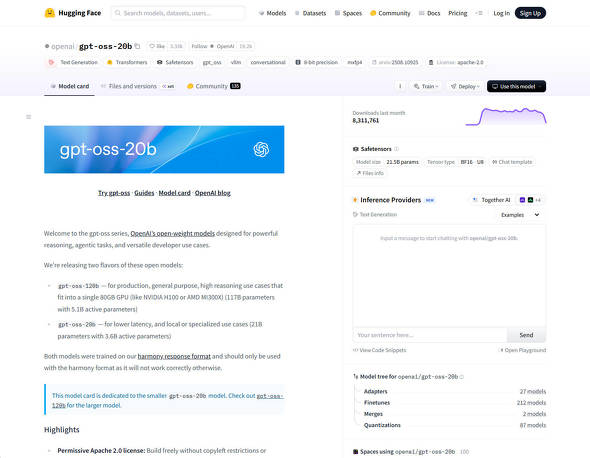

ローカルLLMとは読んで字のごとく、クラウドサービスではなく手元のPCやサーバ上で「DeepSeek R1」や今話題のオープンウェイトリーズニングモデル「gpt-oss」といったLLM(大規模言語モデル)を動かすことを指す。

クラウドサービスと違い、入力したデータは手元のPCやサーバ上で処理されるため、サブスクリプション契約を結ばずとも、安全に生成AIを利用できるため、ローカルLLMの導入は大きなメリットを享受できる。

しかし、今までは導入に至るまで、CLIでのコマンド操作などが必要で、一定の障壁があったのだが、近年は非常に簡単に導入できるようになりつつある。

とはいえ、専用ソフトの導入などが必要なことには変わりない。そこで本連載では、ローカルLLMの導入方法から活用方法に至るまでを初心者の方にも分かりやすく解説していこう。

関連記事

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう! 生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

Qualcommは自社のSnapdragon Xシリーズを搭載するPCを強く訴求している。しかし、COMPUTEX TAIPEI 2025に合わせて設置したプライベート展示場に足を向けると、なぜかx86 PCが主体となって展示されているコーナーがあった。どうやら、Qualcommの“新製品”が展示されているそうだ。 OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、8月3日週を中心に公開された主なニュースを一気にチェックしましょう! なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

「AI PC」がマーケティング上の流行語になって1年少々。AIの処理を効率良く行えるNPUを搭載するCPUもバリエーションがそろってきた。AI PCを選ぶメリットはどこにあるのか、HPのエグゼクティブ2人に話を聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「iPhone 17e」実機レビュー! 9万9800円で256GB&MagSafe対応 ベーシックモデルの魅力と割り切り (2026年03月09日)

- 「GeForce NOW」がサービスをアップデート Apple Vision ProやMeta Questで最大90fpsのゲーミングが可能に (2026年03月11日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)