Intelラウンジに見た「Core Ultraプロセッサ(シリーズ3)」活用術:CES 2026(2/3 ページ)

GPU内蔵の「XMX」を使ったデモ

Core Ultraプロセッサ(シリーズ3)の内蔵GPU「Xe3 GPU」に内包された推論アクセラレーターであるXMXは、基本的に先代の「Xe2アーキテクチャ」におけるXMXと大きく変わりがない。Xe3 GPUの最上位に当たる「Intel Arc B390」の公称ピーク性能は120TOPS(毎秒120兆回)だが、この性能は以下の計算式から導出されたものだ。

12(Xeコアの数)×4096(OPS)×2.44(GHz)=120TOPS

このデモコーナーでは、Core Ultraプロセッサ(シリーズ3)マシンのローカル環境で動作可能な言語空間の生成AIを動作させる実演と、実際に来場者がデモマシンに触れる機会が与えられた。

1つ目は、HPの14型ノートPC「HP EliteBook X G2i 14-inch」のCore Ultra X7 358H/32GBモデルに、Iternal Technologiesが開発したフルローカル動作可能なAIアシスタント「AirgapAI」を組み合わせたデモンストレーションだ。

AirgapAIは、Meta製の「Llama 3.2」(1B/3B)、Google製の最新軽量モデル「Gemma」(9B)、Microsoft製の「Phi-3.5」「Phi-4」など、どちらかと言えば小規模言語モデル(SLM)にカテゴライズさせられるAIを内包している。現地のデモ機では、AirgapAIに対してCES 2026の基調講演のプレゼン資料を読み込ませた状態となっており、今回の発表内容について聞くことができるようになっていた。

ちょっと意地悪かもしれないが、筆者はここで、基調講演で触れられなかったUltraの付かないPanther Lake世代のCPU「Coreプロセッサ(シリーズ3)」について質問したところ、ややトンチンカンな回答が返ってきた。

「えー、トンチンカンじゃなぁ」と思ったかもしれないが、実はややトンチンカンな答えを返す挙動こそが“正解”なのだ。というのも、このAirgapAIは、“Airgap”と名前が付く通り、ネットワークから物理的に隔絶された状態で稼働する(推論を行う)ことを売りとしているアシスタントなのだ。外部サーバへの通信は、設定を変更しない限り行われない。

つまり、ローカルで保有しているデータ以上の受け答えができないのは当然というわけである。

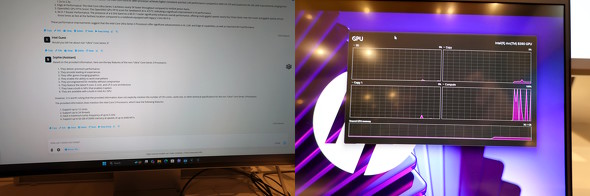

このデモンストレーションで使われたAirgapAIは、標準モードでは外部サーバへの通信を一切行わないことが特徴で、Core Ultraプロセッサ(シリーズ3)では、NPUではなくGPU内蔵のXMXが利用される。そのため、AirgapAIが稼働するたびにGPU内のComputeの方に負荷がかかるようになっている

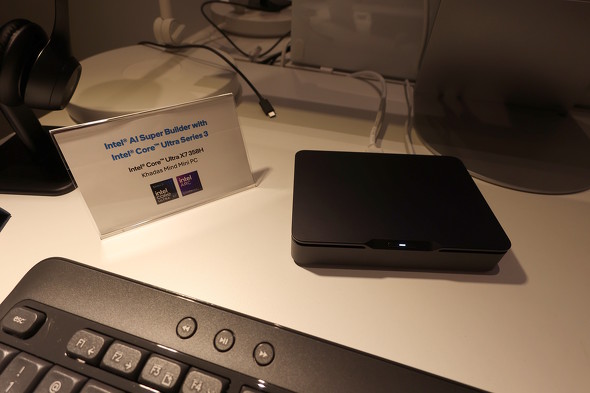

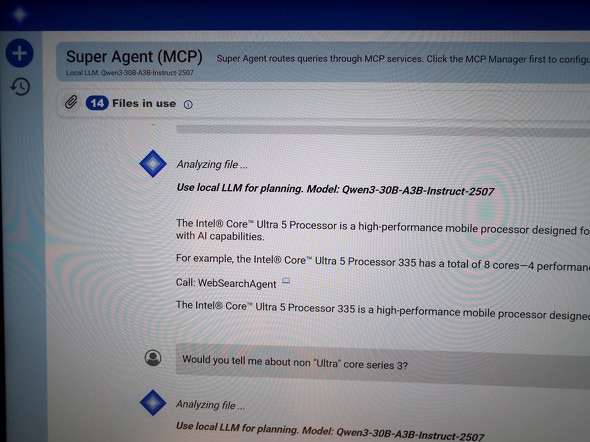

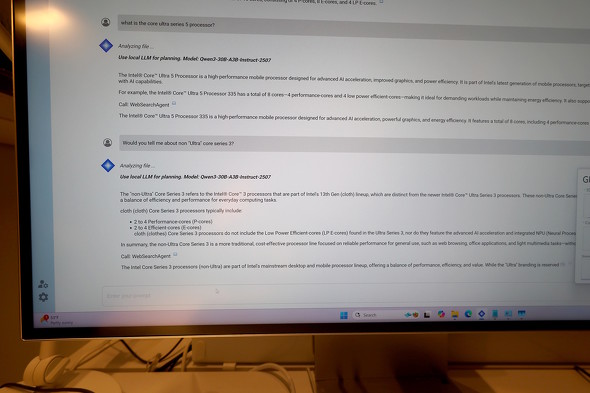

このデモンストレーションで使われたAirgapAIは、標準モードでは外部サーバへの通信を一切行わないことが特徴で、Core Ultraプロセッサ(シリーズ3)では、NPUではなくGPU内蔵のXMXが利用される。そのため、AirgapAIが稼働するたびにGPU内のComputeの方に負荷がかかるようになっている2つ目は、Khadas Mindの「Mini PC」のCore Ultra X7 358H/96GBモデルに「Super Agent+MCP」を組み合わせたデモンストレーションだ。先ほどと同じようにUltraの付かないCoreプロセッサ(シリーズ3)について質問したところ、こちらは“正しい”返答を得ることができた。

ちなみにSuper Agent+MCPは「Intel AI Assistant Builder」の機能名で、ローカル動作させたLLMにRAG(検索拡張生成)機能を統合した仕組みのことを指す。「MCP」はModel Context Protocolの略で、ベースシステムのAIに足りない情報(知識)を外部ツールや外部ネットワーク上のサーバに求めるためのオープン規格となる。

こちらのデモ機でローカル動作していたのは、Alibaba CloudのLLM「Qwen3-30B-A3B」だ。これは体感レスポンスを稼ぎやすい「MoE(Mixture of Experts)」と呼ばれるLLMの一種だ。名前からも察せる通り、総パラメーターは30B(300億)規模ではあるが、推論時には1トークン当たり3B(30億)パラメータのみを採用する仕組みが取り入れられている。簡単にいえば「知識の書庫は30Bもあるが、推論する知能は3B程度」といった感じとなる。得られた回答はシンプルとはいえ間違えてはおらず、正しい返答になっている。

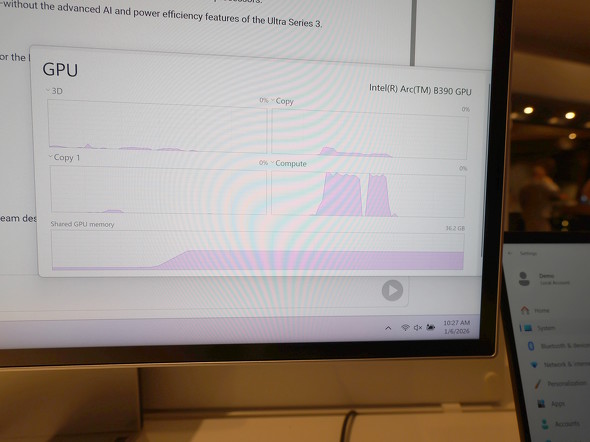

こちらも、NPUではなくXMXで動作するため、タスクマネージャではGPUの「Compute」の方に負荷がかかる。高負荷な時間は2回に分かれており、一旦負荷が収まる挙動となったのは、このタイミングで基調講演では触れられなかった「Coreプロセッサ(シリーズ3)」の情報を探索に出かけた証左といえる。

1台目のデモは完全ローカル動作かつ外部情報探査なしのSLM系AI、2台目のデモは基本はローカル動作で、足りない知識は外部に求めるタイプのLLM系AIだったが、いずれも「Core Ultraプロセッサ(シリーズ3)ならバッチリ動くよ」という意味で強いアピールにはなる。

ただし、この手の言語系生成AIをローカルで動かそうとするとメインメモリが多く必要となるのは言うまでもない。

「Davinci Resolve」のMagic Mask機能がXMX対応

GPUに内蔵されているXMXは、AI機能の中でも特に映像やグラフィックスに対する処理系が得意だ。その事例としてIntelが紹介していたのが、BlackMagicの映像編集アプリ「Davinci Resolve」の機能の1つ「Magic Mask」だ。

Magic Maskでは映像内の特定の人物や物体をAIが自動で認識し、フレームが進んで適用対象物が移動したり変形しても、その領域を正確に追従するマスクを動的に作成できる。AI登場以前であれば、1フレームずつ手作業で作らなければならなかったところ、Magic Maskを使えば編集画面でマスク対象としたいオブジェクトをクリックするだけで、そのオブシェクトだけを追跡するマスクを生成可能だ。

今回のデモンストレーションでは、「スケートボード競技者の衣服の色を変える」というお題が課せられていた。編集中のフレームよりも時間軸上の前方向と後方向の両方に追跡をかけて、見事にマスクを生成していたのが印象的だった。

なお、このデモではマスク生成中にXMXへと高い負荷がかかり続けたが、一度生成処理が終わると、編集画面ではほとんどXMXには負荷がかからなくなっていた。

このデモでは、Lenovoのディスプレイ一体型デスクトップPC「Yoga AIO」(Core Ultra X7 358H搭載)が使われた。一見するとディスプレイにしか見えないのだが、スタンド部にPCとしての機能が詰め込まれている

このデモでは、Lenovoのディスプレイ一体型デスクトップPC「Yoga AIO」(Core Ultra X7 358H搭載)が使われた。一見するとディスプレイにしか見えないのだが、スタンド部にPCとしての機能が詰め込まれているちなみに、筆者が調べた限りにおいて、Magic Mask機能はNVIDIAの「Tensorコア」、Appleの「Neural Engine」、AMDの「Radeon AIアクセラレーター(WMMA)」に対応していたが、IntelのXMXに対応したのは2022年の「Intel Arc A700 Graphicsシリーズ」からであった。 CPU内蔵GPUのXMXは、先代の「Core Ultra 200Vプロセッサ」(開発コード名:Lunar Lake)から対応している。

とはいえ、映像編集アプリにおけるAI支援機能が、CPU内蔵GPUへの対応が着々と進んでいることを示すには悪くない。今や単体GPUがなくても、ある程度のAI機能が利用できるようになったということなのだ。

関連記事

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表 搭載製品は1月27日(米国太平洋時間)から順次出荷

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表 搭載製品は1月27日(米国太平洋時間)から順次出荷

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表した。搭載モデルは1月27日(米国太平洋時間)から順次出荷される。【訂正】 「Core Ultra(シリーズ3)」はワッパ重視の“バッテリー寿命王”――Intelが激推しする背景から見える戦略

「Core Ultra(シリーズ3)」はワッパ重視の“バッテリー寿命王”――Intelが激推しする背景から見える戦略

Intelが、ついに「Core Ultraプロセッサ(シリーズ3)」を正式発表した。CES 2026で行われたキーノートの主役も、もちろんこのCPUだった。どんなキーノートだったのか、その模様をお伝えする。 Intelの新型CPU「Core Ultraプロセッサ(シリーズ3)」を支える「Intel 18A」と「PowerVia技術」を見てきた

Intelの新型CPU「Core Ultraプロセッサ(シリーズ3)」を支える「Intel 18A」と「PowerVia技術」を見てきた

Intelの最新CPU「Core Ultraプロセッサ(シリーズ3)」と「Xeon 6+プロセッサ」(Eコア)のComputeタイル(CPUコア)は、自社の最新プロセス「Intel A18」で作られている。その特徴を詳しく解説しよう。 Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の改良点をさらに深掘り 今後の取り組みもチェック!

Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の改良点をさらに深掘り 今後の取り組みもチェック!

Intelが2025年末に一部を出荷する予定の「Core Ultraプロセッサ(シリーズ3)」(開発コード名:Panther Lake)は、「Xe3 GPU」なる新しいGPUコアを搭載する。この記事では演算エンジン回りを中心に、Xe3 GPUをもう少し深掘りしていく。 Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の全体像を解説 完全な新世代ではないものの用途に合わせた最適化がポイント

Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の全体像を解説 完全な新世代ではないものの用途に合わせた最適化がポイント

Intelが2025年末に一部を出荷する予定の「Core Ultraプロセッサ(シリーズ3)」(開発コード名:Panther Lake)は、「Xe3 GPU」なる新しいGPUコアを搭載する。この記事では、Xe3 GPUの概要をお伝えする。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- 宅内ネットワーク環境の10G化に適した「TP-Link DS108X」が13%オフの4万803円に (2026年02月06日)

- 自宅のどこでも本格サウンドが楽しめる「Bose SoundLink Home Bluetooth Speaker」が3.3万→2.3万円に (2026年02月05日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- ロジクールの「MX MASTER 4」とマウスパッドのセットが1万9400円に (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)

- Insta360初ドローン「Antigravity A1」実機レポ 360度カメラが生む“空中を自由に見渡す”没入感とは? (2026年02月06日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)

- 240Hz駆動の39型曲面ウルトラワイド有機EL「LG UltraGear OLED」が27%オフの14万4000円に (2026年02月05日)

- Surface RT「歴史的大失敗」の裏で何が? エプスタイン文書が示すMS元幹部の焦りと情報漏えい (2026年02月05日)