Intelラウンジに見た「Core Ultraプロセッサ(シリーズ3)」活用術:CES 2026(1/3 ページ)

Intelは1月6日から9日まで(米国太平洋時間)、「CES 2026」においてショールーム「Intel Lounge」を開設した。このショールームでは、会期前日に発表された「Core Ultraプロセッサ(シリーズ3)」(開発コード名:Panther Lake)が持つ、多彩なポテンシャルを体感できた。

会期中、Intel Loungeを訪れる機会を得たので、その様子をレポートしたい。

Panther Lakeの「推論アクセラレーター」は1つじゃない

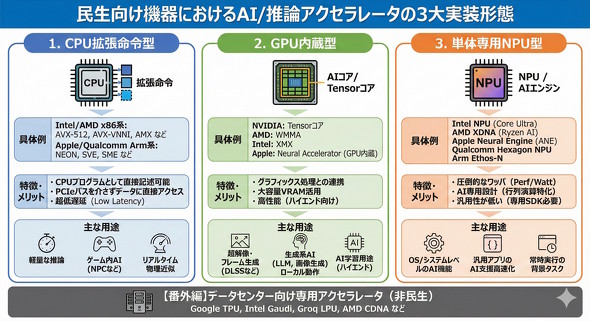

現在、あらゆるIT機器に「推論(AI)アクセラレーター」が搭載されつつあるが、その実装形態は大きく分けると3パターンあることをご存じだろうか。

1つ目は、CPUの拡張命令として実装されるスタイルだ。Core Ultraプロセッサ(シリーズ3)だと「AVX-VNNI」「AVX-VNNI-INT8」「AVX-VNNI-INT16」「AVX-NE-CONVERT」「AVX-IFMA」などが該当する。

このタイプの推論アクセラレーターは、CPU用プログラムとして直にコーディングできる特徴があり、PCI Expressバスを介さずに直接データ群にアクセスできること、既存のCPUコードとの連携がしやすいことから、主に軽量な推論を超低遅延で運用する用途に用いられる。

2つ目は、GPUに推論アクセラレーターを内蔵するスタイルだ。Core Ultraプロセッサ(シリーズ3)だと、GPUタイルに内包された「XMX(Xe Matrix Extensions)」がそれに当たる。

GPU内蔵スタイルの推論アクセラレーターは、主にAI支援をグラフィックス処理系に適用する目的で活用されることが多い。具体的には「超解像処理」「フレーム生成」「アンチエイリアス処理」などが用途の定番だ。AI支援で高度な表現を実践する「ニューラルレンダリング」も、昨今では注目を集めつつある。

また、大容量のグラフィックスメモリが搭載されている場合は、GPU単体でLLM(大規模言語モデル)/SLM(小規模言語モデル)や拡散モデルといった生成AIをローカルで動作させる際にもGPU内蔵型の推論アクセラレーターが活用される。

3つ目は、CPUやGPUには統合されない、単体の専用推論アクセラレーターだ。これは「NPU(Neural Processing Unit)」と呼ばれることもあり、Core Ultraプロセッサ(シリーズ3)では「Intel AI Engine」がそれに相当する。

NPUは“専用”ということでAI処理、もっというと推論処理で用いられる演算に特化している「固定機能プロセッサ」に近い位置付けだ。消費電力当たりの性能、いわゆるワッパが圧倒的に優れているという特徴がある。

今回のIntel Loungeでは「GPU内蔵スタイル」「専用アクセラレータースタイル」の推論アクセラレーターの活用事例を体験できるようになっていた。

なお、1つ目に紹介した「CPUの拡張命令スタイル」の推論アクセラレーターは、ゲームなどではNPC(ノンプレイヤーキャラクター)などの「意志決定AI」や「リアルタイム物理シミュレーションの近似」などで採用事例がある。

しかし、これらの事例はユーザーに分かりやすく見せてアピールすることが難しいこと、またこの実装スタイルは競合のCPUでもおおむね同様に実践できるため「Intelならでは」をアピールしづらい。もっというと、昨今のRyzenシリーズが「AVX-512」系の命令にフル対応している分、CPU拡張命令スタイルでは「AMDがIntelより先行している」というイメージも強まっている。

これらの事情もあって、今回のデモでは意図的にCPU拡張命令スタイルの推論アクセラレーターを取り上げなかったのかもしれない。

関連記事

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表 搭載製品は1月27日(米国太平洋時間)から順次出荷

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表 搭載製品は1月27日(米国太平洋時間)から順次出荷

Intelがモバイル向け「Core Ultraプロセッサ(シリーズ3)」を正式発表した。搭載モデルは1月27日(米国太平洋時間)から順次出荷される。【訂正】 「Core Ultra(シリーズ3)」はワッパ重視の“バッテリー寿命王”――Intelが激推しする背景から見える戦略

「Core Ultra(シリーズ3)」はワッパ重視の“バッテリー寿命王”――Intelが激推しする背景から見える戦略

Intelが、ついに「Core Ultraプロセッサ(シリーズ3)」を正式発表した。CES 2026で行われたキーノートの主役も、もちろんこのCPUだった。どんなキーノートだったのか、その模様をお伝えする。 Intelの新型CPU「Core Ultraプロセッサ(シリーズ3)」を支える「Intel 18A」と「PowerVia技術」を見てきた

Intelの新型CPU「Core Ultraプロセッサ(シリーズ3)」を支える「Intel 18A」と「PowerVia技術」を見てきた

Intelの最新CPU「Core Ultraプロセッサ(シリーズ3)」と「Xeon 6+プロセッサ」(Eコア)のComputeタイル(CPUコア)は、自社の最新プロセス「Intel A18」で作られている。その特徴を詳しく解説しよう。 Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の改良点をさらに深掘り 今後の取り組みもチェック!

Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の改良点をさらに深掘り 今後の取り組みもチェック!

Intelが2025年末に一部を出荷する予定の「Core Ultraプロセッサ(シリーズ3)」(開発コード名:Panther Lake)は、「Xe3 GPU」なる新しいGPUコアを搭載する。この記事では演算エンジン回りを中心に、Xe3 GPUをもう少し深掘りしていく。 Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の全体像を解説 完全な新世代ではないものの用途に合わせた最適化がポイント

Core Ultraプロセッサ(シリーズ3)の「Xe3 GPU」の全体像を解説 完全な新世代ではないものの用途に合わせた最適化がポイント

Intelが2025年末に一部を出荷する予定の「Core Ultraプロセッサ(シリーズ3)」(開発コード名:Panther Lake)は、「Xe3 GPU」なる新しいGPUコアを搭載する。この記事では、Xe3 GPUの概要をお伝えする。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- Insta360初ドローン「Antigravity A1」実機レポ 360度カメラが生む“空中を自由に見渡す”没入感とは? (2026年02月06日)

- 自宅のどこでも本格サウンドが楽しめる「Bose SoundLink Home Bluetooth Speaker」が3.3万→2.3万円に (2026年02月05日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- Surface RT「歴史的大失敗」の裏で何が? エプスタイン文書が示すMS元幹部の焦りと情報漏えい (2026年02月05日)

- 「VAIO SX14-R」の“ふるさと”見学記 ノジマグループ参画後も進化が続く“物作り” (2026年02月05日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- フロッピー世代に刺さるレトロなデザインが魅力の「Trozk モバイルバッテリー TP09U」が19%オフの8080円に (2026年02月05日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)

- 宅内ネットワーク環境の10G化に適した「TP-Link DS108X」が13%オフの4万803円に (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)