AppleがiPhone/iPadの新アクセシビリティ機能を発表 簡易ホーム画面や自分の音声作成など

米Appleが5月16日(現地時間)、iPhone/iPadユーザーのアクセシビリティに関する新機能を発表した。2023年後半以降の提供予定としている。

新機能は主に認知、視覚、聴覚、身体に障害を持つ人にフォーカスしたもの。認知障がいのあるユーザーをサポートする「Assistive Access」、発話を補助する「Live Speech」「Personal Voice」、拡大鏡の操作を簡単にする「Point and Speak」の4項目に分かれる。

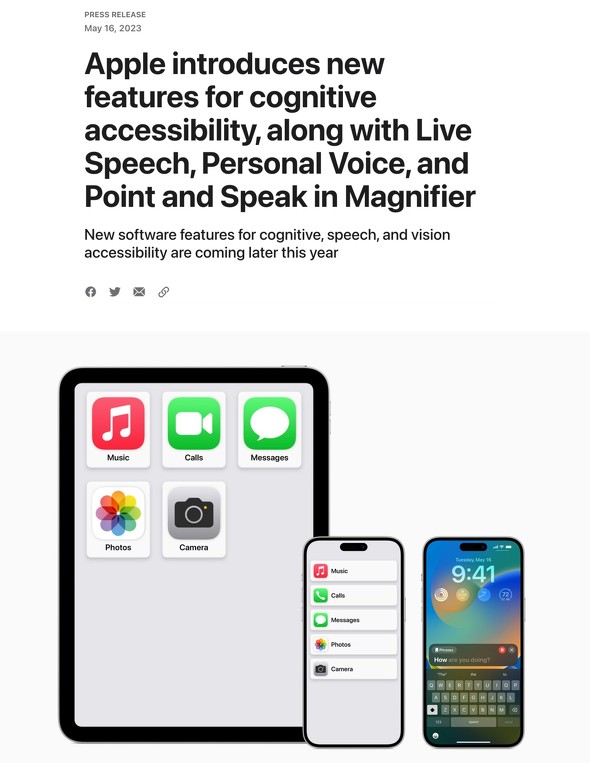

Assistive Access

Assistive Accessは認知的負担の軽減を目的に、必要最低限のアプリ、情報を表示できるようにする。ホーム画面に並ぶのはCalls(電話とFaceTime)、メッセージ、カメラ、写真、ミュージックのみで、通常のホーム画面のように多くのアプリアイコンやウィジェットは表示されない。アプリのレイアウトはグリッドベースか行ベースのどちらかを選択できる。

Callsにはよく利用する相手のアイコンと名前、メッセージには絵文字のみのキーボードや、ビデオメッセージを他者と共有できるオプションが用意される。カメラにはシャッターアイコン、写真はサムネイルがタイル表示される。ミュージックには再生/一時停止、再生中の楽曲などが表示される。いずれもアイコンや文字が通常より大きく、利用者に配慮したUIとなっている。

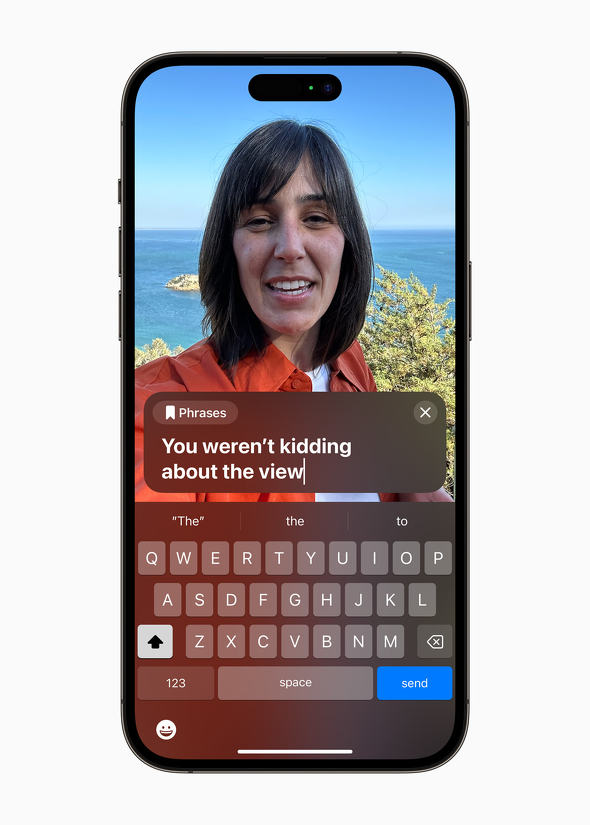

Live Speech

Live Speechは電話、FaceTime通話、対面での会話中に自分が話したいことをタイプすることで、その内容を読み上げてくれる機能。いわゆる筆談に相当するものだ。発話できないか徐々に発話能力を失っている、世界中の何百万人もの人々をサポートするために設計されたという。iPhone/iPadに加え、Macも対象となっている。

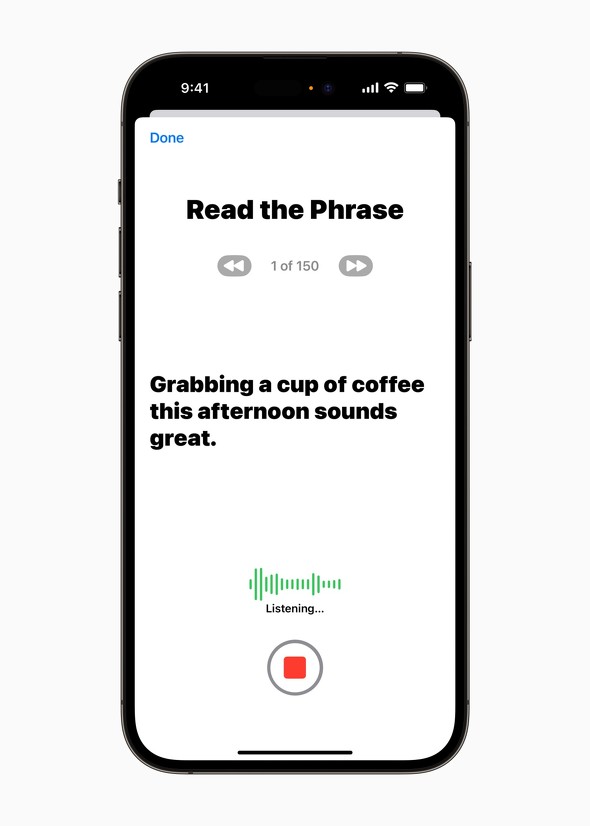

Personal Voice

Personal Voiceは自分が話しているように聞こえる声をシンプルかつ安全に作成できる機能。iPhone/iPadでランダムに選ばれたテキストプロンプトのセットを読み、音声を15分間録音することで、Personal Voiceを作成できる。端末上の機械学習を使って、ユーザー情報のプライバシーとセキュリティを保護するという。

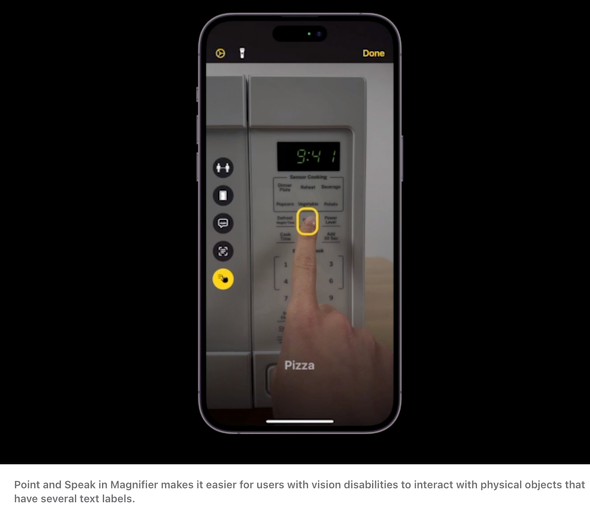

Point and Speak

Point and SpeakはiPhone/iPadの拡大鏡に備わる機能の1つ。複数のテキストラベルが備わる対象物にiPhone/iPadのカメラを向けると、ユーザーが指し示したテキストラベルの内容が黄色い枠で囲われ、それと同時に音声で内容を読み上げてくれる。なお、Point and SpeakはiPhone/iPadのカメラやLiDARスキャナーなどで成り立つ機能だという。

幅広いユーザーを分かりやすくアシスト

Appleはこれまで一貫性のあるUIや製品作りに注力してきた企業で、ティム・クックCEO(最高経営責任者)も「テクノロジーを利用しやすくしてきた、われわれの長い歴史に基づく新機能の数々を発表した」とコメントしている。

アクセシビリティポリシーおよびイニシアティブ担当シニアディレクターのサラ・ヘルリンガー氏は「あらゆる段階で障がい者コミュニティのメンバーからフィードバックを受けてデザインされた」と述べており、Appleがさまざまな障害者を代表する地域団体と密接に協力したという。

従来からアクセシビリティーに関する機能が備わっているApple製品。新機能により幅広いユーザーを分かりやすくアシストできそうだ。

関連記事

Apple、「iOS 16.4」配信 新絵文字や通話音声改善など新機能多数

Apple、「iOS 16.4」配信 新絵文字や通話音声改善など新機能多数

Appleは「iOS 16.4」の配信を開始した。Wi-Fiマークなど21の新しい絵文字が追加される。「音の分離」のセルラー通話対応や30件以上のセキュリティ修正もある。 iPhoneをルーペ代わりに iOS 15で標準アプリになった「拡大鏡」の使い方

iPhoneをルーペ代わりに iOS 15で標準アプリになった「拡大鏡」の使い方

これまで「設定」の「アクセシビリティ」に格納されていたが、iOS 15で標準アプリとなった「拡大鏡」を使ってみる。カメラと似た使用感だが、見たいものを即座に確認したり、色調を補正できたりする点で便利なアプリだ。 「まだiOS 15にしたくない」ならiOS 14を使い続ける選択肢も

「まだiOS 15にしたくない」ならiOS 14を使い続ける選択肢も

iOS 15が9月にリリースされたが、まだアップデートをしていない、あるいはしたくないという人もいるだろう。実は、iOS 14では重要なセキュリティアップデートだけを適用する選択肢が用意されている。具体的な手順を確認していこう。 iOSのアクセシビリティを知ろう!――VoiceOver設定編

iOSのアクセシビリティを知ろう!――VoiceOver設定編

iPhoneのアクセシビリティ機能とはどんなものなのか? まずはジェスチャー操作と音声フィードバックを提供するUIの「VoiceOver」をテーマに、その意義を解説する。 アクセシビリティの設定を見直すだけで使いやすさがアップ

アクセシビリティの設定を見直すだけで使いやすさがアップ

iOS 7に搭載された「アクセシビリティ」は、これまで以上に役立つ機能が満載だ。設定を見直すだけで節電効果を得ることもできる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 【無印良品】ウエストポーチもになる「スリングバッグ」が3990円に値下げ中 植物由来の原料を使用 (2026年03月11日)

- Qualcommのウェアラブル新チップが「Elite」を冠する理由 最新モデム「X105」は衛星通信100Mbpsへ (2026年03月11日)