まるで“ファンミーティング”な熱気 NVIDIA基調講演でフアンCEOは何を語ったのか?:COMPUTEX TAIPEI 2025(3/3 ページ)

AIの進化にはハードウェアの進化も欠かせない

フアンCEOが語ってきたことのうち、ハイブリッドコンピューティングやAIに関する取り組みはより高速なコンピューティングパフォーマンスを求められる。そこでNVIDIAでは1年ごとに製品を「リズムのようにアップデートしていく」ことで、パフォーマンスの向上を図っていく方針だ。

その一例として、2024年後半に出荷を開始したSoC「NVIDIA GB200 Grace Blackwell Superchip」について、2025年第3四半期をめどに「NVIDIA GB300 Grace Blackwell Ultra Superchip」にアップグレードするという。

GB300はGB200と「BlackwellアーキテクチャのGPUを『NVIDIA Grace CPU』を介して2基連結する」という基本設計は引き継ぎつつも、メモリの容量を約1.5倍(1基当たり372GB→576GB)、CPUメモリの帯域幅を約2倍(毎秒480GB→800GB)に引き上げることで、推論演算の性能を最大1.5倍に引き上げたものだ。

このGPUの登場に伴い、GB200を36基連結した水冷ラックシステム「NVIDIA GB200 NVL72」も、GB300を36基連結した「NVIDIA GB300 NVL72」に刷新される。NVL72という部分に変更がないことからも分かる通り、ラック自体に変更はなくハードウェアの設計を変えずに性能が確実に向上するという点がメリットとなる。

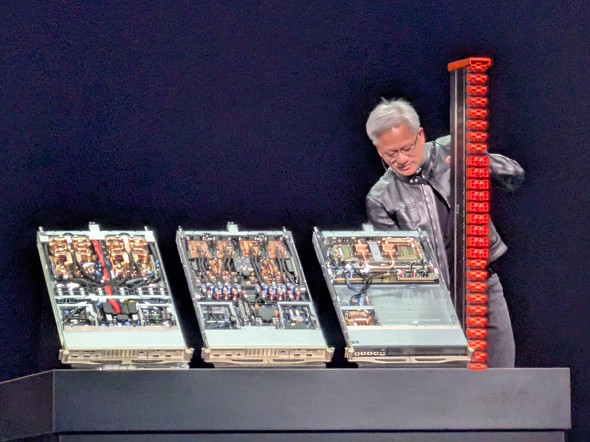

NVL32には、1台当たり8基のSoCを搭載する「コンピューティングノード」(ブレード)を8基搭載している。フアンCEOが手を伸ばしているのが、新しいNVIDIA GB300 NVL72のブレードで、その左側にあるNVIDIA GB300 NVL72のブレードと比べると完全水冷化したことを除くと構造に変更はない。なお、GB300 NVL72の右側にあるのが、ブレード同士を結ぶための「NVSwitch」と呼ばれるスイッチとなる

NVL32には、1台当たり8基のSoCを搭載する「コンピューティングノード」(ブレード)を8基搭載している。フアンCEOが手を伸ばしているのが、新しいNVIDIA GB300 NVL72のブレードで、その左側にあるNVIDIA GB300 NVL72のブレードと比べると完全水冷化したことを除くと構造に変更はない。なお、GB300 NVL72の右側にあるのが、ブレード同士を結ぶための「NVSwitch」と呼ばれるスイッチとなる フアンCEOが手にしているのは、NVL72においてNVSwitchやブレードを結ぶために作られた「奇跡」こと、「NVLinkスパイン」だ。内部には全長2マイル(約3.22km)のケーブルが入っており、「(世界中の)インターネットのピークトラフィックを通せる」だけの通信を行える。当然、重量はそれなりにある

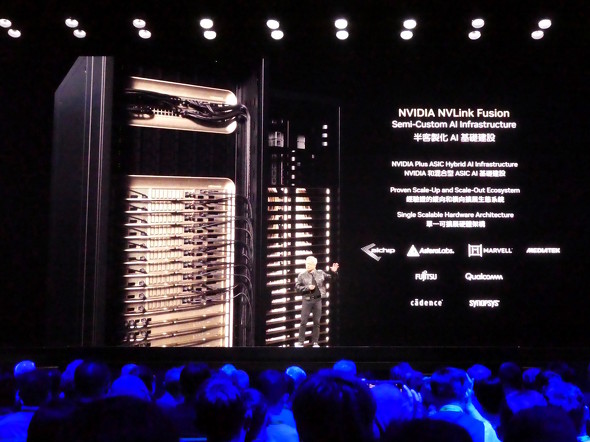

フアンCEOが手にしているのは、NVL72においてNVSwitchやブレードを結ぶために作られた「奇跡」こと、「NVLinkスパイン」だ。内部には全長2マイル(約3.22km)のケーブルが入っており、「(世界中の)インターネットのピークトラフィックを通せる」だけの通信を行える。当然、重量はそれなりにあるNVL72でSoCの連結に使われているのが「NVLink」という仕組みだ。従来、NVLinkはNVIDIA製のGPU同士、あるいは同社製のCPUとGPUとの連結に限り使うことができたが、今回「NVLink Fusion」と銘打って一部の他社製CPUにもNVLinkを開放することになった。

NVLink Fusionに対応するCPUはQualcommや富士通から登場する予定の他、一部のカスタム半導体メーカーにおいて本機能を組み込んだASIC(特定用途向けIC)を製造できるようになる。

ただし、NVLink Fusionを利用できるのはNVIDIA製のNVLink対応GPUと組み合わせた場合のみとなる。

「手元でAI演算を」という観点では、手元でそこそこの演算能力を備えるコンピュータを用意したいというニーズもある。そこでNVIDIAはタワー型AIコンピュータ「DGX Station」を展開してきた。

従来のDGX StationはNVIDIAによって販売されてきたが、BlackwellアーキテクチャのDGX StationについてはパートナーのPCメーカーと共に展開する。また、DGX Stationよりもコンパクトな選択肢として「DGX Spark」も合わせて投入する。こちらも、パートナーのPCメーカーと共に展開する。

DGX Sparkは手のひらで持てるほどのコンパクトさが特徴で、ピーク時に1PFLOPSのAI演算パフォーマンスを発揮できることが特徴だ。発売は7月を予定している。

DGX Stationはより高いパフォーマンスを求めるユーザー向けのデスクトップ製品で、ピーク時に20PFLOPSのAI演算パフォーマンスを発揮する。発売は2025年後半となる見通しだ。

両者共にそのサイズからは想像できない高い処理パフォーマンスを備えていることが特徴で、フアンCEOは「クリスマスには両者を選べるようになる」と語っていた。

フアンCEOが左手に持っているのが、DGX Sparkの自社設計版(コンシューマー向けグラフィックスカードにおけるFounders Editionに相当)だ。左にあるのは初代DGX Station(DGX-1)の“ベゼル”だ。DGX-1の本体は重たいようで、ベゼルだけの登場となったという。ある意味で、DGX Sparkのコンパクトさと軽さが際立つ演出といえる

フアンCEOが左手に持っているのが、DGX Sparkの自社設計版(コンシューマー向けグラフィックスカードにおけるFounders Editionに相当)だ。左にあるのは初代DGX Station(DGX-1)の“ベゼル”だ。DGX-1の本体は重たいようで、ベゼルだけの登場となったという。ある意味で、DGX Sparkのコンパクトさと軽さが際立つ演出といえるそしてエージェントAIを実現する「(エンタープライズ)コンピューティングを再発明する」ための新たな提案として、「RTX Proサーバシリーズ」を展開する。

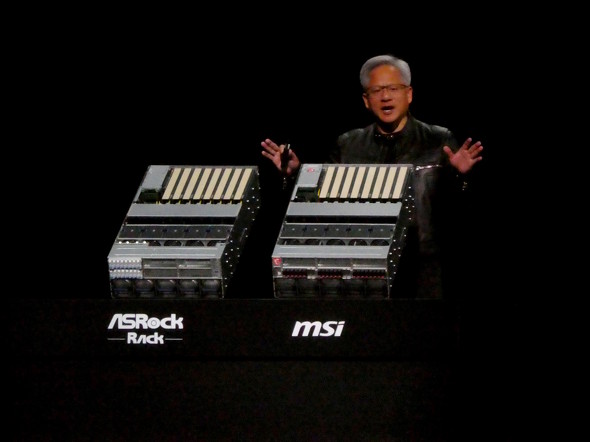

x86アーキテクチャのCPUを搭載することでサーバ/データセンター用ソフトウェアとの互換性を確保しつつ、内部に「NVIDIA RTX PRO 6000 Blackwell Server Edition」を8基搭載することでピーク時に30PFLOPSのAI演算パフォーマンスを確保している。グラフィックスパフォーマンスも最大3PFLOPSを確保しており「リアルタイムのオムニバースデジタルツインシミュレーションも可能」だとする。RTX Proサーバシリーズは主要なサーバメーカーから登場する予定だ。

なお、ワークステーション向けには「NVIDIA RTX PRO 6000 Blackwell」を始めとするBlackwellアーキテクチャベースのNVIDIA RTX PROシリーズを投入しており、こちらも主要なPCメーカーから搭載製品が登場する他、主要な販売パートナーから単体グラフィックスカードも発売される。

RTX PROサーバシリーズはASRock RackやMSIからリリースされている。今後、Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo、Supermicroからも順次発売される予定だ

RTX PROサーバシリーズはASRock RackやMSIからリリースされている。今後、Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo、Supermicroからも順次発売される予定だコンシューマー向けの発表はほとんどなかった今回の基調講演だが、会場周辺や内部の“熱気”は非常にすごかった。「台湾では(TV番組やWebメディアで)フアンCEOを取り上げると、ものすごく話題となる」という関係者の話は本当のようだ。

台湾にとって、フアンCEOはヒーローなのかもしれない。

関連記事

NVIDIAのAI特化型ミニPC「DGX Spark」、台湾の主要PCメーカーからも7月に発売

NVIDIAのAI特化型ミニPC「DGX Spark」、台湾の主要PCメーカーからも7月に発売

準備が進む「COMPUTEX TAIPEI 2025」は5月20日からスタート! 一般公開日は最終日の23日

準備が進む「COMPUTEX TAIPEI 2025」は5月20日からスタート! 一般公開日は最終日の23日

台湾の台北市で、PCやAI関連の見本市「COMPUTEX TAIPEI 2025」が5月20日からスタートする。2025年の話題や見どころはどうなのだろうか。 LenovoのヤンCEOが語る「AI戦略」 Intel/AMD/NVIDIAのCEOも勢ぞろい

LenovoのヤンCEOが語る「AI戦略」 Intel/AMD/NVIDIAのCEOも勢ぞろい

Lenovoの年次イベント「Lenovo Tech World 2024」では、同社のAI戦略が語られた。自社のポートフォリオの広さを生かして、ハイブリッドAIを広範囲に展開していく構えだ。 ASUS、NVIDIA HGX H200を搭載するAIサーバ「ESC N8-E11」を発表

ASUS、NVIDIA HGX H200を搭載するAIサーバ「ESC N8-E11」を発表

ASUSは、NVIDIA HGX H200の搭載に対応した高性能設計のAIサーバ「ESC N8-E11」を発表した。 NPUではなくeGPU側で「Windows Copilot Runtime」を処理 NVIDIAが定義する“RTX AI PC” 2024年後半にプレビュー版が登場

NPUではなくeGPU側で「Windows Copilot Runtime」を処理 NVIDIAが定義する“RTX AI PC” 2024年後半にプレビュー版が登場

“AI PC”のSoCに搭載されたNPUで本来行われる想定の処理をdGPU側で処理できるようになる新たな仕組みが米Microsoftと協力して開発されている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- エンスージアスト向けCPU「Core Ultra 200S Plus」登場 Eコア増量+メモリアクセス高速化+バイナリ最適化でパフォーマンス向上 (2026年03月11日)