AMDの「Instinct MI350シリーズ」は競合NVIDIAよりもワッパに優れるAIドリブンなGPU 今後の展開にも注目(4/4 ページ)

CDNA系アーキテクチャの未来とロードマップ

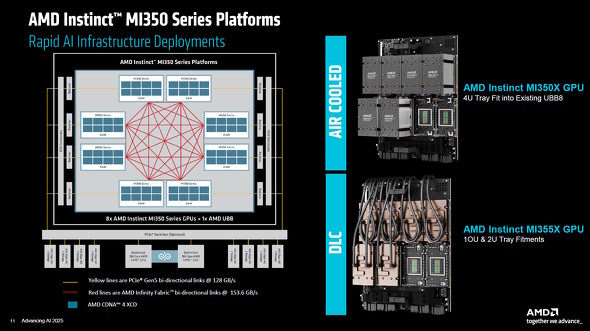

下図は、Instinct MI350シリーズを搭載したノードのシステムダイヤグラムだ。

Instinct MI350シリーズは「OAM(OCP Accelerator Module)」規格のモジュール(カード)として提供される。上図でOAM内にある8つのマスは、1個あたりのXCDをイメージしている。

OAM同士はInfinty Fabricでフルメッシュ相互接続されており、各OAMはPCI Express 5.0バスを介してAMDのCPU「EPYC 9000シリーズ」と接続される。

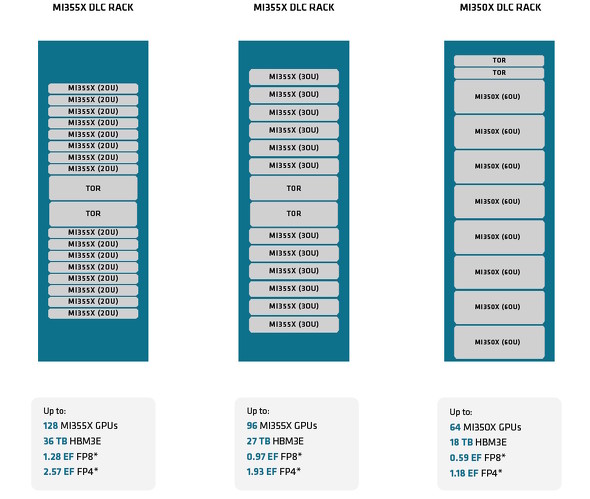

次の図は、Instinct MI350シリーズをラックサーバシステムとして構成した場合の例だ。Instinct MI350Xは、120kWまたは130kWの54Uラックなら最大8台、200kWラックなら最大16台搭載できる。

AMDはInstinct MI350シリーズを2025年第3四半期(7〜9月)から出荷する予定だという。その絶対性能の高さはもちろんだが、NVIDIAのBlackwellアーキテクチャGPU(NVIDIA B200)と比べて価格対性能(コストパフォーマンス)において最大40%も優れていることをアピールしていた。

このポイントは、AI向けGPUサーバの新規導入を検討している層から魅力的に映るのは間違いない。

AI自体の進化ペースが異様に早いこともあり、AI処理に使われるGPUでは“継続的な”新製品の投入が望まれる状況にある。競合のNVIDIAも、近年は数世代先まで新モデルの予告を行うようになった。

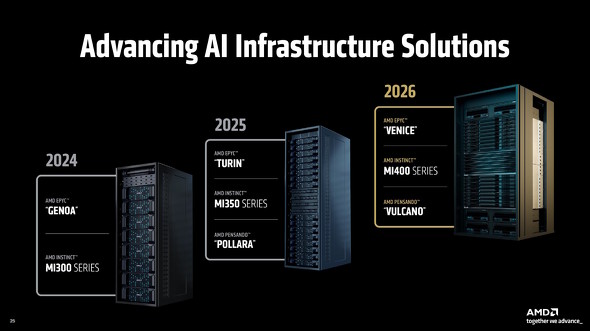

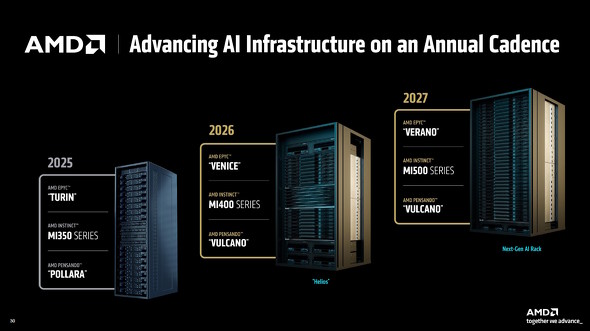

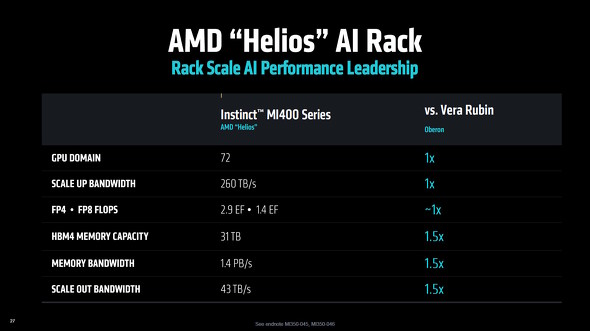

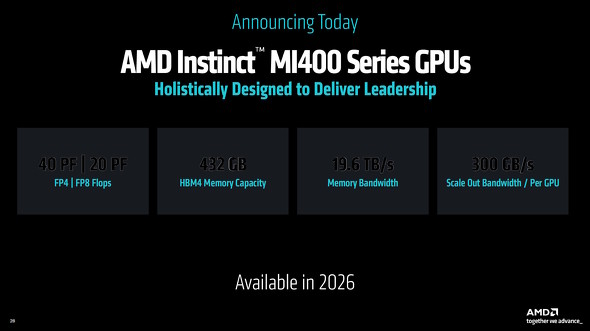

もちろん、AMDも今回のイベントにおいて今後のInstinct MIシリーズのロードマップを予告した。具体的には、2026年には「Instinct MI400シリーズ」、翌2027年には「Instinct MI500シリーズ」が登場予定だという。アーキテクチャ名ではなく製品名を出してくるあたり、その開発が順調であるというアピールだ。

特に2026年に登場する予定のInstinct MI400シリーズは具体的な目標性能値の引き上げを実施しており、NVIDIAの次世代GPU「Rubin」と同等以上の理論性能を有し、1モジュール当たりのグラフィックスメモリ容量は432GB(MI350シリーズの1.5倍)、メモリ帯域は毎秒19.6TB(MI350シリーズの約2.5倍)になるという。

筆者が個人的に注目したのは、Instinct MI400シリーズのラックシステムのサイズだ。従来の2倍広くなっており、昨今の「高密度コンパクト化」の流れからは逆行しているように思える。

あえて“拡張”する方向の設計としているのは、製造プロセスの微細化がかつてないほどに鈍化している現状にあってもなお、より高い性能を求め続けるAIサーバ市場を考えるとそうせざるを得ないのだろう。言い換えると今後、性能向上を重視したコンピュータシステムを構築するには、「フットプリント」よりも「高帯域/大容量」を優先した設計にならざるをえないのだ。

以前は「CPUサーバと比較して、GPUサーバーは○倍も高性能で、こんなに省スペースで省電力!」なんていう売り文句もよく見かけたが、このキラーメッセージの後半部分は徐々に影を潜めつつある。果たして、今後はどのような売り文句になっていくのだろうか……?

AMDが掲げるInstinct MI400シリーズの目標性能をイメージにしたもの。昨今のAMDのエンジニアリングパワーを鑑みれば、この目標は達成できると思われるが消費電力(+発熱)と物理体積はどの程度になるのか――ここにも注目していきたい

AMDが掲げるInstinct MI400シリーズの目標性能をイメージにしたもの。昨今のAMDのエンジニアリングパワーを鑑みれば、この目標は達成できると思われるが消費電力(+発熱)と物理体積はどの程度になるのか――ここにも注目していきたい関連記事

AMDのデータセンター向けGPU「Instinct MI350シリーズ」って? 歴史と構造、シリコンなどをチェック!

AMDのデータセンター向けGPU「Instinct MI350シリーズ」って? 歴史と構造、シリコンなどをチェック!

AMDが新型のデータセンター向けGPU「Instinct MI350シリーズ」を発表した。どのようなGPUなのか、そのあらましを見てみよう。【訂正】 AMDが「Instinct MI350シリーズ」を2025年第3四半期に出荷開始 275台以上のラックシステムを2030年までに“1台”にまとめる計画も

AMDが「Instinct MI350シリーズ」を2025年第3四半期に出荷開始 275台以上のラックシステムを2030年までに“1台”にまとめる計画も

AMDが、新しいGPUアクセラレーター「Instinct MI350シリーズ」の出荷を2025年第3四半期に開始する。今後のGPUアクセラレーターに関するロードマップもチラ見せされた。 AMDのGPUアクセラレーター「Instinct」のロードマップを公表 「Insinct MI350X」は2025年内に登場

AMDのGPUアクセラレーター「Instinct」のロードマップを公表 「Insinct MI350X」は2025年内に登場

AMDが、AI処理やハイパフォーマンスコンピューティング向けに発売しているGPU「AMD Instinct」のロードマップを発表した。2024年後半には現行アーキテクチャにおける改良版をリリースし、2025年には新アーキテクチャ、2026年にはさらなる新アーキテクチャの製品を投入する予定だという。 AMDが新型GPUアクセラレータ「Instinct MI300シリーズ」の詳細を発表 「NVIDIA H100」よりも強い?

AMDが新型GPUアクセラレータ「Instinct MI300シリーズ」の詳細を発表 「NVIDIA H100」よりも強い?

AMDが、投入を予告していたGPUアクセラレータ「Instinct MI300シリーズ」の詳細情報を公表した。「NVIDIA H100」のSMX5ボード版と比べると、ほぼ同じか上回るパフォーマンスを発揮できるという。 AMD、HPC向けのGPUアクセラレーター「AMD Instinct MI200」シリーズを発表 業界初のマルチダイGPU構成を採用

AMD、HPC向けのGPUアクセラレーター「AMD Instinct MI200」シリーズを発表 業界初のマルチダイGPU構成を採用

米AMDは、このほど開催したオンラインイベント「AMD Accelerated Data Center Premiere」にて最新GPUアクセラレーターとなる「AMD Instinct MI200」シリーズの発表を行った。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 珍しい縦折り&日本語配列の「Ewin 折りたたみ式ワイヤレスキーボード」がセールで25%オフの3980円に (2026年02月13日)

- メモリの価格上昇が一段落、枯渇していた「RTX 5090」も再入荷 止まらぬパーツ高騰の合間に訪れた一時の平穏 (2026年02月14日)

- カラー電子ペーパーで好きな画像を飾れる「SwitchBot AIアートキャンバス」が楽しい 13.3型の迫力と魅力 (2026年02月13日)

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 手のひらサイズの小型PCがお得に! GEEKOMが「冬セール」を開催中 (2026年02月12日)

- PC値上げの波はVAIOにも? 糸岡社長が明かす「マウスエフェクト」への対応とブランド価値の向上 (2026年02月13日)

- デスクトップの音響環境を改善する「Edifier M60」が21%オフの1万8979円に (2026年02月13日)

- アイ・オー、拡張ドック機能を備えたType-C接続対応の27型4K液晶ディスプレイ (2026年02月12日)

- ワコムが安い? 驚きの2025年を振り返り メモリ高騰におびえる2026年の「自作PC冬眠」と「次世代CPU」への期待 (2026年02月12日)

- 「雲」から降りてきたAIは「パーソナル」な存在になれるのか――開催から1カ月経過した「CES 2026」を振り返る (2026年02月12日)