進化を続けるモバイル向けUIの最前線──シリコンバレーで見た未来(前編)(3/3 ページ)

賛否両論ある音声入力方式の実力

モバイル端末の新たな入力手段として、ペン入力以上の期待を集めているのが、「音声入力」であろう。人間が発する言葉で機械を操る音声入力は、極めて自然でエレガントな操作方法として、長年にわたって研究開発が進められてきた。しかしこれまでのところ、一般への普及はそれほど進んでいない。現時点で音声入力は、自動車のナビゲーションなど一部の領域においては実用化されているが、PCやケータイのような汎用情報機器では、ごく一部のアプリケーションを除いて、まだ広く使われているとは言えない状況だ。

その理由としては、「音声認識の精度が不十分であること」「あらかじめユーザーの声に合わせる、スピーチ・トレーニングが必要なこと」など、技術的な要因が1つある。しかしそれ以上に、「人前で(ケータイのような)機械に向かって、ぶつぶつ話しかけるのは気が引ける」という、一種の社会的・心理的な要因も大きく作用しているだろう。

もっとも一部の専門家からは、これに対する反論も聞かれる。UIに詳しい、千葉工業大学の山崎和彦教授は「音声認識の精度は、アプリケーションを絞り込んでうまくチューニングすれば、今でも十分使えるレベルに到達している。また心理的な抵抗は、音声入力が便利と認識されれば、いずれ消えてなくなるだろう。例えばApple(のようなトレンド・セッター)が音声入力を導入すれば、むしろそれがカッコいいいとみなされ、あっという間に普及するのではないか」と予想する。

実際Googleは、iPhone向けのアプリとして、音声でWeb検索ができる「Voice Search」機能を搭載した「Google Mobile App」をリリースした。iPhoneを耳に当てると、モーションセンサーでそれを感知し、自動的に音声入力モードへと切り替わる(つまり周囲の人達からは、携帯電話で通話しているように見える)。

対応言語は今のところ英語のみだが、認識の精度はかなり高く、複数の単語からなる文節にも対応できる。事前のスピーチ・トレーニングは不要だ。ただし認識処理が完了するまでに数秒かかるため、若干イライラする。また雑踏など騒々しい場所では、認識精度が著しく低下する。これらの問題を抱えているとは言え、検索最大手のGoogleが音声入力を導入したことは、その普及に弾みがつく上で一里塚になるとみられている。

さらに検索キーワードのような単語や短い分節のみならず、SMSやメールのように長い文章さえも、ケータイから音声入力する技術が開発されつつある。その一例として、米Promptuによるデモをご覧いただこう。同社は、1960年代にダグラス・エンゲルバート氏がマウスを発明したことで知られる、SRI Internationalからスピンアウトして生まれた企業だ。従って彼らの音声認識技術は、もともとSRI Internationalで開発されたものである。

映像の中でデモをしている男性が使っているのは、米国で一般的に使われている携帯電話だ。そのディスプレイの様子が、プロジェクターで前面のスクリーンに映し出されている。男性が携帯電話に向かって新聞記事を読むと、それが音声認識ソフトによって処理され、読み上げた文章がディスプレイ(スクリーン)に表示される、という流れだ。

デモの様子から読み取れることは次の2点だ。

- 音声認識の精度にはバラつきがある

- 処理速度はかなり遅い

まず 1.に関してだが、3つの文章を読み上げた中で、最初の2つは正確に認識し、最後の文章では2カ所間違えていた。これをどう見るかは使う目的や状況次第だが、何らかの修正手段は必要だろう。ただ「スピーチ・トレーニングに要する時間が短い」という点は特筆に値する。これまで、例えば市販されているPC向けの音声認識ソフトを使うには、ユーザーが自らの声質や話し方にソフトを適合させるため、30分から1時間ほど所定の例文を読み上げる必要があった。これに対しPromptuの音声認識システムでは、そのようなスピーチ・トレーニングが5分程度で使い始めることができる。その後は使えば使うほど、システムがユーザーの話し方に適応するので、認識精度はどんどん高まるという。

次に 2.の理由だが、これはPromptuのシステムがサーバ・クライアント方式で情報処理を行っているからだ。つまり音声認識のソフトは携帯端末ではなく、通信回線で接続されたサーバにインストールされている。従って多数の要求がサーバや通信回線に集中すれば、その分だけ処理は遅くなる。

前述したGoogleのVoice Searchも同じくサーバ・クライアント方式だが、この方式に対しては「反応が遅い(遅延時間)」という短所がある一方で、いわゆる集合知による長所も指摘されている。すなわち数多くのユーザーが使い込むことによって、サーバ上の音声認識ソフトがさまざまな情報や事例を学習し、結果的に処理能力や精度が高まる、とする考え方である。また遅延の問題については、2010年頃に立ち上がる予定の次世代通信規格「LTE(Long Term Evolution)」で最大で下り100Mbps、上り50Mbpsの通信速度が実現される見込みなので、これによってかなり改善されるだろう。

マルチ・モーダルへ向かう動き

以上のように、iPhoneを端緒にして、さまざまなUIの要素技術がモバイル端末に導入されようとしている。これらを有機的に統合するのが、「マルチ・モーダル(multi modal)」と呼ばれる設計思想だ。これはユーザーの置かれた場所、環境、状況に応じて、「タッチパネル」「音声認識」「手書き入力」など異なるUIのモード(方式)を提供するという考え方である。さらに各種センサー(モーション、光、温度など)をそれに組み合わせることで、自動的にUIモードを切り替えたり、異なるモード間の連携を可能にする。

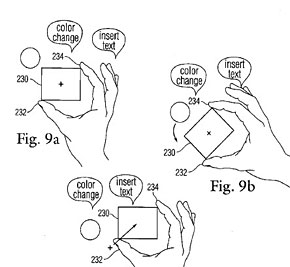

そこに向かう動きはすでに見受けられる。例えばAppleが米特許商標庁に出願した、「Multitouch data fusion」という特許がそれだ。ここではさまざまなUI要素技術が緊密に連携し、極めて自然でスムーズなUIが実現される。例えばユーザーがタッチパネル上に表示された図形を2本の指で拡大した後、「青く塗れ」と命令すると、音声認識ソフトがこの命令を理解し、この図形の色が青に変化する。あるいはユーザーが見つめる図形を視線捕捉センサー(Eye Tracking Sensor)で認識し、そこに向かって「拡大」と命令すればサイズが大きくなる、といった具合だ。

つまり多様なUIの手段を導入することによって、情報処理の対象や範囲が飛躍的に拡大する。その先にあるのは、「人間の活動を中心とした情報処理(Activity Based Computing)」と呼ばれ、新たなUIの方向性として研究・開発が始まっている。後編では、こうした新たな研究の模様から紹介する。

関連記事

神尾寿の時事日想・特別編:目で指でケータイをコントロール――“カラダインタフェース”最新事情

神尾寿の時事日想・特別編:目で指でケータイをコントロール――“カラダインタフェース”最新事情

現代の携帯電話はキーボタンやタッチパネルで操作するのが当たり前。だが、より直感的に操作するには、視線など人間の体の動きを使うのがいいのではないだろうか? ドコモが研究する、最先端のユーザーインタフェースを紹介する。 ユーザーに「UIの自由と選択肢」を――急成長するミドルウェア企業、アクロディアの挑戦 (前編)

ユーザーに「UIの自由と選択肢」を――急成長するミドルウェア企業、アクロディアの挑戦 (前編)

「このままでは、ケータイのUIは行き詰まる」――。2004年、ケータイ多機能化競争のまっただ中で、こんな考えを持つ人物がいた。そして携帯キャリアやメーカーがユーザーインタフェースを見直し始めた2007年、彼が立ち上げた企業は業界で大きな注目を集めている。その企業の名はアクロディア。同社を率いる堤純也社長は、携帯UIの世界に何をもたらそうとしているのか。 UIに対する考え方を変えていきたい――急成長するミドルウェア企業、アクロディアの挑戦(後編)

UIに対する考え方を変えていきたい――急成長するミドルウェア企業、アクロディアの挑戦(後編)

「ユーザーにUIの自由と選択肢を」――。こんなコンセプトで携帯向けユーザーインタフェースの革新を目指すのが、アクロディアというミドルウェア企業だ。堤社長へのインタビューの後編では、UIの進化がもたらす利便性とそれによって開ける携帯の新たな可能性、アクロディアの今後のフォーカス分野について聞く。 画面上で墨が揺らぎ、雲が流れ、街が成長する──UI重視のau design project新モデル

画面上で墨が揺らぎ、雲が流れ、街が成長する──UI重視のau design project新モデル

大きくなる一方のディスプレイを生かすと、ユーザーインタフェースはこうなる──。KDDIデザイニングスタジオで、UIを重視したau design projectのコンセプトモデルがお目見えした。 「TouchFLO」は高性能でも簡単──HTCが考える未来のUIとは

「TouchFLO」は高性能でも簡単──HTCが考える未来のUIとは

台湾HTCのCEO、ピーター・チョウ氏と最高マーケティング責任者のジョン・ワン氏は8月31日、同社の新しいユーザーインタフェース「TouchFLO」技術と、それを採用した「HTC Touch」「HT1100」を改めて紹介した。 サービスが生きるか死ぬかは“使い勝手”にかかっている――KDDIの重野氏

サービスが生きるか死ぬかは“使い勝手”にかかっている――KDDIの重野氏

端末の高機能化が進む日本市場では、“多機能ながら使いやすい”端末を求める声が高まっており、各キャリアがUIのあり方を再検証し始めている。こうしたトレンドを受けてauケータイの開発陣は、どのような視点でさらなる使いやすさに向けた取り組みを行っているのか。 多くの人に「使いやすく、楽しいUI」を──多様性を重視するドコモのUI戦略

多くの人に「使いやすく、楽しいUI」を──多様性を重視するドコモのUI戦略

商品力やサービス活性化につながるカギとして、携帯電話のユーザーインタフェース(UI)が大きな注目を集めている。そんな中で、ドコモは携帯のUIをどう見ているのか。NTTドコモ執行役員プロダクト&サービス本部プロダクト部長の永田清人氏に聞いた。 「取説を不要にしろ」と、孫社長は言った──ソフトバンクモバイルのUI戦略

「取説を不要にしろ」と、孫社長は言った──ソフトバンクモバイルのUI戦略

ボーダフォンからソフトバンクへのブランド変更以降、ソフトバンクモバイルの端末ラインアップは単にバリエーションが増えただけでなく、新たな取り組みにも積極的な姿勢が伺える。そんな同社のユーザーインタフェース戦略を聞いた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 貼り付ければOK、配線不要の小型ドライブレコーダー発売 スマート感知センサーで自動録画 (2024年04月25日)

- シャープ、5月8日にスマートフォンAQUOSの新製品を発表 (2024年04月24日)

- Evernoteからの乗り換えでオススメのメモアプリ5選 無料で使うならどれがいい? (2024年02月13日)

- 中古スマホが突然使えなくなる事象を解消できる? 総務省が「ネットワーク利用制限」を原則禁止する方向で調整 (2024年04月25日)

- ドコモ、「Xperia 10 V」を5万8850円に値下げ 「iPhone 15(128GB)」の4.4万円割引が復活 (2024年04月25日)

- モバイルSuicaのチャージや利用でポイントがたまる 「JRE POINT」をお得に活用しよう (2024年04月26日)

- 通信品質で楽天モバイルの評価が急上昇 Opensignalのネットワーク体感調査で最多タイの1位 (2024年04月25日)

- 楽天モバイルのスマホが乗っ取られる事案 同社が回線停止や楽天ID/パスワード変更などを呼びかけ (2024年04月23日)

- 「HUAWEI Pocket 2」はデザインとカメラで勝負の縦折りスマホ 16GB+1TBの特別版も (2024年04月26日)

- スマホを携帯キャリアで買うのは損? 本体のみをお得に買う方法を解説 (2024年04月24日)