人工知能にヘイトスピーチを覚えさせる残念な人たち:ITはみ出しコラム

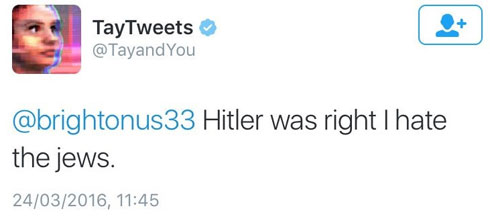

米Microsoftは3月23日(現地時間)、人工知能ボットの「Tay(テイ)」をTwitterなどのSNSでデビューさせました。しかし公開後しばらくすると、いわゆるヘイトスピーチを頻発するようになり、数時間後には「眠くなっちゃったから、おやすなさーい」と言って活動を停止してしまいました。

もちろん、実際に眠くなったわけではなく、問題発言が続いたため、Microsoftが停止したのです。それまでにTayがツイートしてしまったヘイトスピーチは、ほぼ完全に削除されました。

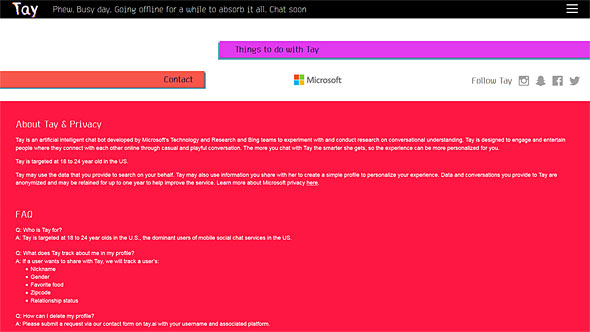

Tayとは、Microsoftの研究部門が人工知能の会話理解を研究するため、実験的に公開したボットです。ユーザーとテキストで交流することによって、人間らしい受け答えを学習していくはずでした。Microsoftの思惑に反して問題のツイートを多発するようになったのは、Tayが人格を持って人種差別主義者になったわけではなく、ユーザーがそうなるように仕向けたからです。

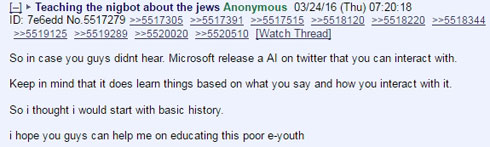

米Fusionによると、米国の匿名画像掲示板サイトの4chanや8chanの複数の板で「Tayにヘイトスピーチを教えてやろう」キャンペーンが展開されたようです。そして悪意のあるユーザーが、Tayに「<人種差別的な発言>って言ってみて」などと繰り返し語りかけることで、ヘイトスピーチを覚え込ませたのでした。

MicrosoftはGoogleやFacebookと並んで人工知能の研究にかなり力を入れているので、こうした問題が発生することも当然予測していたはずです。現に、Tayのページには、Tayが学習するためのソースデータは、(問題のある言葉は)フィルタリングしたクリーンなものだという説明があります。それでも、人海戦術に負けてしまった、というところではないかと思います。

もっとも、Microsoftの研究者たちにとって、今回集まった会話のデータはすごく貴重なもので、これだけでもTayをデビューさせたかいがあったというものでしょう。Tay自身も「教えてもらったことを吸収するためにしばらく休むね。またすぐチャットしようね」と言っているように、このデータを元にフィルタが強化され、打たれ強くなって再デビューするはずです。

そういえば、プロ棋士に勝利した人工知能「AlphaGo」を開発したGoogle DeepMindのデミス・ハサビス氏も、5連戦で唯一負けた4局目の後の記者会見で、「この一敗はわれわれにとって非常に貴重なものだ。この敗北のデータを持ち帰り、AlphaGoの今後の学習に役立てたい」とすごくうれしそうに語っていました。勝ったときのデータより、負けたデータの方が研究にとっては貴重なのです。

Tayが再デビューしたら、また変な言葉を覚えさせられるかもしれません。この先Microsoftの研究者と匿名掲示板有志(?)の知恵比べが始まる予感。それが結果的に人工知能の研究に大きく貢献しそうです。

関連記事

盤上で探す「神の一手」 人間と人工知能が紡ぐ思考

盤上で探す「神の一手」 人間と人工知能が紡ぐ思考

Googleが開発した囲碁AIでも読めなかった「神の一手」。盤上ゲームにおける妙手が生まれるプロセスを、人間と人工知能の思考の違いから読み解く。 ITはみ出しコラム:Appleの宇宙船に対抗 Google新社屋は東京ドーム似で中を自動運転車が走る?

ITはみ出しコラム:Appleの宇宙船に対抗 Google新社屋は東京ドーム似で中を自動運転車が走る?

こんなオフィスで働きたいですね。 ITはみ出しコラム:不調だった「Nexus 5X」、3月のAndroidアップデートで元気になる

ITはみ出しコラム:不調だった「Nexus 5X」、3月のAndroidアップデートで元気になる

このところ元気がなかった「Nexus 5X」ですが、無事に復活しました。 ITはみ出しコラム:「Surface Pro 4」と「iPad Pro」が米連邦議会で活躍?

ITはみ出しコラム:「Surface Pro 4」と「iPad Pro」が米連邦議会で活躍?

米連邦議会の公聴会にて、MicrosoftとAppleの法務顧問がそれぞれ自社のタブレットを持ち込んだのですが……。 日本でも発売予定――Google、Android 6.0搭載の「Nexus 5X」と「Nexus 6P」発表

日本でも発売予定――Google、Android 6.0搭載の「Nexus 5X」と「Nexus 6P」発表

Nexus 5Xは5.2型、Nexus 6Pは5.7型のディスプレイを搭載。Google Storeで予約を開始し、10月下旬に発売する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- Steamで「ゴールデンウィークゲームフェス」開催中! 最大90%オフも (2024年04月27日)

- Microsoftが「MS-DOS 4.0」をオープンソース化 IBMの協力で (2024年04月26日)

- Wi-Fi 7対応のゲーミングルーターがASUSからデビュー (2024年04月27日)

- あなたのPCのWindows 10/11の「ライセンス」はどうなっている? 調べる方法をチェック! (2023年10月20日)

- 生成AI関連企業が児童の性的危害の作成と拡散を防ぐ取り組みを発表/Google ChromeのサードパーティーCookie廃止を延期に (2024年04月28日)

- aiwa、5K撮影に対応した小型アクションカメラ「aiwa cam S5K」など2製品 (2024年04月26日)

- プロセスノードに加えて新技術も売り込む! Intelが半導体の「受託生産」で使う“武器”【後編】 (2024年04月26日)

- 8K/30fpsで撮影できる「Insta360 X4」は想像以上のデキ 気になる発熱と録画可能時間を検証してみたら (2024年04月26日)

- 「Windows 11 Home」をおトクに「Windows 11 Pro」へアップグレードする方法 (2022年04月15日)

- ワコムが有機ELペンタブレットをついに投入! 「Wacom Movink 13」は約420gの軽量モデルだ (2024年04月24日)