Google、モバイル検索結果画像の3D→AR化機能や「Google Lens」の新機能を発表:Google I/O 2019

米Googleは5月7日(現地時間)、年次開発者会議「Google I/O 2019」で、モバイルGoogle検索や「Google Lens」の新機能を発表した。

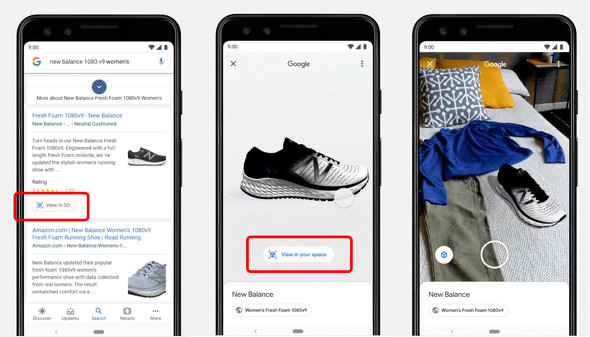

Google検索結果の画像を3Dに、さらにARにする機能

モバイル版のGoogle検索で、例えば「人間の筋肉」「白ザメ」「ニューバランスのスニーカー」などと検索すると、結果の画像が対応している場合は検索結果に「3Dで表示する」ボタンが表示され、これをタップすると3D画像で確認できるようになる。この3D画像は360度回転させることも可能。さらに、「自分の空間で表示する」ボタンをタップすれば、その3D画像を端末のカメラで取り込むリアルな背景の中に置ける。

白ザメもスニーカーも原寸大なので、ARで表示するとサイズを実感できる。

3DおよびARデータは、Googleと提携するNASA、New Balance、Samsung、Target、Visible Body、Volvo、Wayfairなどが提供している。

この機能は今月中にローリングアウトする見込み。Android以外でも使えるようになるのか、日本でも使えるのかはまだ不明だ。

「Google Lens」にメニューのお勧め料理ハイライトや翻訳読み上げ機能

Googleが2017年のGoogle I/Oで発表したスマートフォンのカメラに写った映像を解析するサービス「Google Lens」が進化し、機械学習による視覚的な検索結果の表示が増えた。

基調講演のデモでは、レストランのメニューを映してGoogle Lensボタンをタップすると、メニュー上の料理の中からお勧めのものをハイライトし、そこから任意の料理をタップするとその料理の写真とレビューが表示された。

バックグラウンドでは、Google Lensがメニューから料理名をピックアップするために文字の書体やサイズを解析し、レビューと写真はユーザーの位置情報からレストランを特定してGoogleマップ上に表示される料理の写真とレビューを利用するという作業が行われている。

Google Lensによる翻訳機能の対応言語が拡大し、日本語を含む100カ国語以上のテキストを読み取り、翻訳できるようになった。下の画像は、日本の新幹線の乗車券をカメラで写して英語に翻訳したものだ。

Googleはさらに、美術館の展示物にカメラを合わせるとキュレーターが用意した解説を表示する機能や、料理雑誌のレシピで動画による手順解説を表示する機能などを紹介した。

関連記事

Google I/O 2019まとめ 「AI for Everyone」、Pixel 3aも発表

Google I/O 2019まとめ 「AI for Everyone」、Pixel 3aも発表

Googleの年次開発者会議「Google I/O 2019」で発表されたことを時系列にまとめた。今年のテーマは「「Building a more helpful Google for everyone」。AI採用のアクセシビリティ機能や「Googleアシスタント」の新機能、手ごろな価格の「Pixel 3a」などが発表された。 「Android Q」のBeta 1公開 Pixelシリーズにインストール可能

「Android Q」のBeta 1公開 Pixelシリーズにインストール可能

Googleが次期モバイルOSを「Android Q」とし、最初のBeta版を公開した。初代からのすべてのPixel端末にインストールできる。位置情報などのプライバシーの強化や折りたたみ端末のサポートなど多数の新機能が盛り込まれる。 「AI for everyone」を掲げるGoogle 新GoogleアシスタントやAndroid Pで何が変わる?

「AI for everyone」を掲げるGoogle 新GoogleアシスタントやAndroid Pで何が変わる?

Googleの開発者イベント「Google I/O 2018」では、AIを用いたさまざまな新機能が紹介された。Googleアシスタントや新OS「Android P」でもAIが活用されている。私たちの生活はどう変わるのだろうか。 「Google Lens」登場 スマホカメラに写ったものを理解して追加情報やアクションを提示

「Google Lens」登場 スマホカメラに写ったものを理解して追加情報やアクションを提示

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- Qualcommのウェアラブル新チップが「Elite」を冠する理由 最新モデム「X105」は衛星通信100Mbpsへ (2026年03月11日)

- 【無印良品】ウエストポーチもになる「スリングバッグ」が3990円に値下げ中 植物由来の原料を使用 (2026年03月11日)