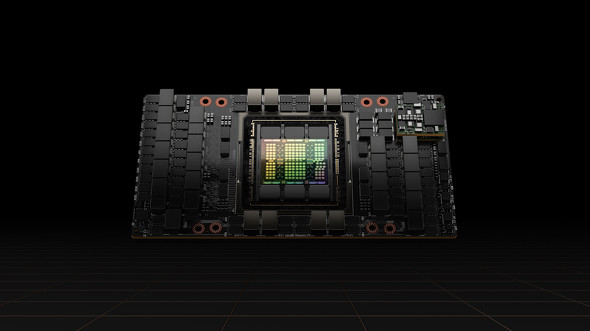

NVIDIAがデータセンター向けGPU「NVIDIA H100」を発表 新アーキテクチャ「Hopper」を採用:2022年第3四半期に提供開始

NVIDIAは3月22日(米国太平洋時間)、データセンター向けの新型GPU「NVIDIA H100」を発表した。同GPUを搭載する同社製の深層学習システム「NVIDIA DGX H100」や各社のサーバは2022年第3四半期(7〜9月)に発売される予定だ。

新GPUアーキテクチャ「Hopper」

NVIDIA H100では、新しいGPUアーキテクチャ「Hopper(ホッパー)」を採用している。この名前はコンピューター科学者の故グレース・ホッパー氏にちなんでおり、現行のAmpere(アンペア)アーキテクチャの後継に位置付けられている。

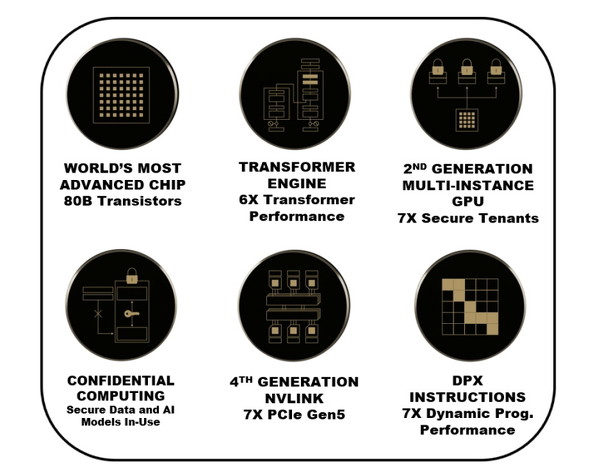

Hopperアーキテクチャの主な特徴は以下の通りだ。なお「旧世代」は「NVIDIA A100」のことを指す。

- TSMCの4nmプロセスで製造

- 800億個のトランジスタを搭載

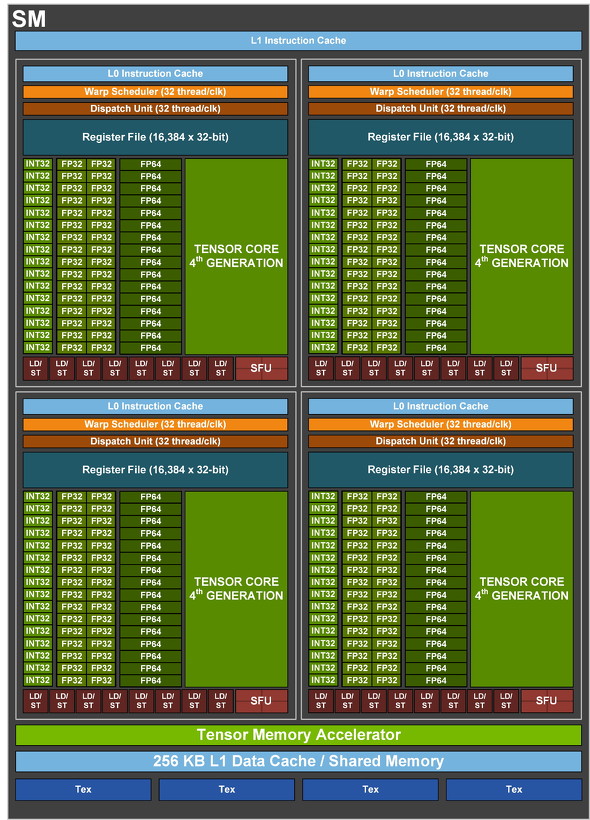

- Tensorコア(機械学習処理用コア)は第4世代に

- 旧世代比で最大6倍の演算能力を発揮

- PCI Express 5.0接続に対応

- NVLinkも第4世代に移行(詳しくは後述)

- 新しい「Transformer Engine」を搭載

- 新しいTensorコアとソフトウェアの組み合わせで、自然言語モデルの学習を高速化

- 演算内容に応じて浮動小数点演算の精度を8bit(FP8)と16bit(FP16)との間で動的に切り替え

- 旧世代比で最大6倍のパフォーマンス改善

- MIG(マルチインスタンスGPU)は第2世代に

- 最大7基の仮想GPUを構築可能(旧世代と同様)

- 旧世代比で仮想GPU1基当たりのパフォーマンスは最大3倍、メモリ帯域は最大2倍に

- ハードウェアとハイパーバイザーを使ったセキュリティを確保

- HBM3(第3世代広帯域メモリ)に対応

- メモリ帯域幅は最大毎秒3TB(旧世代比で1.5倍)

フォームファクターによって微妙に性能差あり

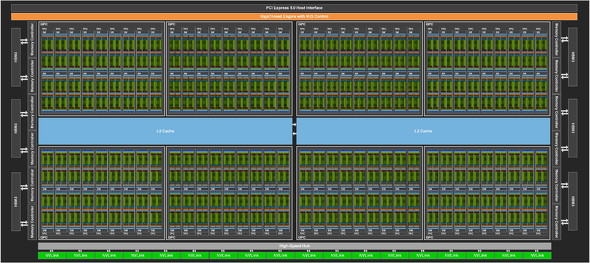

NVIDIA N100には、同社オリジナルの「SMX5ボード」と、PCベースのサーバなどで汎用(はんよう)的に使える「PCI Expressボード」の2種類のフォームファクターが用意される。搭載するGPUチップはいずれも「NVIDIA GH100」というものだが、微妙にスペックが異なる部分がある。

- GH100(オリジナル)の主なスペック

- SM(ストリーミングマルチプロセッサ):最大144基

- Tensorコア:SM1基当たり4基(最大582基)

- CUDAコア(並列計算用コア):SM1基当たり128基(最大1万8432基)

- グラフィックスメモリ:HBM2eまたはHBM3規格(最大6スタック)

- メモリコントローラー:512bit/最大12基

- L2キャッシュ:最大60MB

- SMX5ボードに搭載されるGH100の主なスペック

- SM:132基

- Tensorコア:528基

- CUDAコア:1万6896基

- グラフィックスメモリ:80GB(HBM3規格、5スタック)

- メモリコントローラー:512bit/10基(帯域幅は最大毎秒3TB予定)

- L2キャッシュ:50MB

- NVLinkの通信速度:最大毎秒900GB(片方向では毎秒450GB)

- TDP(熱設計電力):700W

- PCI Express 5.0ボードに搭載されるGH100の主なスペック

- SM:114基

- Tensorコア:456基

- CUDAコア(並列計算用コア):1万6896基

- グラフィックスメモリ:80GB(HBM2e規格5スタック)

- メモリコントローラー:512bit/10基(帯域幅は最大毎秒2TB予定)

- L2キャッシュ:50MB

- NVLinkの通信速度:最大毎秒600GB(片方向では毎秒300GB)

- TDP:350W

なお、用途が用途だけに、上記のうちグラフィックスの外部出力に直接利用できるリソースはごくわずかとなっている(※1)。

(※1)全構成共にTPC(テクスチャ処理クラスタ)のうち2基(SM換算で4基)のみとなる

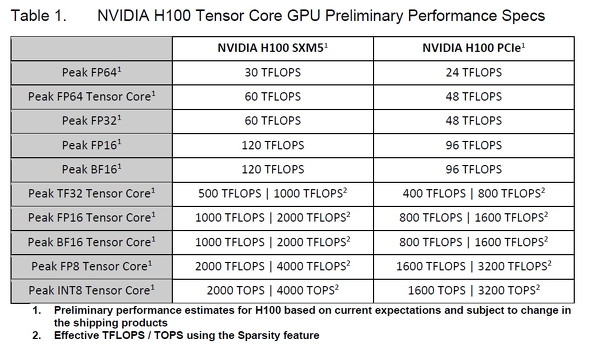

Tensorコアを併用した場合の主な演算スペック(予定値)は以下の通りだ(前段の数字はSMXボード、後段の数字はPCI Expressボード)。

- FP64:60兆FLOPS/48兆FLOPS

- FP16(※2):1000兆FLOPS/800兆FLOPS

- FP8(※2):2000兆FLOPS/1600兆FLOPS

- TF32(※2):500兆FLOPS/400兆FLOPS

- BF16(※2):1000兆FLOPS/800兆FLOPS

(※2)スパース性(疎な行列の整理)を利用した場合、実効演算速度はこの2倍となる

一部の演算では、「1兆=T(テラ)」を超える「1000兆=P(ペタ)」FLOPSを実現している。

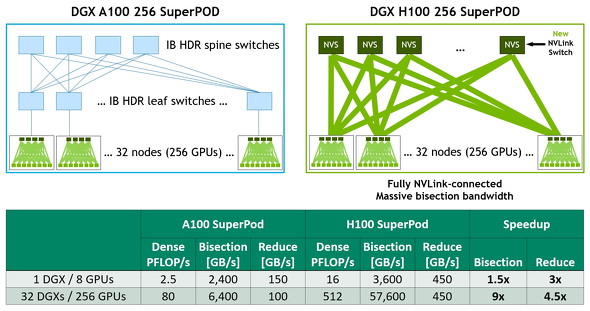

第4世代NVLinkは最大256基の連結に対応

先述の通り、NVIDIA H100は第4世代NVLinkに対応している。この新しいNVLinkでは直結できるGPUが最大8基であることに変わりはないが、帯域幅が最大毎秒900GB(双方向時)に高速化されている。

さらに、新世代では「NVLink Network interconnect」という機能が新たに追加されており、オプションのラックシステム「NVLink Switch」を利用することで最大256基のGPUをNVLinkを介して連携動作できるようになった。旧世代の「NVIDIA HDR Quantum InfiniBand」を使った連携と比べると帯域幅は9倍(双方向時)になるという。

第4世代NVLinkでは、NVLink Switchを別途用意することで最大256基のGPUをNVLinkを介して連携させられるようになった。従来のHDR Quantum InfiniBandを介した連携と比べると、帯域幅は9倍になる

第4世代NVLinkでは、NVLink Switchを別途用意することで最大256基のGPUをNVLinkを介して連携させられるようになった。従来のHDR Quantum InfiniBandを介した連携と比べると、帯域幅は9倍になる自社製の「NVIDIA DGX」もモデルチェンジ

NVIDIA H100の登場に合わせて、NVIDIAは2022年後半に、自社製の深層学習用サーバ「NVIDIA DGX H100」を発売する。主なスペックは以下の通りだ。

- CPU:x86アーキテクチャ×2(詳細は明記なし)

- GPU:NVIDIA H100×8(グラフィックスメモリは合計640GB)

- FP8演算の性能は最大3京2000兆FLOPS

- メインメモリ:2TB

- ストレージ:1.9TB SSD×2(OS用)+3.84TB SSD×8(データ用)

- OS:DGX OS(Ubuntuベース)

- 通常のUbuntu、またはRedHat Enterpriseにも対応(別途追加ソフトウェアが必要)

加えて、同社は複数台のDGX H100をNVLink Switchで連結した「NVIDIA DGX POD」「NVIDIA DGX SuperPOD」も発売する。DGX H100向けNVIDIA DGX SuperPODでは、最大で32台のDGX H100を搭載可能で、この場合は256基のGPUを連係動作させられることになる。32台を連携させた場合、FP8演算の能力は最大約1000京FLOPSとなり、「1000京=E(エクサ)」レベルとなる。

その他、NVIDIA H100を搭載するサーバは以下のメーカーからも登場する予定だ。

- Atos

- BOXX Technologies

- Cisco

- Dell Technologies

- 富士通

- GIGABYTE

- H3C

- Hewlett Packard Enterprise

- Inspur

- Lenovo

- Nettrix

- Supermicro

関連記事

「NVIDIA RTX A5500」などの新GPUが登場 Ampereアーキテクチャを採用しモバイル向けも

「NVIDIA RTX A5500」などの新GPUが登場 Ampereアーキテクチャを採用しモバイル向けも

米NVIDIAは、オンラインイベント「GTC 2022」に合わせて「NVIDIA RTX」シリーズの新しいGPU 7製品を発表した。 NVIDIAが1999ドルの「Jetson AGX Orin開発者キット」を発売

NVIDIAが1999ドルの「Jetson AGX Orin開発者キット」を発売

米NVIDIAは、オンラインイベント「GTC 2022」に合わせて「Jetson AGX Orin開発者キット」の出荷を始めた。 NVIDIA Maxineにエコーキャンセルとオーディオアップサンプリング機能を追加

NVIDIA Maxineにエコーキャンセルとオーディオアップサンプリング機能を追加

米NVIDIAは、オンラインイベント「GTC 2022」に合わせて「NVIDIA Maxine」開発者キットに、エコーキャンルとオーディオアップサンプリングの機能を追加したと発表した。 実売28万円のNVIDIA RTX A4500搭載カードが登場!

実売28万円のNVIDIA RTX A4500搭載カードが登場!

NVIDIAのプロ向けグラフィックスカード「NVIDIA RTX A4500」を搭載したカードが週末に売り出された。同時に「NVIDIA T1000」搭載カードも出回っている。 プロ向けの「NVIDIA RTX A4000」が個人ユースでも売れている理由

プロ向けの「NVIDIA RTX A4000」が個人ユースでも売れている理由

プロ向けの「NVIDIA RTX A4000」が、ゲーム用途を含む個人ユースで売れているという。また、ゴジラとコラボしたGeForce RTX 3070搭載カードが登場するなど、グラフィックスカードが盛り上がっている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 没入感抜群の360度ドローン「Antigravity A1」を楽しむには“国の許可”が必要? 知っておくべき航空法の基礎と申請のリアル (2026年02月20日)

- Copilot+ PCの「Dell 14 Plus」がセールで約12万円に (2026年02月19日)

- ホール効果スティックで高耐久、精密な操作を実現する「BIGBIG WON BLITZ2 TMR コントローラー」がセールで9027円に (2026年02月19日)

- 日本初の限定Echo Dotは「ドラえもん」! 価格はあえての「1万1293円」 (2026年02月19日)

- 繰り返し使える「充電式カイロ」5製品を試す そもそもリチウムイオン電池内蔵で温めても大丈夫? (2026年02月20日)

- 16GB版と8GB版のすみ分けが進むRTX 5060 Ti――HDD「完売」報道の影響は? 今週末のアキバパーツ事情 (2026年02月21日)

- Ryzen AI Max+ 395搭載で驚異の性能 着脱バッテリー&水冷対応の「OneXFly APEX」と天空オリジナルUMPCを見てきた (2026年02月20日)

- 手首への負担を抑えて快適に入力できる「Ewin エルゴノミクス キーボード」が15%オフの8483円に (2026年02月19日)