Apple、日本でも児童を性的コンテンツから保護する機能を提供 最新のiOSアップデートで

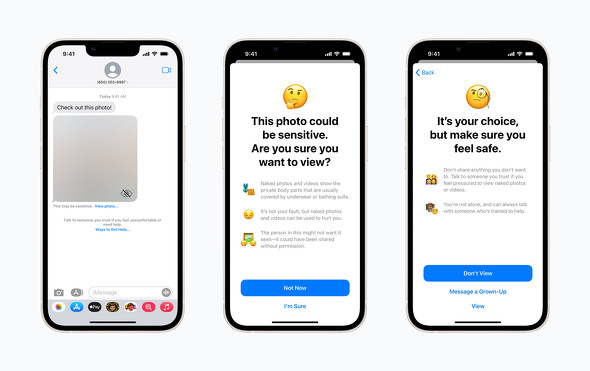

iOSのアップデート後、iOSのファミリー設定でこの機能を有効にすると、意図せぬヌード写真などの受信から該当アカウントを保護することができるようになる。写真はすぐには表示されず、有害である可能性の説明が表示される

iOSのアップデート後、iOSのファミリー設定でこの機能を有効にすると、意図せぬヌード写真などの受信から該当アカウントを保護することができるようになる。写真はすぐには表示されず、有害である可能性の説明が表示されるAppleは、間もなく行われるiOSのアップデートで子供たちを有害なメッセージから守る「Child Safety機能」を日本でも提供開始する。これは、Apple標準のメッセージアプリで裸の写真などの有害コンテンツ(CSAM:Child Sexual Abuse Material)の意図しない受信を防ぐなど、子どもの安全を守る機能だ。

日本でも子どもを有害コンテンツから守るセーフティー機能を提供開始

本機能を適用すると、誰かからメッセージで裸を含む写真が送られても写真を表示せず、代わりに裸を含む画像が届いたことを警告するメッセージが表示される。そして心に傷を負うことがある可能性を示唆するメッセージと共に、本当に表示したいかを確認するメッセージが現れる。設定によっては、大人に相談するオプションも表示される。同様の警告は裸の写真を送信しようとした際にも表示される。

なお、利用者のプライバシーに配慮して、画像の認識は外部サーバなどに頼らずiPhone端末内で行われ、通信そのものは暗号化された状態だ。裸の写真の送受信の記録がのぞかれることもない。

既に米国では2021年から提供されていた機能で、その後、2022年4月にカナダ、英国、オーストラリア、ニュージーランドといった英語圏に、同年8月にフランスとドイツ、12月にイタリアとスペインに提供国を拡大していた。

今月行われるiOSのアップデートでは、新たに日本、オランダ、スウェーデン、韓国、ブラジル、ベルギーの各国への対応が追加される(他国との違いは表示されるメッセージの言語のみで基本的に同じ)。

Appleは、これまでにもiPhone上での子供の安全を守るための機能として以下を提供してきた。

- スクリーンタイム:子供がどんなアプリをどれくらい使っているかを確認

- 通信/通話の制限:誰と連絡できるかを制限

- コンテンツとプライバシーの制限:使用できるアプリやコンテンツなどを制限

- App Storeでの子供向けセクション:広告などで個人情報の収集をしない安全なアプリのみを提供

同社は2021年に、子供を保護するためのイニシアチブを立ち上げ、専門家からさまざまな意見を求めていた。計画の中にはiCloud上に児童ポルノと思われる画像が投稿されていないかを確認し、削除する「iCloud for child sexual abuse material(CSAM)」も提案されたが、この計画は大きな議論を巻き起こす。Appleはユーザーのデータをスキャンしないでも子供を保護できるという結論に達し、この計画を中止し、代わりに2021年12月からChild Safety機能を開始した。

米国では今回、日本で提供された機能に加えて、児童に対する性的搾取などがあった場合、どこに連絡をしたらいいかを相談する機能や、児童の性的搾取につながるような検索をした場合に違法である可能性を示唆し、パートナーなどに相談するように警告を表示する機能をSiri、スポットライト検索、Safari検索に追加している。日本では、これらの機能は少なくとも今回のアップデートでは搭載されない模様だ。

なお、2022年末、米Wiredに掲載された記事では、同機能は子供を保護するためのイニシアチブの最初の一歩に過ぎず、時期は定かではないが、今後、有害なビデオ映像をフィルタリングする機能や、他社製アプリを使ったコミュニケーションへの対応なども計画中のようだ。

関連記事

有言実行を続けるAppleの新たな取り組み 直営店でiPhoneの「プライバシー」機能の理解を深める無料講座

有言実行を続けるAppleの新たな取り組み 直営店でiPhoneの「プライバシー」機能の理解を深める無料講座

Appleが1月28日の「データ・プライバシーの日」から、新たな取り組みを開始する。その内容を見ていこう。 Appleの最新CMに見る「プライバシー情報搾取」の現状

Appleの最新CMに見る「プライバシー情報搾取」の現状

Appleがプライバシーの情報搾取について、新しい啓発CMを公開した。AppleがこのCMを制作した狙いやこれまでの取り組みについて、林信行氏がまとめた。 Appleはデータプライバシーを再構築できるか?

Appleはデータプライバシーを再構築できるか?

ユーザーのデータプライバシーについて、積極的な取り組みを続けているApple。その新たな一手を林信行氏が読み解く。 “無限の柔軟性”を提供するM2搭載「Mac mini」という選択肢の魅力

“無限の柔軟性”を提供するM2搭載「Mac mini」という選択肢の魅力

Appleがエントリー向けのデスクトップPC「Mac mini」をモデルチェンジした。最新のM2やM2 Proチップを選べるなど、プロフェッショナルユースもカバーできる高いポテンシャルを備えた1台だ。発売に先立ち、林信行氏が実機を試した。 あなたのデータは大丈夫ですか? Appleが改めて問いかけるデータトラッキングへの取り組み

あなたのデータは大丈夫ですか? Appleが改めて問いかけるデータトラッキングへの取り組み

データプライバシーの日となる1月28日、Appleがデータトラッキングについて分かりやすく解説したレポート「A Day in the Life of Your Data」を公開した。改めて、同社が取り組むプライバシーデータについての取り組みをまとめた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- 「iPhone 17e」実機レビュー! 9万9800円で256GB&MagSafe対応 ベーシックモデルの魅力と割り切り (2026年03月09日)

- 「GeForce NOW」がサービスをアップデート Apple Vision ProやMeta Questで最大90fpsのゲーミングが可能に (2026年03月11日)