「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授:“超”初心者向けローカルAI「gpt-oss」導入ガイド(3)(5/5 ページ)

» 2025年09月15日 12時00分 公開

[Yukito KATO,ITmedia]

うまく動作しない場合はコンテキスト長を増やそう

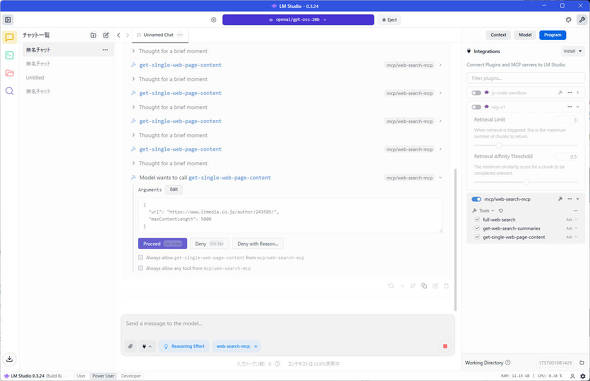

しかし、記事の内容取得の無限ループに陥ってしまった。これは、LM Studioで設定できるコンテキスト長と呼ばれる、LLMが一度に処理または記憶できるテキスト量が足りず、無限ループに陥ってしまっている。

コンテキスト長の設定変更は、一度gpt-oss-20bの読み込みを解除する必要があるので、画面上部の「Eject」をクリックしよう。

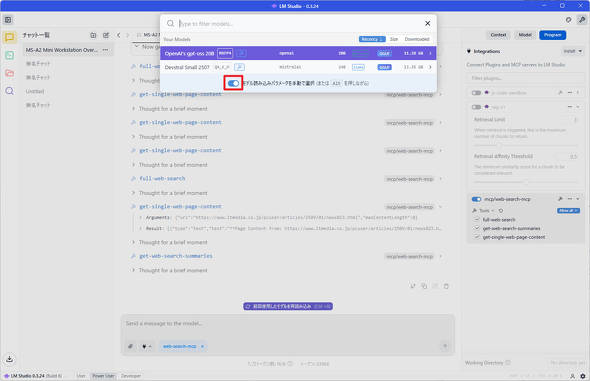

再度gpt-oss-20bを読み込むのだが、その際に「モデル読み込みパラメータを手動で選択」のスライドボタンをクリックしてから「OpenAI’s gpt-oss-20B」をクリックしてみよう。

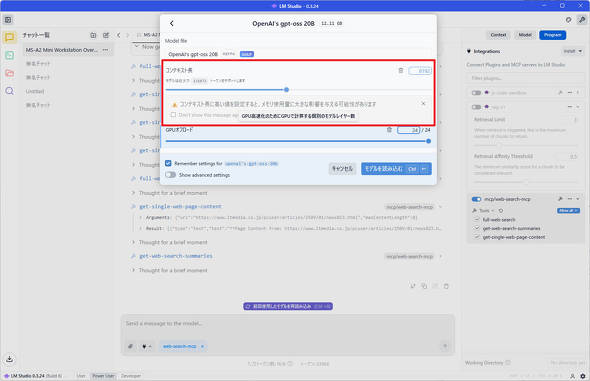

すると「コンテキスト長」を設定できる部分が表示されるので、デフォルトの4096から8192に変更し、「モデルを読み込む」をクリックしよう。

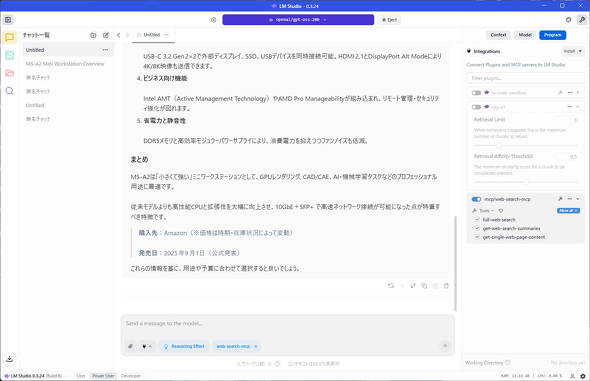

コンテキスト長を変更してから再度先ほどのプロンプトを実行してみると、今度は正常に記事内容を要約できた。

最新情報を利用できる反面、メモリ使用量が増えるデメリットも

Web Search MCP Serverを利用すれば、gpt-oss-20bで最新のデータを使った処理ができることが分かった。

しかし、コンテキスト長を増やすとその分メモリの使用量が増えてしまうことや、回答が生成されるまでに時間が多くかかってしまうデメリットもあるのがたまにきずだ。

とはいえ、有償のクラウドサービスを契約せずとも、gpt-oss-20bとWeb検索を組み合わせられる点は大きい。Gpt-oss-20bを使っている際に、おかしいなと感じた際は、Web Search MCP Serverの導入も検討してみると良いだろう。

関連記事

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

SpecialPR

アクセストップ10

2026年03月12日 更新

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- 3万円超でも納得の完成度 VIA対応の薄型メカニカルキーボード「AirOne Pro」を試す キータッチと携帯性を妥協したくない人向け (2026年03月12日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- エンスージアスト向けCPU「Core Ultra 200S Plus」登場 Eコア増量+メモリアクセス高速化+バイナリ最適化でパフォーマンス向上 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

最新トピックスPR