手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説:“超”初心者向けローカルAI「gpt-oss」導入ガイド(2)(1/4 ページ)

生成AIを手元のPC環境で動かせる「ローカルLLM」の導入から活用までを解説する本連載の第2回は、前回導入したLM Studioを使って、実際に手元のPCでLLMを動かす基本的な使い方を解説していく。

LM Studioをインストールしただけでは、LLMは利用できないため、LLMの根幹をなすモデルのダウンロードが必要だ。

→・手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

gpt-ossのダウンロード

LLM(大規模言語モデル:Large Language Models)とは、人間のような受け答えを行うために膨大なデータを学習させた自然言語処理のモデルだ。「gpt-oss」や「DeepSeek R1」などがこれに当たる。

第1回の記事でインストール手順を解説したLM StudioはLLMではなく、あくまでLLMを気軽に利用するためのツールだ。根幹をなすのはLLMとなるため、LM Studioを導入しただけでは利用できない。

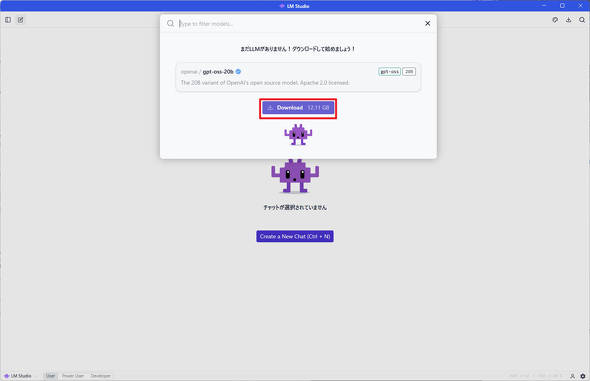

今回はLLMの導入を解説しよう。まずは下記の手順を参考に、LM Studioの中でgpt-oss-20bをダウンロードしてみよう。

LM Studioを立ち上げると、画面上部に「モデルを選択してください」と表示されている部分があるので、そちらをクリックしよう。

すると、下図の通り「openai / gpt-oss-20b」がレコメンドされるので、「Download」ボタンをクリックしてgpt-oss-20bをダウンロードする。

なお、モデル名の後ろにある「20b」とは、モデルのパラメーター数を指している。この数が大きければ大きいほど複雑な処理が可能となる指標で、いわばこのモデルがどれくらいの表現力を持っているかを示している。

ただし、このパラメータ数が伸びると性能が上がる一方で、そのPCに求められるスペックが飛躍的に向上していく。とにかく大きい物を選べば良いというわけではないため注意しよう。

参考までに、gpt-ossはgpt-oss-20b以外にgpt-oss-120bも用意されているが、推奨されるGPUのスペックは、グラフィックスメモリ(VRAM)が80GBのGPUという、個人では手の出しようがないスペックを求められる。

今回ダウンロードしたgpt-oss-20bのように、パラメータ数が20bのモデルであれば、VRAMが16GB程度のGPUでも快適に利用できるため、他のモデルを利用する際もパラメータ数が20bまでのモデルと選ぶと良いだろう。

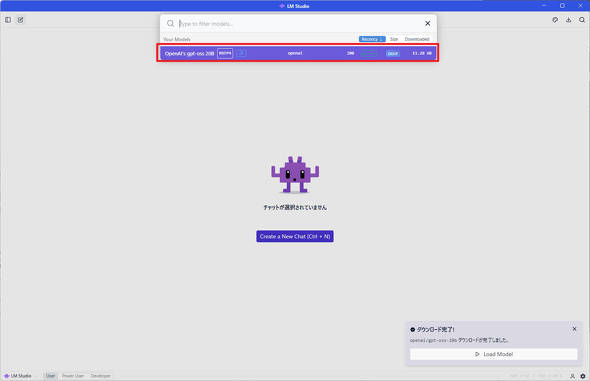

モデルのダウンロードが完了すると、下図の通り「Your Models」に「OpenAI’s gpt-oss 20b」が追加される。これでgpt-oss-20bのダウンロードは完了だ。

早速ダウンロードした「OpenAI’s gpt-oss 20b」をクリックしてみよう。

無事にモデルの読み込みが完了すると、「モデルを選択してください」の表示が「openai/gpt-oss-20b」に変わる。

これはLM Studioがgpt-oss-20bの読み込みを完了したことを指している。タスクマネージャーを確認してみると、GPUのVRAMががっつり消費されている事が見て取れる。

関連記事

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう! 生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

Qualcommは自社のSnapdragon Xシリーズを搭載するPCを強く訴求している。しかし、COMPUTEX TAIPEI 2025に合わせて設置したプライベート展示場に足を向けると、なぜかx86 PCが主体となって展示されているコーナーがあった。どうやら、Qualcommの“新製品”が展示されているそうだ。 OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、8月3日週を中心に公開された主なニュースを一気にチェックしましょう! なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

「AI PC」がマーケティング上の流行語になって1年少々。AIの処理を効率良く行えるNPUを搭載するCPUもバリエーションがそろってきた。AI PCを選ぶメリットはどこにあるのか、HPのエグゼクティブ2人に話を聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 16GB版と8GB版のすみ分けが進むRTX 5060 Ti――HDD「完売」報道の影響は? 今週末のアキバパーツ事情 (2026年02月21日)

- モニター台とドッキングステーションが合体した「Anker USB-C ハブ 10-in-1 Monitor Stand」が28%オフの1万7990円で販売中 (2026年02月20日)

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- 上下2画面で作業効率を大幅に高める「InnoView デュアル モバイルモニター」が36%オフの2万8212円に (2026年02月20日)

- ルンバが日本のために本気を出した! 「Roomba Mini」が示す“小が大を兼ねる”新基準とは (2026年02月21日)

- 内蔵タッチパッドが変形する「EWiN 折りたたみワイヤレスキーボード」が24%オフの5319円で販売中 (2026年02月20日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 微細な造形を圧倒的な解像度で実現する3Dプリンタ「ELEGOO Saturn 4 Ultra 16K」が20%オフの7万2798円に (2026年02月20日)

- 音楽生成モデル「Lyria 3」をGeminiアプリに統合 日本語の歌詞にも対応/「ChatGPT」に新たなセキュリティ機能「Lockdown Mode」を導入 (2026年02月22日)

- 「UGREEN Revodok USB-C ハブ 6in1」が2000円で買える (2026年02月17日)