手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説:“超”初心者向けローカルAI「gpt-oss」導入ガイド(2)(4/4 ページ)

PDFファイルなどのテキストファイルを添付することも可能

LM Studioにはチャット機能だけでなく、添付したPDFファイルやWordファイル(docx)、テキストデータ(.txt)、CSVデータ(.csv)を読み込み、内容に関する質疑応答を行う機能も備わっている。

クラウドサービスでも同じような機能を利用できるが、設定ミスや料金プランによっては、添付ファイルの内容が学習されてしまうリスクがある。しかし、LM Studioであればそのような心配はないため、ローカルLLMを利用するに当たって大きなメリットが得られる。

今回は筆者が過去に執筆した技術同人誌のPDFデータを使ってgpt-oss-20bに内容の要約を依頼してみたので、その手順を詳しく解説していこう。

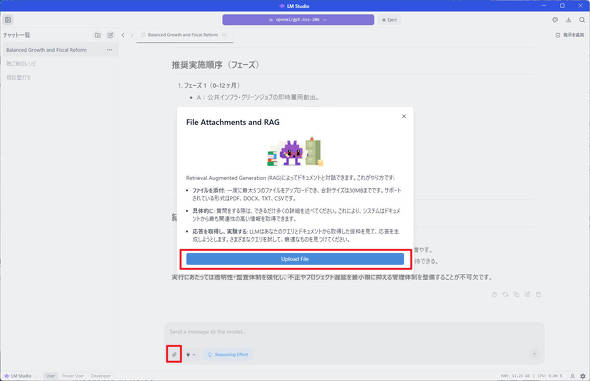

チャット欄の左下にある添付アイコンをクリックすると、上図のようなRAG(Retrieval-Augmented Generation)と呼ばれる機能の紹介が表示される。

LM Studioでは、回答を生成する際に読み込んだモデルの学習データだけでなく、外部の文書から関連情報をリアルタイムに検索し、その内容をもとに回答を生成するRAGという機能が備わっている。

本来、RAGの実装はGUIではできず、高度な知識が必要だったが、LM Studioではユーザーの操作を削減し、ファイルを添付するだけでRAGを利用できるという大きな強みを持つ。

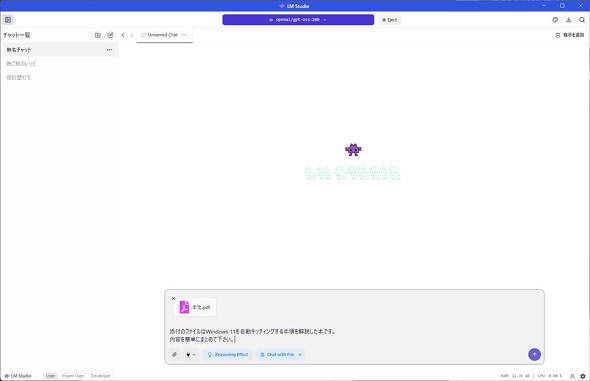

要約対象のPDFファイルを追加した上で、そのPDFファイルがどのようなファイルなのか、簡潔にまとめた上で、内容をまとめるよう依頼してみた。チャット本文は以下の通りだ。

添付のファイルはWindows 11を自動キッティングする手順を解説した本です。内容を簡単にまとめてください

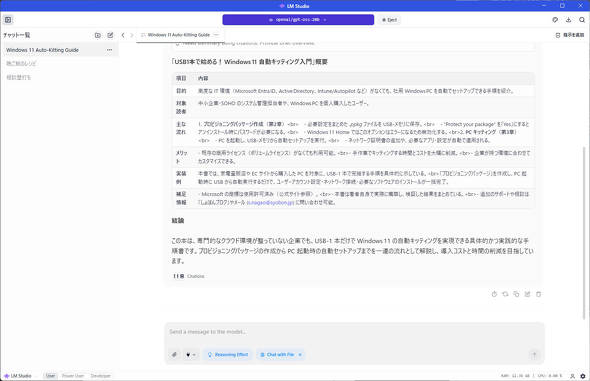

結果としては内容に特に不審な点も見当たらない要約文(サマリー)が出力された。

PDFファイルの場合、PDF内のテキストが画像ではなく、テキストデータとして扱われていることが前提とはなるものの、精度の高い要約文を作成できたのは大きい成果だ。

例えば、Google Docsで作成したドキュメントも、PDFとしてダウンロードすれば、文字がテキストデータとして認識されたPDFで出力されるため、内容理解やまとめる時間を大幅に削減できるだろう。

まとめ

本記事では、LM Studioを使ってgpt-oss-20bを手元のPCで活用する方法を解説した。特にPC内にあるテキストデータを外部に送信することなく、gpt-oss-20bを使って要約や、内容の分析が実現できる点は、ローカルLLM導入の大きなメリットと言えよう。

gpt-oss-20bのように、パラメータ数が小さいモデルであればグラフィックスカードを搭載したゲーミングPCでも快適に動作させられるので、ゲーミングPCをお持ちの方はぜひ一度、LM Studioでgpt-oss-20bを試し、生成AI時代に一歩踏み出してみてはいかがだろうか。

関連記事

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう! 生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

生成AIが笑ってしまうほど高速に――Qualcommが450TOPSの“外付け”NPUを開発 Dell Technologiesのx86ノートPCに搭載

Qualcommは自社のSnapdragon Xシリーズを搭載するPCを強く訴求している。しかし、COMPUTEX TAIPEI 2025に合わせて設置したプライベート展示場に足を向けると、なぜかx86 PCが主体となって展示されているコーナーがあった。どうやら、Qualcommの“新製品”が展示されているそうだ。 OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

OpenAIがローカルで実行可能な言語モデル「gpt-oss」シリーズを公開/Google DeepMindがリアルタイム生成可能なAIモデル「Genie 3」を発表

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、8月3日週を中心に公開された主なニュースを一気にチェックしましょう! なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

なぜPCに「AI」が必要なのか? HPのキーマン2人に聞く

「AI PC」がマーケティング上の流行語になって1年少々。AIの処理を効率良く行えるNPUを搭載するCPUもバリエーションがそろってきた。AI PCを選ぶメリットはどこにあるのか、HPのエグゼクティブ2人に話を聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- ワコムが安い? 驚きの2025年を振り返り メモリ高騰におびえる2026年の「自作PC冬眠」と「次世代CPU」への期待 (2026年02月12日)

- キンタロー。も驚くほぼ「入力ゼロ」の“次世代”確定申告 2026年の弥生は3つのAI活用とデスクトップ製品強化を両輪に (2026年02月12日)

- 新ARグラス「XREAL 1S」を試す 解像度と輝度が向上、BOSEサウンドで没入感アップ “3D変換”も大きな魅力 (2026年02月10日)

- 元Appleのジョナサン・アイブが手掛けるフェラーリ初EVの内装デザイン公開 物理ボタンとデジタルの融合 (2026年02月10日)

- マウス社長が3日間“フル参戦”した理由とは? 大阪・梅田のど真ん中で起きた“eスポーツ×地域振興”の化学反応 (2026年02月11日)

- アイ・オー、拡張ドック機能を備えたType-C接続対応の27型4K液晶ディスプレイ (2026年02月12日)

- ASRock、“CPU起動トラブルを解決”するSocket AM5マザー用のβ版BIOSを公開 (2026年02月10日)

- 「雲」から降りてきたAIは「パーソナル」な存在になれるのか――開催から1カ月経過した「CES 2026」を振り返る (2026年02月12日)

- 手のひらサイズの小型PCがお得に! GEEKOMが「冬セール」を開催中 (2026年02月12日)