「コロナ禍への対応」「機械学習の活用」「デバイス連携の深化」――3つのキーワードで見るAppleの新OS:石野純也のMobile Eye(2/3 ページ)

機械学習をフル活用、デバイス上で完結する機能を多数搭載

変化したライフスタイルに対応する新機能は目を引くが、Appleの戦略的により重要性が高いのは、機械学習を活用した機能の広がっていることだ。Appleは、自社開発のプロセッサをiPhoneやiPad、Macに搭載し、デバイス上での機械学習の処理能力を年々向上させている。特に「iPhone X」の登場以降、その傾向は顕著になった。とはいえ、単に処理能力が高いだけでは宝の持ち腐れになってしまう。土台である処理能力を生かし、どのような機能を実現できるかは重要なポイントだ。

プロセッサと端末、さらにはOSやOSの上で動くソフトウェアまでを一気通貫で手掛けているAppleは、スペックにバラつきが大きいAndroidより、この点で優位に立ちやすい。ユーザーに対してメリットを提示しやすいのは、垂直統合の強みといえる。WWDCで発表された新しいOSを見ると、以前よりも機械学習の活用が進んでいる印象を受けた。その証拠に、iOS 15やiPadOS 15には、「オンデバイスインテリジェンス」を使った新機能の数々が搭載されている。

代表的なのは、オンデバイスでのSiriだ。もともと、Siriはクラウド上でユーザーの声を分析し、発話された内容をもとに回答を返していたが、iOS 15やiPadOS 15では、この処理を端末内部で完結できるようになる。メリットは、プライバシーの強化だ。クラウドで処理しているからといって、Appleがデータを保存したり、中身を見たりしているわけではないため、必要以上に不安視する必要はないが、端末内部で処理されれば安心感はより高まる。電波の状況が悪いときや、フライトモードに設定しているときに利用できるのも、利点の1つ。クラウドを介さないことでレスポンスの向上も期待できる。

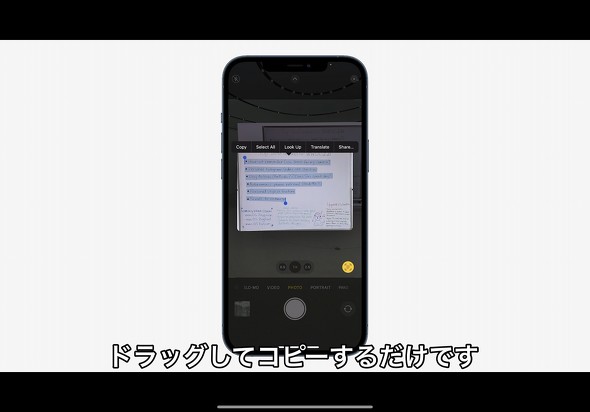

カメラで撮った文字を認識してテキストとして利用できる「ライブテキスト」も、機械学習をフル活用した機能だ。基調講演で、看板を撮った写真からそのままお店に電話する様子がコミカルな調子で披露されたように、翻訳やネット検索など、さまざまな機能と写真が有機的につながるのが、ライブテキストのメリットだ。残念ながらOS公開時には日本語には未対応だが、2020年のWWDCで発表されたiPadOS 14の「スクリブル」が2021年のiPadOS 15で対応するなど、新機能のローカライズは徐々に進められているため、ライブテキストも今後利用できるようになる可能性は高い。

他にも、通知のサマリーを作成したり、FaceTimeでバックグラウンドのノイズをカットしたりと、iOS 15やiPadOS 15では、さまざまな場所に機械学習が活用されている。こうした機能をデバイス上で実現でき、かつ適用される端末の範囲が広いのは、Appleならでは。iPhone X発表時に、Appleフェロー(当時はワールドワイドマーケティング担当上級副社長)のフィル・シラー氏は「iPhoneの次の10年の始まり」と述べていたが、3年半が過ぎ、その全体像が徐々に明らかになってきていることがうかがえる。

関連記事

「iOS 15」発表、「FaceTime」で招待やコンテンツ共有が可能に 「通知」のフィルター強化も

「iOS 15」発表、「FaceTime」で招待やコンテンツ共有が可能に 「通知」のフィルター強化も

AppleがWWDC21で「iOS 15」を発表した。2021年秋にリリースする予定。「FaceTime」を拡張し、指定した日時にユーザーを招待したり、コンテンツを共有したりできる。時間帯ごとに、ユーザーの行動と関連性の高い「通知」のサマリー表示も可能になる。 iOS 15は「iPhone 6s」と「初代iPhone SE」も対象、最多6回のバージョンアップ

iOS 15は「iPhone 6s」と「初代iPhone SE」も対象、最多6回のバージョンアップ

iOS 15はiOS 14と同様、「iPhone 6s」と初代「iPhone SE」以降のモデルが対応している。両モデルとも、2016年秋配信のiOS 10から2021年秋配信のiOS 15まで、計6回ものOSバージョンアップが可能になる。この「6回」という数字は、iPhone史上最多のバージョンアップ回数となる。 「iPadOS 15」発表 MacからiPadを操作する「ユニバーサルコントロール」やどこでもメモ機能「クイックメモ」など

「iPadOS 15」発表 MacからiPadを操作する「ユニバーサルコントロール」やどこでもメモ機能「クイックメモ」など

Appleはオンラインの「WWDC21」でiPad向けの新OS「iPadOS 15」を発表した。近くに置いたMacのキーボードやトラックパッドを使ってiPadからMacにファイルを移動できる機能や、iPadのシステム横断でメモを取れる「クイックメモ」機能などが追加される。 iOS 14とiPadOS 14のパブリックβ版を試す 「ホーム画面」と「Apple Pencil」の使い勝手はどう変わった?

iOS 14とiPadOS 14のパブリックβ版を試す 「ホーム画面」と「Apple Pencil」の使い勝手はどう変わった?

7月10日に、「iOS 14」や「iPadOS 14」のパブリックβ版がリリースされた。iOS 14ではウィジェットやAppライブラリーに対応したことで、使い勝手が大きく変わった。iPadOS 14は、iPadの魅力でもあるApple Pencilや大画面に特化したアップデートがあり、iOS 14とは異なる方向に進化している。 「ホーム画面」と「アプリの在り方」が変わる iOS 14が“飛躍的な進化”といえる理由

「ホーム画面」と「アプリの在り方」が変わる iOS 14が“飛躍的な進化”といえる理由

iOS 14は、iPhoneやiPadが10年以上かたくなに守ってきた“ホーム画面の流儀”を変えた。アプリを自動でまとめる「App Library」や、QRコード、NFCのスキャンで呼び出せる「App Clip」など、アプリの在り方を徐々に変えていこうとしているAppleの思惑も垣間見える。iOS 14から見えてきた、Appleの戦略を読み解いていきたい。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- どこでもウユニ塩湖? 3COINSで550円の「スマホ用反射ミラークリップ」を試す (2026年03月12日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)

- 「Galaxy S26」シリーズはどこが安い? 一括価格と2年間の実質負担額を比較、お得なキャリアはココだ (2026年03月11日)