ChatGPTを利用する際にやってはいけない3つのこと

相変わらず話題に事欠かない、ChatGPTを始めとする会話形AI。既に調べ物や書類作成などのとっかかりとして日常的に使っているという人もいますし、そこまでではなくとも試してみたという人は多いでしょう。

ただ、ChatGPTのようなサービスはうまく使えば有用な反面、気を付けなければいけないこともいくつかあります。今回は、そんなChatGPTなどの会話形AIで注意すべきこと、やってはいけないことをまとめてみました。

個人情報や機密情報を入力してはいけない

ChatGPTなどの会話形AIは、聞いたことに答えるだけではなく、文章を校正したり、与えられた情報を要約したりする機能も備えています。このため、議事録などの要約を作成するのにも使えるのですが、会社の重要な情報や機密資料、また個人情報などを利用するのは控えるべきです。

3月に公開されたChatGPT APIでは、ユーザーがオプトインしない限り送信したデータを学習には使用しない規約となっています。一方で、Web上のChatGPTは、入力した内容をAIの学習やシステム改善のために使用する可能性があります。このため、入力された機密情報を学習し他のユーザーとのチャット中にその情報を伝えてしまう可能性もあります。

とはいえ、大規言語モデル(LLM)の仕組み的に考えると、与えられた情報をそのまま利用することはなく、ある程度の要素に分解した上で、他の情報も含めて再構成されることになります。その意味では、直接的に情報が漏えいする可能性は低いでしょう。ただし、過去にはChatGPTがAmazonの内部データに類似した回答を行った事例も確認されているとのことです。

また、学習に利用されなかったとしても、OpenAIの担当者などがチャットの履歴を確認したり、最悪の場合には履歴データが外部に流出したりする可能性も否定できません。注意するに越したことはないでしょう。

回答をうのみにしてはいけない

会話形AIの回答は、必ずしも正確というわけではありません。AIは、主にインターネット上の情報などを学習し、それらしい回答を組み立てているだけです。Google検索をしたときに、最初に表示されるリンクの情報が正しいとは限らないことに似ているといえます。

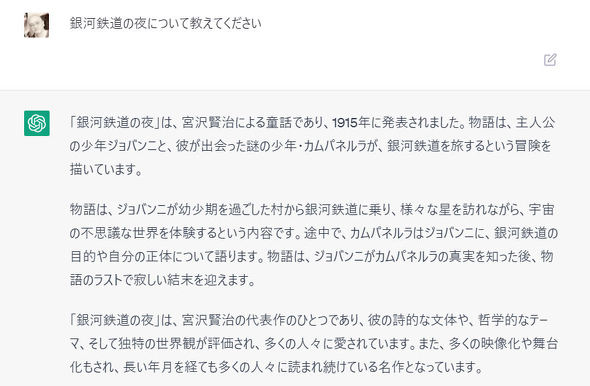

例えば、銀河鉄道の夜についてChatGPTについて質問すると、1915年に発表されたとの回答がありました。これは誤りで、初出版は1934年。執筆も1924年頃からとされています。

ここまで断言されると信じたくなりますが、回答はうのみにせず、そこから調べるための手掛かり的に使うのがよさそうです。

AIの回答が不正確なことについて、ChatGPTの開発元であるOpenAIは「ChatGPTはもっともらしく聞こえるが、不正確な答えや無意味な答えを書くことがある」と、正確な回答を行えないことがあることをChatGPTの制限事項として掲載。この問題を解決するのは、いくつかの要因から困難だとしています。

また、AIの回答は、差別や特定の思想によらないように配慮はされていますが、これに関しても完全とはいえません。人によっては気に入らいない、あるいは気分を害する回答をされる可能性もあることは覚えておきましょう。

依存しすぎてはいけない

新しいサービス、便利なサービスは積極的に使っていきたいところですが、ChatGPTや新しいBing、GoogleのBardなどがまだプレビュー段階だということを忘れてはいけません。いまは無料で利用できても(一部有料サービスも始まっていますが)、ユーザー数の増加に伴うサーバ増強のために有料化などのシナリオは十分に考えられます。

ただ、LLMは徐々にローカルで実行できるようにもなってきており、突然のサービス停止などはそこまで気にする必要はないのかもしれません。既にAIの可能性が広まっている以上、今後これを全く活用しない未来というのは考えにくいです。むしろ、急速な普及による法整備の遅れや過剰反応などの方が問題になりそうです。

以前の記事にも書きましたが、AIが生成した文章や画像の取り扱いに関しては、全面拒否する団体やツールとしての利用を認めるところなど、対応が大きく分かれているのが現状です。また、米著作権局はAI生成のコンテンツに著作権は認めないとのガイドラインを公開していますが、日本での扱いがどうなるかは、まだ明確な方針は示されていません。今後、著作権絡みの問題などが取り沙汰されだすと、取りあえずAIの使用を規制するという方向に進む可能性も否定はできません。

AIを活用するのは悪いことではありませんが、まだ過渡期だということを意識し、AIが利用できなくても困らない手段を講じておきたいところです。

関連記事

ChatGPT、Microsoft Bing、Google Bardの動向まとめ 今、対話型AIサービスで起きていること

ChatGPT、Microsoft Bing、Google Bardの動向まとめ 今、対話型AIサービスで起きていること

ChatGPT公開以来、毎日のように対話型AI関連の話題がネット上をにぎわしています。直近ではGPT-4の公開やBardの一般公開、そしてMicrosoft 365 Copilotの発表など、情勢が日々変化してきています。MicrosoftのBingやGoogleのBardも含めて、直近のAI動向をまとめました。 ChatGPTに「一番お得なスマホの料金プラン」を聞いてみた GPT-4なら正しい情報を返してくれる?

ChatGPTに「一番お得なスマホの料金プラン」を聞いてみた GPT-4なら正しい情報を返してくれる?

OpenAIが開発した対話型サービス「ChatGPT」にモバイルに関連する質問をするコーナー。今回質問したのは、スマートフォンの料金プランに関してです。大規模言語モデル「GPT-3.5」と「GPT-4」の両方で試してみました。 ChatGPTに「iPhoneとAndroidどちらがオススメなのか」聞いてみた

ChatGPTに「iPhoneとAndroidどちらがオススメなのか」聞いてみた

OpenAIが開発した対話型サービス「ChatGPT」が話題を集めています。そこで、ITmedia Mobileでは、モバイルに関連する質問を投げかけてみることにしました。今回質問したのは「iPhoneとAndroid、どちらがオススメですか?」です。 ChatGPTはどこまで“使える”ツールなのか いろいろ質問してみて分かったこと

ChatGPTはどこまで“使える”ツールなのか いろいろ質問してみて分かったこと

OpenAIのAI言語モデルを活用したチャットサービス「ChatGPT」。簡単にいうと、膨大なデータを学習し、幅広い分野の質問に詳細な回答を即座に生成してくれるものだ。何がどう便利なのか試してみた。 ChatGPTを利用したLINE「AIチャットくん」、リリース10日で50万登録を突破

ChatGPTを利用したLINE「AIチャットくん」、リリース10日で50万登録を突破

piconは、ChatGPTのAPIを利用したLINE bot「AIチャットくん」がリリース10日で登録者数50万人、総メッセージ数600万回を突破したと発表。友達追加するだけでAIとの会話を始めることができる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「Pixel 10a」は何が進化した? 「Pixel 9a」「Pixel 10」とスペックを比較 “aシリーズ初”の機能も (2026年02月19日)

- 「Google Pixel 10a」発表 ディスプレイを強化、アウトカメラがフラットに 4色を実機でチェック (2026年02月19日)

- ドコモが「いつでもカエドキプログラム」改定 残価免除に最大2.2万円、ドコモで買い替えなら免除 (2026年02月19日)

- 「Appleよ、これが『Air』の正解だ」 HONORから「Magic8 Pro Air」登場 (2026年02月18日)

- povo2.0の「サブスクトッピング」はどれだけお得? ahamoやLINEMOと比較 安く使うなら“長期”もアリ (2026年02月20日)

- 「Suicaのペンギン」卒業騒動にまつわる背景と誤解 JR東日本に聞いた (2025年11月14日)

- 「ジェミニ」か「ジェミナイ」──Geminiの正しい読み方は? Google Japanが改めて告知 (2026年01月21日)

- Anker Storeでモバイルバッテリーを回収 正しい廃棄方法を周知へ (2026年02月19日)

- ソフトバンクが「RCS」を2026年春に開始 Y!mobileやLINEMOでも利用可能に (2026年02月19日)

- 「Pokemon GO Fest:東京」は楽天モバイルも対策 目玉の「ミュウツー」は古参ファン“胸熱”な登場に? (2026年02月19日)