「ChatGPT」で話題 MicrosoftとOpenAIの関係と目指すものを整理:Windowsフロントライン(2/3 ページ)

学習モデルと応用例

深層学習(Deep Learning)を使ったOpenAIのプロジェクトはいくつか存在するが、代表的なものの1つが「Generative Pre-trained Transformer(GPT)」と呼ばれる自然言語処理(NLP:Natural Language Processing)を想定した学習モデルだ。

「Transformer」と呼ばれる比較的新しい学習モデル概念を採用しており、2018年に「Improving Language Understanding by Generative Pre-Training」(PDF)のタイトルで論文として公開されている。これが今日でいう「GPT」に相当する最初の世代とされる。

翌2019年初頭には「Generative Pre-trained Transformer 2」つまり「GPT-2」と呼ばれる第2世代のモデルが公開された。GPT-2初期公開から時間を経てブラッシュアップが行われ、最終的に同年末に完成版がリリースされている。

GPTはその名前からも分かるように、膨大なテキストの学習を経て事象や文章の繋がりを把握し、入力された命令(Prompt)に対して自然な形での応答を行うのが一連の処理の流れとなっている。Promptという名称から、WindowsにおけるコマンドプロンプトやLinuxのシェルのようなものを想像しやすいが、実際にはGPTが(目的に近い)回答しやすいようヒントや手順を与える手法に近い。

例えば、国名を挙げてその首都を提示する例を与えると、次に別の国名に対してその首都をGPTが返してくるといった具合だ。GPTではインターネットなどから膨大なデータを集めて学習を行っているが、学習が行われた時点でのデータまでしか保有していない。

そのため、例えば2019年時点の学習データしか持たないAIでは、2022年に移転先の名称が発表されたインドネシアの新首都「ヌサンタラ」の名称は把握できず、2024年に移転が完了しても現在の「ジャカルタ」を回答として返す可能性が高い。同様に、計算式を入力して回答を得る電卓的なプロンプトの使い方も可能だ。

ただし、GPTでは計算式を“文字”として認識し、学習済みデータから“それっぽい”情報を引っ張ってくるだけで、“機械的に計算した”結果ではない点に注意したい。

つまりGPTとは、世界に存在する膨大なデータの集積値から文章の繋がりを把握し、入力された値に対して結果を返しているに過ぎない。ただし、その学習データそのものが膨大であり、内容の真偽はともかく“極めて自然な回答”として戻ってくる点に特徴がある。

この学習データは「コーパス(Corpus)」と呼ばれるが、GPT-2ではその際に用いられるパラメーター数が15億で、2020年に登場したGPT-3では1750億と100倍以上に増加している。正直なところ、GPT-3の世代で生成される文章は人間が書いたものを見分けがつかないものであり、それだけ学習済みモデルが優秀であることを意味している。

2022年にはGPT-3に改良を加えた新しい学習モデルが「GPT-3.5」としてリリースされ、話題の「ChatGPT」はこのGPT-3.5をベースとしている。ChatGPTは対話型インタフェース、つまり「チャットボット」機能に特化したサービスだが、シンプルなテキストでの回答だけでなく、プログラミングからゲームまで、実にさまざまな機能をサポートしている。

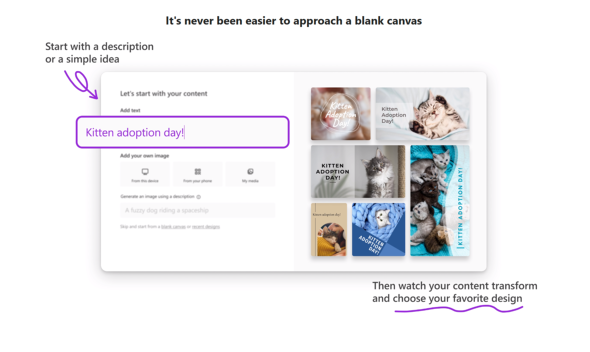

OpenAIではこの他、「DALL-E」や「Codex」といった仕組みを提供しているが、ベースとなっているのはGPTで培われた学習モデルである。DALL-Eは文章で指示を出すと、それに適したイラストを自動生成してくれる仕組みだ。「Microsoft Designer」というOfficeファミリーの製品でも「DALL-E 2」が採用されており、OpenAIとMicrosoft両社のつながりを感じさせる。

ここ最近では、Stable Diffusionを使ったAIイラストが大ブームになったことが記憶に新しいが、Stable Diffusionがローカルでの実行を想定しているのに対し、DALL-Eはクラウド上で動くサービスを利用するという点で異なっている。

Codexは「指示したプログラミングコードを自動生成する仕組み」であり、これは「GitHub Copilot」にも採用されている。このように自然言語処理を皮切りに、膨大な学習データを用いて応用分野を開拓しつつあるのが現状だ。

関連記事

一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略

一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略

Microsoftが、OpenAIに対して日本円で約1.3兆円の追加投資を行うことが話題となっている。そのことで再び脚光を浴びているのが、OpenAIのチャットボットサービス「ChatGPT」である。スゴさと課題を検証しつつ、OpenAIに追加投資を行うMicrosoftの狙いについて簡単に解説する。 Windows 10/11でスタート画面やUWPアプリが開かない問題発生

Windows 10/11でスタート画面やUWPアプリが開かない問題発生

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、1月22日週を中心に公開された主なニュースを一気にチェックしましょう! AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

アジア地域でAI が大きな成果を挙げている5 つの分野をMicrosoftが発表した。 マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

日本マイクロソフトは、AIの開発と活用において重視すべき6つの倫理的用件を発表した。 人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

シンギュラリティによってAIが人類を支配する世界がやって来るかどうかはさておき、現時点では人間がAIを悪用するリスクの方が怖そうです。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- 宅内ネットワーク環境の10G化に適した「TP-Link DS108X」が13%オフの4万803円に (2026年02月06日)

- ロジクールの「MX MASTER 4」とマウスパッドのセットが1万9400円に (2026年02月06日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- 自宅のどこでも本格サウンドが楽しめる「Bose SoundLink Home Bluetooth Speaker」が3.3万→2.3万円に (2026年02月05日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)

- Insta360初ドローン「Antigravity A1」実機レポ 360度カメラが生む“空中を自由に見渡す”没入感とは? (2026年02月06日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- Surface RT「歴史的大失敗」の裏で何が? エプスタイン文書が示すMS元幹部の焦りと情報漏えい (2026年02月05日)