「Microsoft Security Copilot」によるAIセキュリティ対策 “人力”任せからの脱却につながるか(2/3 ページ)

Security Copilotが掲げる「3原則」

最近、「ChatGPTを企業で活用する」という文脈において、プロンプトに企業機密や個人情報を入力してしまう問題がよく取り沙汰されるようになった。端的にいえば、「入力されたセンシティブな情報がLLMの学習に活用されるのではないか?」「そのような情報を含む学習データによって、外部に情報が漏えいしてしまうのではないか?」という不安である。

事実、このような問題は「Google翻訳」や「DeepL」といった無料で使えるオンライン翻訳サービスでも指摘されてきたことでもある。無料で使えるからと、企業秘密や個人情報を含む文章を翻訳させ、それが翻訳精度を向上するための学習に使われることで、情報が流出してしまう――そういうスキームだ。

この手の不安については、こうしたサービスの「有料(サブスクリプション)版」を使うことで解決できる。無料版とは異なり、元の文章と翻訳結果を学習に使わない(蓄積させない)という選択肢が用意されているのだ。

ゆえに「ビジネスで使うなら、有料版を」というビジネスモデルが成立するようになっている。

機密情報や個人情報の保護を重視しているのはMicrosoftも同様で、特にクラウドシフトを明確にして以降は、データ保護に関する取り組みを常に強調して説明している。

イベントに登壇した同社のサティア・ナデラCEOは、「Microsoftが考えるセキュリティ分野におけるAI活用の3原則」と、それを踏まえた「Microsoft Security Copilotの意義」を以下の通り説明した。

OpenAIの「GPT-4」のような新しい(言語AI)モデルとやり取りする機会がますます増えてきています。Microsoft自身も、高度なAIモデルをドメイン固有のデータと組み合わせて、短調な作業を省いて作業の効率を向上するよう努めているところです。一方で、こうした行為には人間により大きな責任が伴うものです。AIを構築する私たちは、それ(責任)を果たすための義務を背負っていると考えています。

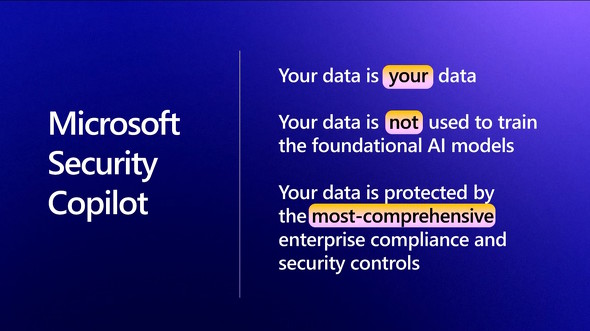

特にセキュリティ分野のイノベーションでは、3つの原則が重要だと考えています。1つ目は「あなたのデータは常にあなたのものであること」、2つめは「あなたのデータは他人が使用する学習モデルのトレーニングには用いられず、あくまで組織内にとどまること」、そして3つめは「業界で最も包括的なエンタープライズレベルのコンプライアンス(法令順守体制)とセキュリティ制御によって、あなたのデータをAIモデルを保護するということ」です。

サイバーセキュリティの脅威は、かつてないほど困難で複雑になっています。今日のサイバー攻撃は、世界で年間6兆ドルの損害を与え、2025年までに10兆ドルに達すると予測されています。Microsoftでは、あらゆる規模の組織に対して、こうした複雑さ、コストやリスクを軽減しながら、安全に利用できる作業環境の構築を支援し、あらゆる側面でサポートする製品として、Microsoft Security Copilotを用意したのです。

関連記事

Microsoft、セキュリティ専門家向けのAIアシスタントサービス「Security Copilot」を発表

Microsoft、セキュリティ専門家向けのAIアシスタントサービス「Security Copilot」を発表

米Microsoftは、セキュリティ専門家向けのAI支援サービス「Security Copilot」を発表した。 マイクロソフトはAIを全製品に展開 日常とビジネスはどう変わる? AIとの向き合い方は?

マイクロソフトはAIを全製品に展開 日常とビジネスはどう変わる? AIとの向き合い方は?

日本マイクロソフトが、報道関係者に向けてAI技術の利活用に関する説明会を開催した。提携するOpenAIの技術を中心に、全製品へのAI(人工知能)搭載を目指している同社だが、その狙いはどこにあるのだろうか。 新しいBingにみるMicrosoftのAI戦略

新しいBingにみるMicrosoftのAI戦略

MicrosoftとOpenAIの話題が飛び交っているが、Microsoftの製品で実際にどのように利用されていくのか。その一例として「Bing」を見ていこう。 「ChatGPT」で話題 MicrosoftとOpenAIの関係と目指すものを整理

「ChatGPT」で話題 MicrosoftとOpenAIの関係と目指すものを整理

Microsoftが、OpenAIへ3回目の投資が行われた。両者のつながりと、今後のMicrosoft製品への導入に関する話をまとめてみた。 一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略

一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略

Microsoftが、OpenAIに対して日本円で約1.3兆円の追加投資を行うことが話題となっている。そのことで再び脚光を浴びているのが、OpenAIのチャットボットサービス「ChatGPT」である。スゴさと課題を検証しつつ、OpenAIに追加投資を行うMicrosoftの狙いについて簡単に解説する。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- Googleが「Pixel 10a」発表 499ドルでフラッグシップ級のAI機能を搭載 AirDropや衛星SOSも対応 (2026年02月19日)

- 日本初の限定Echo Dotは「ドラえもん」! 価格はあえての「1万1293円」 (2026年02月19日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 最大3画面出力と100W給電に対応した「UGREEN 14-in-1 ドッキングステーション」がセールで1万3990円に (2026年02月18日)

- ChatGPT連携で文章の要約や下書きもこなす電子ペーパーノート「iFLYTEK AINOTE Air 2」がセールで6万799円 (2026年02月18日)

- 5層の吸音材で極上のキータッチを実現した75%キーボード「EPOMAKER x Aula F75」が25%オフの1万490円に (2026年02月18日)

- 「UGREEN Revodok USB-C ハブ 6in1」が2000円で買える (2026年02月17日)

- Copilot+ PCの「Dell 14 Plus」がセールで約12万円に (2026年02月19日)

- 中小企業のビジネスPC調達は絶対に新品であるべきか? コスパを最大化する“中古/新古品”という選択肢の是非 (2026年02月19日)