Intelが次世代CPU「Meteor Lake」の概要をチラ見せ 全モデルに「AIエンジン」を搭載

Intelは5月29日(米国太平洋夏時間)、開発コード名「Meteor Lake(メテオレイク)」のCPUに関する新情報を公開した。このCPUは、次世代の電力管理機能の他、刷新された「Intel Xe Graphics」や新しい「AIエンジン(VPU)」を搭載することでパフォーマンスの向上と省電力化を両立するという。正式な発表は「2023年後半」を予定している。

Meteor Lakeの概要

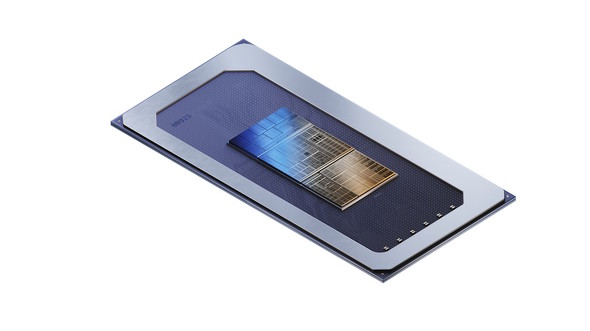

Meteor Lakeは現行の第13世代Coreプロセッサ(開発コード名:Raptor Lake)の後継で、順当に行けば「第14世代Coreプロセッサ」となる予定のCPUだ。既報の主な特徴は以下の通りである。

- 「Intel 4(7nmプロセス)」を適用して生産される初めての製品

- 複数の「タイル(ダイ)」を組み合わせて1枚のチップを構成(一部のタイルは他社で生産したものを利用)

- 3Dパッケージング技術「Foveros」を適用

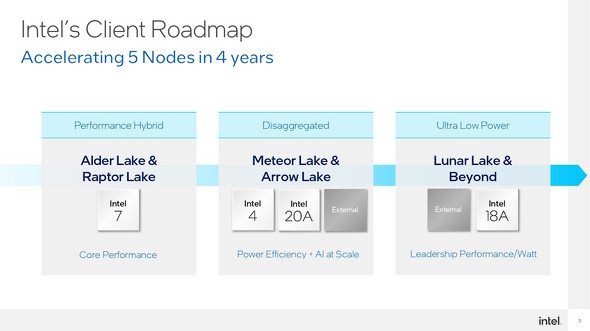

Meteor Lakeの後継CPU「Arrow Lake」(開発コード名)は、新たな電源半導体「RibbonFET」とIntel独自の裏面電源供給技術「PowerVia」を組み合わせたプロセス「Intel 20A」を、Arrows Lakeの次に来る「Lunar Lake」(同)ではIntel 20Aを改良したプロセス「Intel 18A」を採用する計画となっている。

今回の新情報は、Meteor Lakeに搭載されるAIエンジンに焦点を当てている。

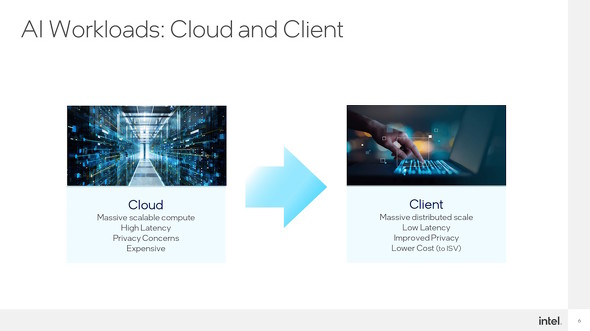

昨今の「AI(人工知能)」は、いわゆる機械学習(マシンラーニング)や深層学習(ディープラーニング)をベースにしているものが多い(以下、機械学習と深層学習をまとめて「機械学習」とする)。機械学習ベースのAIは、膨大なデータを処理しなければならないため、従来は圧倒的な演算能力を持つサーバ(データセンター)を行う必要があった。

しかし最近は、より高速な応答の実現やプライバシー保護の観点から機械学習処理をローカルで行うニーズが高まっている。スマートフォンやタブレット向けのSoC(System-on-a-Chip)では、CPUコアやGPUコアとは別に機械学習処理に特化したVPUを搭載する動きがいち早く起こったが、PC向けCPU(SoC)でもAMDが「Ryzen 7040シリーズ」の一部モデルにCPU/GPUコアから独立したVPUを搭載している。

応答速度の向上(低遅延)、プライバシー保護の観点から、ローカル(クライアントサイド)で機械学習処理を“完結”させるニーズは高まっている。機械学習を利用するアプリの利用者/開発者の立場から見ると、外部サーバ(データセンター)を利用するコストを削減する観点から機械学習のローカル処理ニーズがあるという

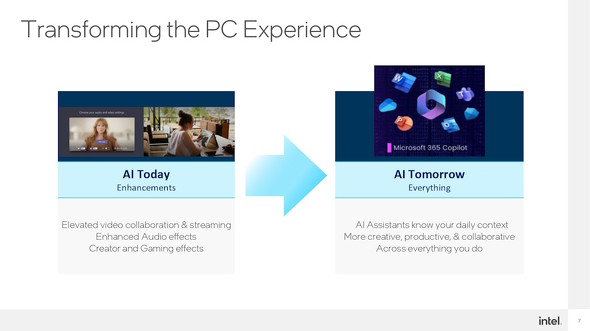

応答速度の向上(低遅延)、プライバシー保護の観点から、ローカル(クライアントサイド)で機械学習処理を“完結”させるニーズは高まっている。機械学習を利用するアプリの利用者/開発者の立場から見ると、外部サーバ(データセンター)を利用するコストを削減する観点から機械学習のローカル処理ニーズがあるという PCにおけるAIのローカル処理は、今まではどちらかというとPCやアプリの「機能拡張」という観点で使われることが多かった。しかし、コンテンツ生成型AIの急速な普及にも見られるように、昨今はPCを利用するあらゆる局面で使われるものになりつつある

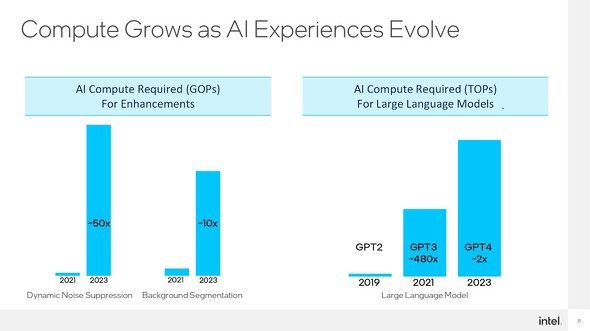

PCにおけるAIのローカル処理は、今まではどちらかというとPCやアプリの「機能拡張」という観点で使われることが多かった。しかし、コンテンツ生成型AIの急速な普及にも見られるように、昨今はPCを利用するあらゆる局面で使われるものになりつつある AI処理において求められる演算量も加速度的に増えつつある。そういう意味では、単純にCPUやGPUの演算能力を高めるよりも、機械学習に特化したAIプロセッサを搭載した方がパフォーマンスの改善につながる可能性がある

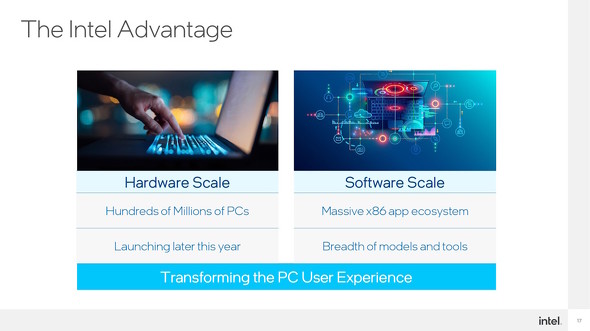

AI処理において求められる演算量も加速度的に増えつつある。そういう意味では、単純にCPUやGPUの演算能力を高めるよりも、機械学習に特化したAIプロセッサを搭載した方がパフォーマンスの改善につながる可能性があるMeteor Lakeは、従来のx86アーキテクチャCPU向けのソフトウェア資産を活用しつつ、独立したAIエンジン(VPU)を搭載することで「『今まで』と『これから』の橋渡しを行うCPU」になるという。

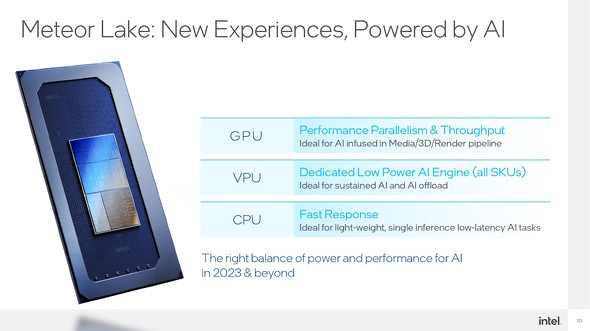

内蔵GPU(Intel Iris Xe Graphics)では、並立処理のスループット(実効速度)を向上することで、主に3DレンダリングにおけるAI処理パフォーマンスを向上する。

また先述の通り、独立したVPUを搭載することでCPU/GPUにおけるAI処理のオフロードや、継続的なAI処理パフォーマンスの向上を図る。Ryzen 7040シリーズではVPUの搭載が一部モデルに限られることを意識してか、IntelはMeteor Lakeでは全てのモデルでVPUを搭載していることを強くアピールしている。

そしてCPUコアもレスポンスを改善する改良を加えることで、軽量かつ単一推論で済むAI処理のパフォーマンスを改善するとしている。

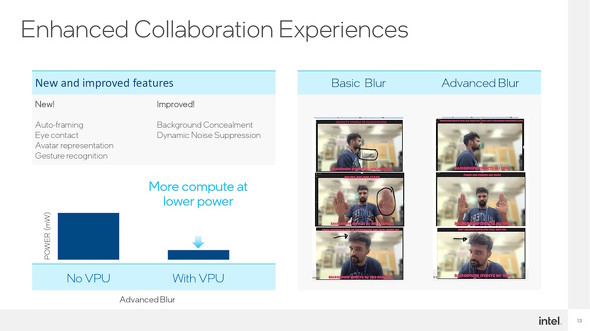

問題は、VPUの搭載によってどのくらいのパフォーマンス改善効果があるかという点に尽きる。Intelによると、ビデオ(Web)会議では消費電力を抑えつつ、以下の新機能と改善を実現できるという。

- 新機能

- オートフレーミング

- 視線合わせ

- アバター表示

- 身ぶりの認識

- 改善

- 背景隠し(ぼかしなど)の精度

- 動的なノイズ抑制の精度

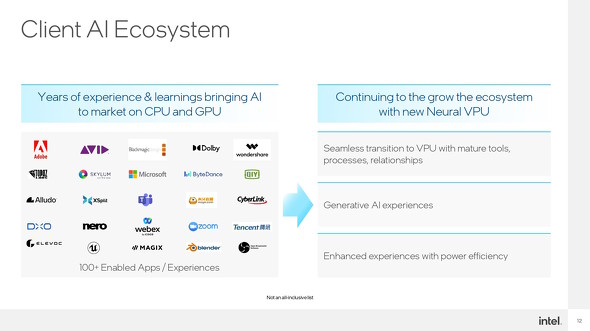

ただ「全てのモデルにVPUを搭載する」とはいっても、肝心のアプリがVPUに対応していなければ意味はない。そこでIntelは「エコシステム」を活用して一気に対応アプリを拡大する方針のようだ。

サードパーティー製のアプリでは既に、IntelのCPU/GPUを使って機械学習ベースのAIを実装しているケースがある。これをシームレスにVPU対応にすべく、ツール類の提供を行うなどサードパーティーとの連携を強化していくという。

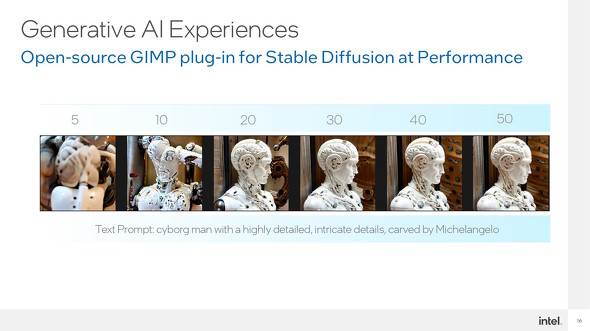

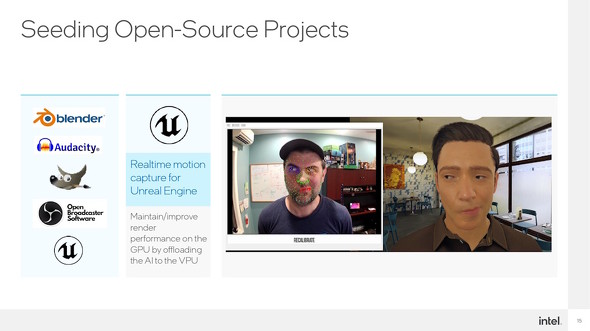

また、オープンソースコミュニティへのコミットメントも強化し、VPUをより活用しやすくなる環境作りも進めていく。

VPUの活用を進めるべく、オープンソースプロジェクトへのコミットメントも強化する。ゲームで使われることの多い「Unreal Engine」では、リアルタイムモーションキャプチャにおける機械学習処理をVPUにオフロードすることで、GPUのレンダリングパフォーマンスを維持/改善できるようになるという

VPUの活用を進めるべく、オープンソースプロジェクトへのコミットメントも強化する。ゲームで使われることの多い「Unreal Engine」では、リアルタイムモーションキャプチャにおける機械学習処理をVPUにオフロードすることで、GPUのレンダリングパフォーマンスを維持/改善できるようになるという関連記事

モバイル向け「第13世代Coreプロセッサ(Raptor Lake)」登場 新型エントリーCPUや一般デスクトップ向けCPUも追加

モバイル向け「第13世代Coreプロセッサ(Raptor Lake)」登場 新型エントリーCPUや一般デスクトップ向けCPUも追加

Intelがハイエンドデスクトップ向けを先行発表していた「第13世代Coreプロセッサ(Raptor Lake)」。その追加ラインアップが発表された。合わせて、エントリー向けの新型CPUも発表されている。【更新】 イスラエルのIntelハイファラボで見た“ちょっと未来”のPC像

イスラエルのIntelハイファラボで見た“ちょっと未来”のPC像

Intelはイスラエルに一大拠点を構えている。先日、報道関係者向けにその現状を伝えるツアーが開催されたが、今回は「Intel 8088」や「MMX Pentium」などを生み出したハイファにあるIDC(Israel Development Center)において実際に研究/開発された技術のデモンストレーションの様子をお伝えする。 2025年までに「1.8nm相当」に――Intelが半導体生産のロードマップを説明

2025年までに「1.8nm相当」に――Intelが半導体生産のロードマップを説明

Intelが半導体生産のロードマップを説明するイベントを開催した。2022年には7nmプロセスの製品が、2024年には新技術を取り入れた製品が登場する見通しだ。 AI処理パフォーマンスを大きく改善 4nmプロセスのモバイルAPU「Ryzen 7040シリーズ」登場 搭載製品は3月以降に登場

AI処理パフォーマンスを大きく改善 4nmプロセスのモバイルAPU「Ryzen 7040シリーズ」登場 搭載製品は3月以降に登場

AMDの最新CPUアーキテクチャ「Zen 4」が、いよいよモバイル向けに登場する。メインストリームとなるRyzen 7040シリーズでは、CPUコアが4nmプロセスとなり省電力性能が高まった他、最新の「RDNA 3アーキテクチャ」のGPUや独立したAIアクセラレーターも統合していることも特徴だ。 Intelが「第4世代Xeonスケーラブルプロセッサ」を正式発表 後から機能を拡張できる「Intel On Demand」対応モデルも

Intelが「第4世代Xeonスケーラブルプロセッサ」を正式発表 後から機能を拡張できる「Intel On Demand」対応モデルも

Intelが、データセンター(サーバ)/HPC向けCPU「Xeonスケーラブルプロセッサ」の第4世代製品を正式に発表した。先行リリースされたHBM2付きの「Xeon CPU Max」と合わせて、一部モデルを除き後から機能を追加できる「Intel On Demand」にも対応する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 動き出した「次世代Windows」と「タスクバー自由化」のうわさ――開発ビルドから読み解く最新OS事情 (2026年02月26日)

- ASUS JAPANが新型ノートPCを一挙に披露 16型で約1.2kgな「Zenbook SORA 16」など目玉モデルが“めじろ押し” (2026年02月27日)

- 幅広いiPadで使えるロジクールのデジタルペン「Crayon(教育現場モデル)」が49%オフの4980円に (2026年02月26日)

- ソニーの75型4K液晶TV「KJ-75X75WL」がセールで約15万円に (2026年02月26日)

- バッファローがBlu-ray Discドライブの販売を終了 (2026年02月26日)

- 読者の声から生まれた1台! PC USER×MousePro コラボモデル第1弾「MousePro C3」誕生の裏側 (2026年02月26日)

- 公取委が日本マイクロソフトに立ち入り調査 独禁法違反の疑い 複数の報道 (2026年02月25日)

- 攻めの構造と98%レイアウトの賛否はいかに? ロジクールの“コトコト”キーボード「Alto Keys K98M」を試す (2026年02月25日)

- 8Kの超高精細な全天球映像が撮れる「DJI Osmo 360 スタンダードコンボ」が28%オフの4万8400円に (2026年02月26日)

- 原神ファン必見の白ゲーミングマウス「ロジクール G G309 LIGHTSPEED 神里綾華 特別モデル」が22%オフの6900円に (2026年02月26日)