テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法:“超”初心者向けローカルAI「gpt-oss」導入ガイド(4)(1/4 ページ)

前回までは「gpt-oss-20b」を使ってテキストデータを用いたLLMの活用方法を解説してきた。テキストデータだけでも十分活用できるが、欲を言えば画像や動画、音声なども取り扱えるようにしたいところだろう。

そんな方に朗報だ。LM Studioではテキストデータだけでなく、画像も理解できる視覚言語モデル(VLM:Vision-Language Model)に対応したAIモデルを読み込むことで、さらに活用の幅を広げられる。

残念ながらgpt-oss-20bはVLM対応のモデルではないため、今回の記事ではいったんgpt-oss-20bから離れ、VLM対応のモデルをローカルPC環境で使う方法を確認していこう。

【第1回】手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

【第2回】手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

【第3回】「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

LM StudioでVLMを試す

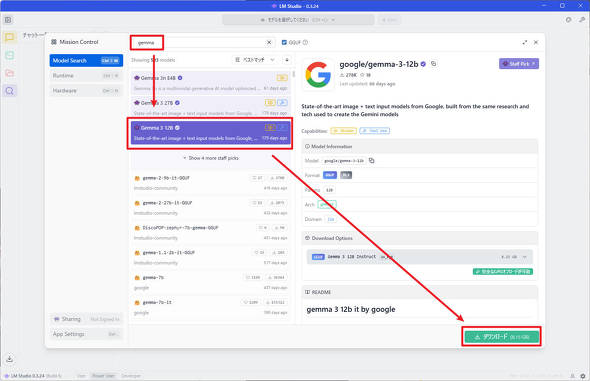

それでは早速、前回までに紹介してきたLM Studioを使ってVLMを試してみよう。まずは、LM Studioの左側にある虫眼鏡アイコンをクリックし、モデルのダウンロード画面に移動する。

モデルのダウンロード画面が表示されるので、モデル名の検索欄に「gemma」と入力し、Geminiモデルの開発に用いられた研究と技術に基づいてGoogleが作成した「gemma-3-12b」をダウンロードしよう。これは画像データも扱えるモデルだ。

モデルのダウンロードが完了すると、「Downloads」ウィンドウに「モデルを読み込む」ボタンが表示されるので、クリックしてgemma-3-12bを読み込もう。

前回、ユーザーインタフェースの複雑さをパワーユーザーモードに切り替えていたので、モデル読み込み時のパラメーター入力画面が表示されるはずだ。

今回はテストで利用するため、コンテキスト長はデフォルト設定のまま、「モデルを読み込む」ボタンをクリックする。

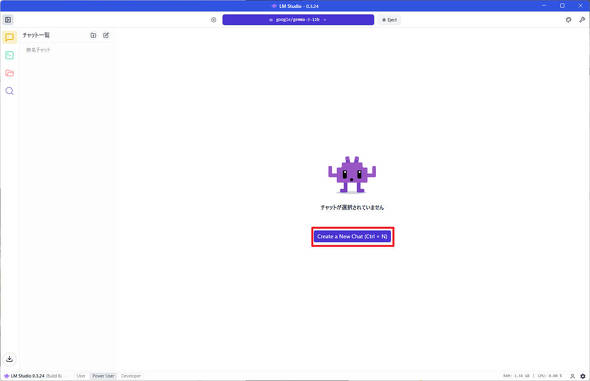

モデルの読み込みが完了したら、「Create a New Chat」ボタンをクリックし、新規のチャットインタフェースを開こう。

ここまで完了したら準備は完了だ。早速、gemma-3-12bを使って画像認識機能をいろいろと試してみよう。

関連記事

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- 「iPhone 17e」実機レビュー! 9万9800円で256GB&MagSafe対応 ベーシックモデルの魅力と割り切り (2026年03月09日)

- 「GeForce NOW」がサービスをアップデート Apple Vision ProやMeta Questで最大90fpsのゲーミングが可能に (2026年03月11日)