テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法:“超”初心者向けローカルAI「gpt-oss」導入ガイド(4)(4/4 ページ)

文字認識の精度はどの程度か?駅の看板を元にテストしてみた

さて、先ほどのラーメンの丼にかかれた文字を、gemma-3-12bは正しく認識できなかった。人であれば難なく読めるものの、筆文字ライクなデザインなので、生成AIモデルでは認識しづらいのかもしれない。

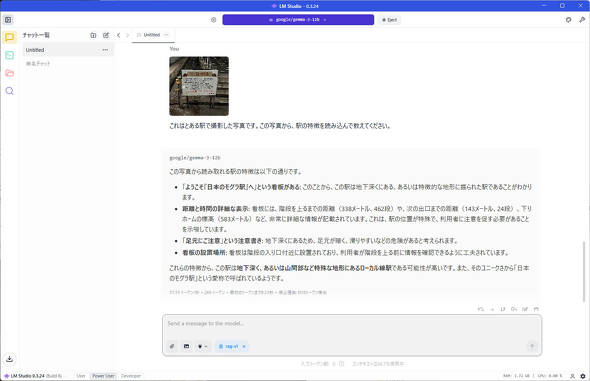

であれば、文書として記載された文字列であれば正しく認識できるはずだ。そこで筆者が先日、汗だくになりながらたどり着いた土合駅の地下ホームに設置されている看板の写真でテストしてみることにした。

駅のキャッチコピーである「日本一のモグラ駅」にある漢数字の「一」を記号として捉えてしまったが、看板の内容を認識した上で、端的に特徴を捉えていることが分かる。

この写真から読み取れる駅の特徴は以下の通りです。

- 「ようこそ『日本のモグラ駅』へ」という看板がある:このことから、この駅は地下深くにある、あるいは特徴的な地形に掘られた駅であることが分かります。

- 距離と時間の詳細な表示:看板には、階段を上るまでの距離(338メートル、462段)や、次の出口までの距離(143メートル、24段)、下りホームの標高(583メートル)など、非常に詳細な情報が記載されています。これは、駅の位置が特殊で、利用者に注意を促す必要があることを示唆しています。

- 「足元にご注意」という注意書き:地下深くにあるため、足元が暗く、滑りやすいなどの危険があると考えられます。

- 看板の設置場所:看板は階段の入り口付近に設置されており、利用者が階段を上る前に情報を確認できるように工夫されています。

これらの特徴から、この駅は地下深く、あるいは山間部など特殊な地形にあるローカル線駅である可能性が高いです。また、そのユニークさから「日本のモグラ駅」という愛称で呼ばれているようです。

写真に写った文字列をしっかりと認識しているので、例えば写真撮影が許可されているセミナーで、発表スライドの写真だけ撮影しておき、後でgemma-3-12bを使えばスライド資料の文字起こしに活用できそうだ。

手書きのメモも写真で撮影すればそのままサクッと文字起こしできそうだ。ただ、筆者のように字が汚い場合は、認識率が下がってしまうかもしれないが……。

画像に対応したモデルでさらに活用の幅を広げてみては

撮影した写真を外部のクラウドサービスに送信することなく、手元のPC上で処理できるため、データの外部漏えいを気にせずに、画像データを使ったLLMの利用ができる点は非常にうれしいポイントだ。

テキストデータだけでも活用幅は十分に広かったが、gemma-3-12bなどのように画像に対応したモデルを利用する事でさらに活用の幅を広げられそうだ。テキストデータだけでは物足りないと感じる方は、ぜひ試してみて欲しい。

関連記事

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 3万円超でも納得の完成度 VIA対応の薄型メカニカルキーボード「AirOne Pro」を試す キータッチと携帯性を妥協したくない人向け (2026年03月12日)

- エンスージアスト向けCPU「Core Ultra 200S Plus」登場 Eコア増量+メモリアクセス高速化+バイナリ最適化でパフォーマンス向上 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)