Appleの生成AI「Apple Intelligence」でできること 10月から日本で使う方法は?(2/2 ページ)

パーソナルアシスタント「Siri」の改良

2011年に発表され、iPhone 4Sに初めて搭載された音声パーソナルアシスタント「Siri」も、Apple Intelligenceによって大きく再設計される。

まずユーザーの問いかけの文脈をより自然に理解できるようになり、ユーザーが途中で言葉につまづいて言い直しても、連続的な会話として文脈の理解を維持できる。例えば「アラーム、いやタイマーを10分……やっぱり5分」と言っても、Siriは文脈を理解してタイマーを5分に設定できるという。

Appleは「膨大な製品知識にもとづいて、Apple製デバイスの機能や設定に関する何千もの質問に答えてくれるので、ユーザーは、画面収録の方法からWi-Fiパスワードの簡単な共有方法まで、あらゆることを学べる」としており、当初は“Apple製品に詳しいSiri”という印象になりそうだ。

また、Siriは今後の機能拡張が予定されている。近い将来にはChatGPTに接続され、より幅広い汎用(はんよう)的な知識を理解したり、回答したりできるようになるという。

さらに追加される将来的な機能は?

Appleは今後数カ月、もしくは2024年内に、さらに次のような多くの機能をApple Intelligenceに追加すると予告している。

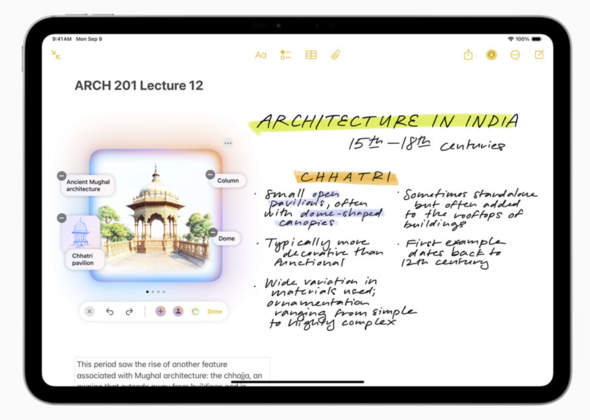

- ラフスケッチから画像生成

- メモの内容をもとにした生成画像をメモの空白部分に挿入

- 説明や写真の人物からオリジナル絵文字を作る

- よりパーソナルな情報を使ったSiriのアシスタント

- オンスクリーン認識を通じて、純正アプリやサードパーティー製アプリ内の一機能をアクションとして呼び出して使う

この中でも筆者が特に注目しているのが、最後のオンスクリーン認識だ。画面上の内容をもとに指示を出せるもので、例えばメッセージアプリで友達から住所が送られてきたとする。そこでSiriに「この住所を連絡先に追加して」と言えば、その後の細かな作業はSiriが代行してくれる。

さらに「下書きしたメールを○○さんと○○さんに送って」と頼めば、Siriがどのアプリに保存されたメールの下書きを指しているのかを理解して作業してくれる。

他にも「この写真を明るくして」と写真の補正を依頼してから、メモアプリに保存された特定にメモに保存するように指示できるなど、実際に使ってみるまでは本当にそんなことができるのか疑ってしまいそうな機能もApple Intelligenceには控えている。

これらの機能が実装されたら、iPhone/iPad/Macの使い勝手は劇的に変化するだろう。

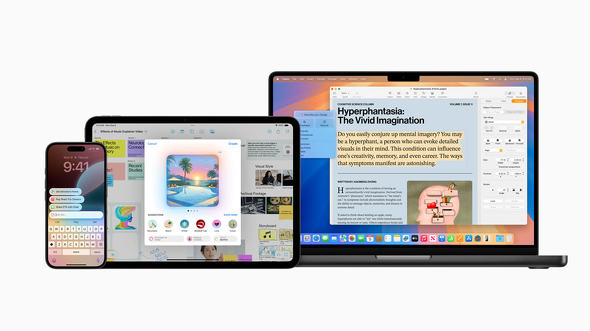

Apple Intelligenceが使えるOSは?

Appleは、Apple Intelligenceを自社の幅広い製品で使えるようにしたい考えだ。対応するOSはiOS 18.1、iPadOS 18.1、macOS Sequoia 15.1で、対応機種はiPhone 15 Pro/Pro Max、iPhone 16シリーズ、M1チップ以降を搭載したiPad/Macとなっている。

基本的に多くのタスク処理はデバイス上で完結するが、より多くのAI処理性能が求められる場面では、Appleが構築した専用のクラウド「Private Cloud Compute」に接続して実行されるなど、必要に応じて演算能力を動的に拡張されるのがApple Intelligenceの特徴だ。

ちなみに本体とSiriの言語設定を英語にすると、日本で発売されたiPhoneでもApple Intelligenceが使えるようだ。Appleのプレスリリースにもそうした記載があるため、iOS 18.1がリリースされ次第、試してみるのもいいだろう。

関連記事

「iPhone 16/16 Pro」の実機を速攻チェック 新搭載の「カメラコントロール」や“大きくなった”Proはどう?

「iPhone 16/16 Pro」の実機を速攻チェック 新搭載の「カメラコントロール」や“大きくなった”Proはどう?

発表されたばかりの「iPhone 16」シリーズ実機を写真で解説。iPhone 16はProよりもカジュアルな仕上げになっており、カメラの配置を見直した。無印でもProでも使える「カメラコントロール」は、ズームから撮影までをスムーズに行えた。 「iPhone 16/16 Pro」は何が進化した? iPhone 15シリーズとスペックを比較する

「iPhone 16/16 Pro」は何が進化した? iPhone 15シリーズとスペックを比較する

Appleが9月10日、最新スマートフォン「iPhone 16」シリーズを発表した。「iPhone 16」「iPhone 16 Plus」「iPhone 16 Pro」「iPhone 16 Pro Max」の4機種が15シリーズからどう進化したのかをまとめる。16/16 Plusは2つの新ボタンを搭載し、16 Pro/16 Pro Maxは画面サイズが大きくなった。 「iPhone 16/16 Plus」発表、カメラボタンでAIを操作 新チップ「A18」搭載

「iPhone 16/16 Plus」発表、カメラボタンでAIを操作 新チップ「A18」搭載

Appleは9月10日、iPhone 16シリーズを発表した。Proモデルと同じ世代のA18チップを搭載し、カメラとAI制御のためのボタンが追加された。 「iPhone 16 Pro/16 Pro Max」発表 カメラ専用ボタン搭載、大画面化、4K120fps動画撮影も

「iPhone 16 Pro/16 Pro Max」発表 カメラ専用ボタン搭載、大画面化、4K120fps動画撮影も

iPhone 14/15を値下げ 「iPhone 16」シリーズ発表で変わった全iPhoneの価格一覧

iPhone 14/15を値下げ 「iPhone 16」シリーズ発表で変わった全iPhoneの価格一覧

Appleが「iPhone 16」シリーズを発表した。これに伴い3モデルが販売終了になり、残ったモデルはSE以外は値下げされた。新モデルの価格は「iPhone 15」シリーズの発売時と同じ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 【無印良品】ウエストポーチもになる「スリングバッグ」が3990円に値下げ中 植物由来の原料を使用 (2026年03月11日)

- Qualcommのウェアラブル新チップが「Elite」を冠する理由 最新モデム「X105」は衛星通信100Mbpsへ (2026年03月11日)