サーバ向けGPU「NVIDIA A100」「NVIDIA H100」に液冷対応モデル登場 消費電力と設置スペースを削減:COMPUTEX TAIPEI 2022

NVIDIAは5月24日(台湾時間)、サーバ/データセンター向けGPU「NVIDIA A100」と「NVIDIA H100」の液冷モデルを順次投入することを発表した。グラフィックスカードやソリューションは、パートナー企業を通して順次発売される予定となっている。

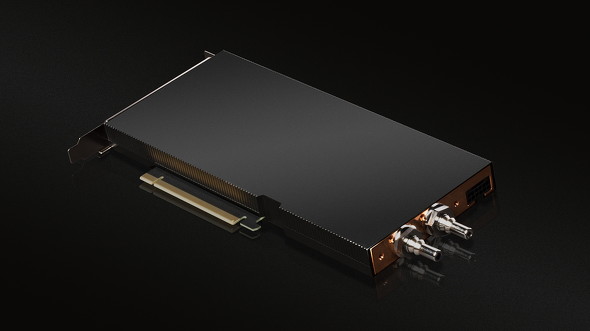

A100 80GB PCIe Liquid-Cooled GPU(2022年夏から出荷予定)

「NVIDIA A100 80GB PCIe Liquid-Cooled GPU」は、2021年6月28日(米国太平洋時間)に発表された「NVIDIA A100 80GB PCIe」を液冷対応としたモデルだ。既に米Equinix(エクイニクス)のデータセンターなどで動作検証が進められており、検証用サンプルも出荷が始まっている。製品版の出荷は2022年第3四半期(7〜9月)から段階的に開始する予定だという。

液冷の一番の効果は、GPUの冷却に使われる水と電力の大幅な削減だという。データセンターにはCPU、GPU、ストレージ、ネットワークチップなど数多くの「熱源」がある。これらを冷却するために強力な冷却装置が設置されるのだが、その稼働のために多くの水と電力が消費される。

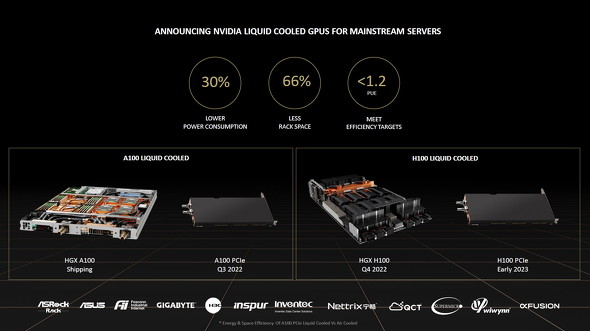

NVIDIAとEquinixが別々に実施したテストによると、液冷対応をしたデータセンターと空冷対応のデータセンターで同じ処理作業(ワークロード)を実施した場合、液冷対応のデータセンターでは消費電力を約30%削減できたという。NVIDIAの試算では、液冷対応のデータセンターはPUE(※1)を1.6から1.15に削減できる上、カードの設置間隔を2分の1にできるとのことだ。

(※1)電力使用効率:データセンター全体で使われる消費電力をデータセンター内で使われているICT関連機器の消費電力で割って求められる値。理論上は「1」に近いほど効率が良いとされる

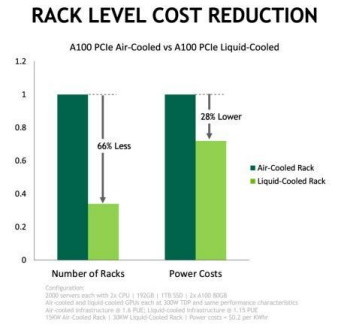

同じ処理能力になるようにNVIDIA A100 PCIe 80GBの従来(空冷)モデルと液冷モデルを用意して比較すると、液冷モデルは設置面積を66%、消費電力を28%削減できるという(NVIDIAの試算)

同じ処理能力になるようにNVIDIA A100 PCIe 80GBの従来(空冷)モデルと液冷モデルを用意して比較すると、液冷モデルは設置面積を66%、消費電力を28%削減できるという(NVIDIAの試算)今後は「NVIDIA H100」の液冷モデルも登場予定

NVIDIAは既に、HGX接続のNVIDIA A100の液冷モデルを出荷済みだ。今回リリースされたPCI Express接続の液冷モデルは「第2弾」である。

NVIDIAは、新アーキテクチャGPUを搭載する「NVIDIA H100」でも液冷モデルを投入する計画を立てている。投入予定時期は以下の通りだ。

- HGX接続タイプ:2022年第4四半期(10〜12月)

- PCI Express接続タイプ:2023年初頭

関連記事

NVIDIAのデータセンター向けGPU「NVIDIA A100」PCI Express 4.0モデルに80GB構成登場 メモリ帯域幅は毎秒2TBに拡張

NVIDIAのデータセンター向けGPU「NVIDIA A100」PCI Express 4.0モデルに80GB構成登場 メモリ帯域幅は毎秒2TBに拡張

NVIDIAのデータセンター向けGPU「NVIDIA A100」のPCI Expressカードモデルに、グラフィックスメモリを80GBに倍増した構成が登場する。従来の40GB構成と比べてメモリ帯域幅が拡張されており、メモリ容量増加以上のパフォーマンスアップを期待できる。 NVIDIAがデータセンター向けGPU「NVIDIA H100」を発表 新アーキテクチャ「Hopper」を採用

NVIDIAがデータセンター向けGPU「NVIDIA H100」を発表 新アーキテクチャ「Hopper」を採用

NVIDIAが、新アーキテクチャのデータセンター向けGPUを発表した。現行のAmpereアーキテクチャから演算能力やデータ点速度を引き上げた他、別売の専用ハードウェア(ラック)を用意することで最大256基のGPUをより高速に連結できる仕組みも用意した。 NVIDIA A100を6159基搭載 米NERSCのAIスパコン「Perlmutter」がついに稼働

NVIDIA A100を6159基搭載 米NERSCのAIスパコン「Perlmutter」がついに稼働

NVIDIAのデータセンター向けGPUを6159基搭載するスーパーコンピューターが、ついに稼働を開始する。同GPUを搭載するスーパーコンピューターとしては現時点において最大規模のもので、構築はHewlett Packard Enterprise(旧Cray)が担当している。 NVIDIAが新型AIワークステーション「DGX Station A100」を発表 2020年末までに発売

NVIDIAが新型AIワークステーション「DGX Station A100」を発表 2020年末までに発売

AIデータ処理に特化したNVIDIA製のワークステーションに新モデルが登場する。CPUをIntelのXeonからAMDのEPYCに変更した他、AmpereベースのハイエンドGPU「NVIDIA A100」を4基搭載することで「データセンター並みの機械学習処理を机の下で実現」した。 NVIDIAがデータセンター向けCPU「Grace」を開発 Armアーキテクチャを採用して2023年初頭に発売へ

NVIDIAがデータセンター向けCPU「Grace」を開発 Armアーキテクチャを採用して2023年初頭に発売へ

NVIDIAが、データセンター向けGPUに加えて“CPU”の開発を表明した。現在買収手続きを進めているArmのアーキテクチャを使って設計することで、省電力性と高速演算を両立したことが特徴だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 改めて考える単眼カメラとモノラルスピーカー それでも「iPhone Air」を推したくなる理由 (2026年02月09日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- ソニー、PCゲーマー向けの「DualSense」を3月5日に発売 USBケーブル付属 (2026年02月09日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- カプセルトイ「手のひらネットワーク機器」に第4弾モデル (2026年02月09日)

- AYANEO、Ryzen AIを搭載した7型WindowsポータブルゲーミングPC「KONKR FIT」を発表 (2026年02月09日)