「iPhone」「Apple Watch」「AirPods Pro」の“熟成”を選んだApple 現地で基調講演を見て得た実感:本田雅一のクロスオーバーデジタル(2/5 ページ)

写真の現像プロセスで画質を高める「Photonic Engine」

普段のPC USER向けのiPhoneに関する記事なら、新モデルの概要を説明してからSoCの解説をする所なのだが、iPhone 14/14 Plusは「A15 Bionicチップ」で据え置き、iPhone 14 Pro/14 Pro Maxは新しい「A16 Bionicチップ」を搭載したものの、現時点では分かっていることが少ない。なので、今回は全モデルに共通する改善ポイントである「Photonic Engine」に注目したい。

iPhoneのカメラ画質の向上は、SoCの性能向上に合わせて現像プロセスの改善を積み重ねてきたことが寄与している。中でも2019年モデル(iPhone 11)以降で利用できる「Deep Fusion」は、画質改善に大きく寄与する重要な改善だった。

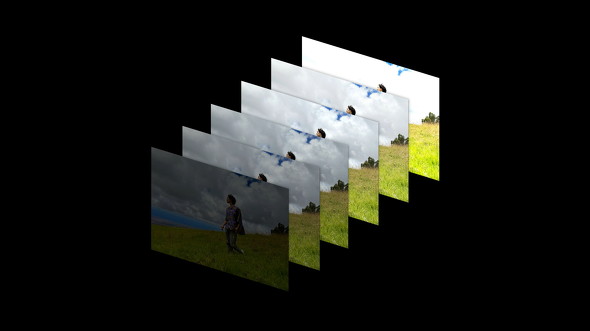

簡単にいうと、Deep Fusionは複数フレームの映像を画素単位で比較し、機械学習データを参照しつつベストな要素を組み合わせて1枚の写真として出力する機能だ。この際に使われる映像はいわゆる「現像処理」が済んだもので、センサーが出力するデータそのものではない。データの圧縮も行われている。

Deep Fusionは、シャッターを切る数フレーム前から映像を記録しておき、機械学習を併用しつつ合成してよりキレイな1枚の写真として出力するという機能だ。ただし、カメラセンサーが出力するデータそのものではなく、現像処理を行った後の映像に対して処理を行うようになっている

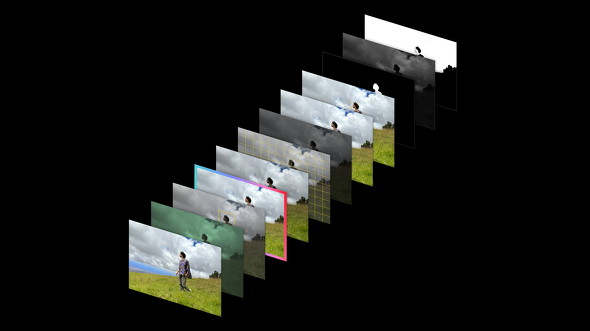

Deep Fusionは、シャッターを切る数フレーム前から映像を記録しておき、機械学習を併用しつつ合成してよりキレイな1枚の写真として出力するという機能だ。ただし、カメラセンサーが出力するデータそのものではなく、現像処理を行った後の映像に対して処理を行うようになっているPhotonic Engineは、このDeep Fusionをさらに改良した技術だ。具体的には、従来は現像処理の済んだ映像に行っていた処理を、現像前のデータ(RAWデータ)に対して行うように変更された。より多くの情報が残った映像を使って、ディテールの拡張を行うようになるので、画質のさらなる改善を期待できる。

……のだが、Photonic Engineには「謎」もある。Appleがキーノートで示した図にもある通り、RAWデータは完全なカラー映像ではない。そのため、かなり特殊な処理を行う必要があると推察されるが、Appleはその詳細を明らかにしていない。

また、Photonic Engineは今回発表された全ての新モデルに実装されているのだが、過去のiPhoneでは対応しないという。先に述べた通り、iPhone 14/14 PlusのSoCは2021年モデル(iPhone 13ファミリー)から据え置かれているため、非対応の理由をSoCに求めることも難しい。

Photonic Engineへの対応の可否を分けているのは何なのか――RAWデータを迅速に合成できるようにするには、間違いなくハードウェアに何らかの工夫が必要である。当のAppleが情報を開示していないので想像するしかないのだが、筆者はカメラのCMOSセンサーに何らかのからくりがあるのではないかとにらんでいる。

Appleによると、iPhone 14は低照度の撮影において新しいメインカメラ(広角アウトカメラ)で最大2.5倍、超広角アウトカメラとインカメラで最大2倍の品質改善を実現しているという(iPhone 13との比較)。「倍率で示されても良く分からない」という人も多いと思うが、理屈の上では画質の改善効果は大きいことは納得できるので、実際に撮り比べてみたい所である。

Photonic Engineでは、Deep Fusionの合成処理をRAWデータ段階で行うようになっている。RAWデータは完全なカラーデータではないため、その合成処理をするにはハードウェアにおいて何らかの工夫が必要なはずだが、Appleはその詳細を明らかにしていない

Photonic Engineでは、Deep Fusionの合成処理をRAWデータ段階で行うようになっている。RAWデータは完全なカラーデータではないため、その合成処理をするにはハードウェアにおいて何らかの工夫が必要なはずだが、Appleはその詳細を明らかにしていないメインカメラの変更にも注目!

今回の新しいiPhoneでは、先代モデルと比べてカメラ自体のスペックも底上げされている。中でも、メインカメラの強化は注目すべきだろう。

iPhone 14/14 Plusのメインカメラは画素数こそ約1200万画素に据え置かれているが、センサーサイズの大型化、レンズのF値の向上(F1.6→F1.5)などを行っている。スペック的にはiPhone 13 Pro/13 Pro Maxのそれと同等になった。

iPhone 14/14 Pro Maxは、メインカメラに約4800万画素の「クアッドピクセルセンサー」を搭載した。画素数が歴代iPhoneで最大なのはもちろんだが、クアッドピクセルに対応するセンサーをiPhoneとして初めて採用したことも注目ポイントである。

その名の通り、クアッドピクセルは隣接する4つの画素を1つの画素と見なして撮影する技術だ。iPhone 14 Pro/14 Pro Maxなら、4800万画素のセンサーを「巨大な1200万画素センサー」として使うことになる。

「なぜ画素をまとめるの?」と思うかもしれないが、それは光をより多く集めるためである。照度の低い場所では、センサーに入力される光がどうしても少なくなる。隣接する4つの画素を1つにまとめると、画素当たりの入力光量が4倍となり、結果的に低照度環境における撮影品質が向上する。

このセンサーは、普通の4800万画素センサーとしても利用できる。このことを生かして、ProRAW撮影モードでは全画素を使ったRAW撮影も可能だ。

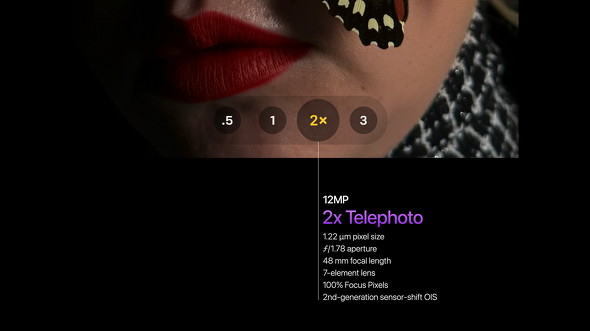

さらに、このセンサーの中央寄りの1200万画素分を使った「光学2倍望遠」撮影機能も搭載している。従来モデルの2x(2倍望遠)撮影とは異なり、センサーに写る映像を切り出す形となるので、従来よりも解像感の高いズーム撮影を行える。

4800万画素の中央寄り1200万画素を使った「光学2倍望遠」も利用できる。2x撮影自体は従来モデルでもできるが、より解像感の高いズーム撮影を行える。なお、光学2倍望遠は写真(静止画)だけでなく4K動画の撮影でも利用できる

4800万画素の中央寄り1200万画素を使った「光学2倍望遠」も利用できる。2x撮影自体は従来モデルでもできるが、より解像感の高いズーム撮影を行える。なお、光学2倍望遠は写真(静止画)だけでなく4K動画の撮影でも利用できるただ、クアッドピクセルセンサーを使ったカメラの品質は、メーカーによるチューニングが品質を大きく左右する。Appleがこのセンサーをどう使いこなして、自社開発のSoCとどのように組み合わせているのか、強力な動画の手ブレ補正機能と合わせて実機で確認してみたい。

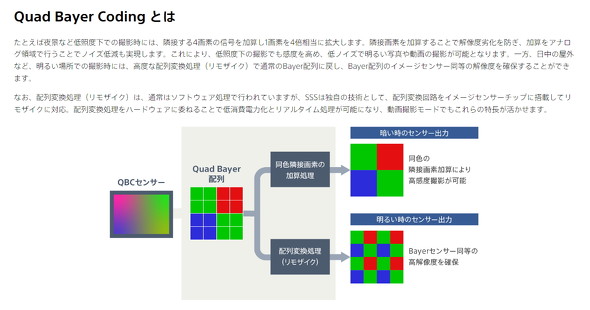

Appleの説明を聞く限り、iPhone 14 Pro/14 Pro Maxのメインカメラではソニーセミコンダクタソリューションズが開発した「Quad Bayer Coding(QBC)」を適用したクアッドピクセルセンサーを使っているように思える。QBCは隣接する4つの画素に同じ色のカラーフィルターを適用できることが特徴だ(出典:ソニーセミコンダクタソリューションズ)

Appleの説明を聞く限り、iPhone 14 Pro/14 Pro Maxのメインカメラではソニーセミコンダクタソリューションズが開発した「Quad Bayer Coding(QBC)」を適用したクアッドピクセルセンサーを使っているように思える。QBCは隣接する4つの画素に同じ色のカラーフィルターを適用できることが特徴だ(出典:ソニーセミコンダクタソリューションズ)関連記事

新「MacBook Air」や「M2チップ」だけじゃない Appleが3年ぶりに世界中の開発者を集めて語った未来

新「MacBook Air」や「M2チップ」だけじゃない Appleが3年ぶりに世界中の開発者を集めて語った未来

抽選制ながらも約3年ぶり本社に開発者を招待して行われたAppleの「Worldwide Developer Conference 2022(WWDC22)」。今回は「Apple M2チップ」と、同チップを搭載する新しい「MacBook Air」「MacBook Pro(13インチ)」といったハードウェアの新製品も発表された。発表内容を見てみると、おぼろげながらもAppleが描く未来図が浮かんでくる。 「連係カメラ」でiPhoneとMacの配信画質が格段にアップ! Webカメラとの決定的な違い

「連係カメラ」でiPhoneとMacの配信画質が格段にアップ! Webカメラとの決定的な違い

Appleが「WWDC22」で発表した、iPhoneとMacを使った「連係カメラ」機能は、思った以上にビデオ会議や配信などで役立ちそうだ。 「iPhone 11」「11 Pro Max」を試して実感したカメラ大幅進化 そして将来の強みとは

「iPhone 11」「11 Pro Max」を試して実感したカメラ大幅進化 そして将来の強みとは

9月20日の販売開始に先駆けて数日間、「iPhone 11」「iPhone 11 Pro Max」を試用した。進化したカメラの実力を中心として、実機に触れて試してみたインプレッションをお届けする。 「iPhone 13」はまたもカメラが劇的進化 大型のプロ用カメラをスマホでどこまで再現できるのか

「iPhone 13」はまたもカメラが劇的進化 大型のプロ用カメラをスマホでどこまで再現できるのか

Appleが「iPhone 13」シリーズを発表。販売台数でいえば、メインはProではない無印の「iPhone 13」だが、注目はやはり「iPhone 13 Pro」におけるカメラ機能の大幅進化だ。今回のモデルチェンジで大型のプロ用カメラにどこまで近づけたのだろうか。 「iPhone 13」「13 Pro」を試して分かったこだわりの違い コンピュテーショナルフォトグラフィーはここまで進化した

「iPhone 13」「13 Pro」を試して分かったこだわりの違い コンピュテーショナルフォトグラフィーはここまで進化した

これまでiPhoneのファーストインプレッションでは、SoCとその使い方といった視点でコラムを書くことも多かったが、今回の「iPhone 13」世代ばかりはカメラにかなりフォーカスした記事にせざるを得ない。評価用端末を使い始めてすぐにそう感じた。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- マウスの概念が変わる! ロジクールG「PRO X2 SUPERSTRIKE」が切り開く“身体感覚”と直結する新たなクリック体験 (2026年02月18日)

- 「UGREEN ワイヤレスHDMI送受信機」が25%オフの8999円に (2026年02月19日)

- 没入感抜群の360度ドローン「Antigravity A1」を楽しむには“国の許可”が必要? 知っておくべき航空法の基礎と申請のリアル (2026年02月20日)

- Copilot+ PCの「Dell 14 Plus」がセールで約12万円に (2026年02月19日)

- 日本初の限定Echo Dotは「ドラえもん」! 価格はあえての「1万1293円」 (2026年02月19日)

- ホール効果スティックで高耐久、精密な操作を実現する「BIGBIG WON BLITZ2 TMR コントローラー」がセールで9027円に (2026年02月19日)

- 繰り返し使える「充電式カイロ」5製品を試す そもそもリチウムイオン電池内蔵で温めても大丈夫? (2026年02月20日)

- Ryzen AI Max+ 395搭載で驚異の性能 着脱バッテリー&水冷対応の「OneXFly APEX」と天空オリジナルUMPCを見てきた (2026年02月20日)

- 手首への負担を抑えて快適に入力できる「Ewin エルゴノミクス キーボード」が15%オフの8483円に (2026年02月19日)

- Googleが「Pixel 10a」発表 499ドルでフラッグシップ級のAI機能を搭載 AirDropや衛星SOSも対応 (2026年02月19日)