一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略:本田雅一のクロスオーバーデジタル(2/4 ページ)

質の高い「学習」と「調整」をすれば司法試験に合格できる!?

先述の通り、現在公開されているChatGPTは、あくまでも「研究用プレビュー版」である。商用版ではないし、何らかの「正解」を導き出すためのサービスでもない。

ChatGPTはネットにある情報を分類しつつ、深層学習(ディープラーニング)を継続的に行っている。即時というわけではないが、回答に使われる学習データのアップデートも実施されている。

このことはメリットでもありデメリットでもある。比較的古い出来事や基本的な学問の知識には秀でている一方、間違った情報をすぐに正せず、誤情報を“自信を持って”答えてしまうこともあるのだ。

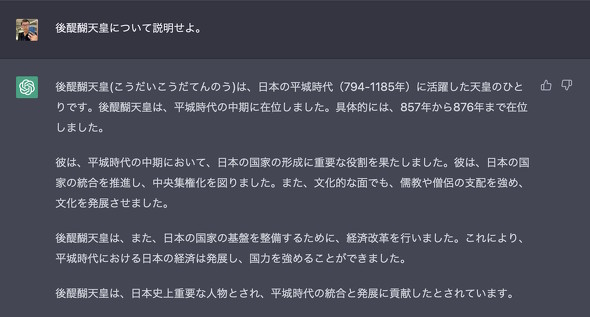

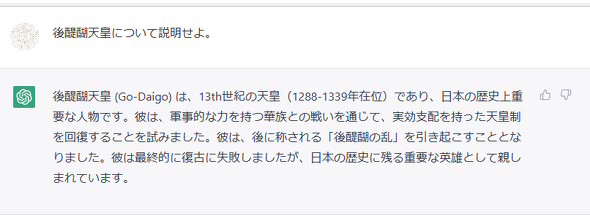

間違った情報については、そもそもの学習データが少ないゆえにもたらされることもあるようである。その一例が「日本の歴史」である。欧米(特にヨーロッパ)の歴史と比べると、日本の歴史はグローバルレベルでの文献が少ないせいか、でたらめな回答をしてくるケースが少なからずある。鎌倉時代に活躍した「後醍醐天皇」について質問した所、在位期間はもちろんのこと実績もでたらめな回答をされた際は驚いてしまった。

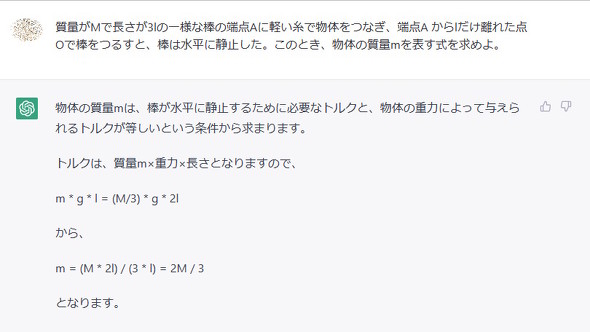

これは理系科目でも同様の傾向にある。ChatGPTに数学や物理(理科)の文章題を入力すると、その結果(≒回答)を“自信たっぷりに”出力してくれる。解法を知らないと「スゴい!」となってしまいがちだが、解法通りに解いてみると、実は間違っているというケースも少なくない。

試しに、2020年度大学入試センター試験の本試験の「理科2(物理)」で出題された以下の問題を入力してみてほしい(文章として入力するために一部を改めている)。

質量がMで長さが3lの一様な棒の端点Aに軽い糸で物体をつなぎ、端点Aからlだけ離れた点Oで棒をつるすと、棒は水平に静止した。このとき、物体の質量mを表す式を求めよ。

本来の答えは「2分の1エム」なのだが、ChatGPTがどう「答える」のか、ぜひ試してみてほしい。

このような誤答の原因は、主に「教師データの不足」や「学習データの分類や正規化の質」に起因しており、ChatGPT自体の品質が悪いわけではない。事実、学習データが多そうな学術論考について質問してみると、思った以上に質の良い回答を出してくる。「ChatGPTに論文の草案を出してもらおう」という人もいるほどである。

なお、ChatGPTのベースとなっているGPT-3.5を使い、特定目的で学習を強化/調整するとまた違う世界が開ける。米コーネル大学の研究によると、米国の司法試験(Bar Examination)において全国共通で課される問題の1つ「NCBE MBE」(※1)の模擬試験をGPT-3.5に回答させた所、平均正答率が50.3%となったという。

人間の平均正解率との差は約18ポイントとなったそうだが、学習がさらに進めば「試験に合格できるチャットボット」が登場する可能性もある。

(※1)MBE(Multistable Bar Examination):合計200問の4択問題。制限時間は3時間で、200問中175問が採点対象となる(どの設問が採点対象/非対象なのかは分からない)

関連記事

Windows 10/11でスタート画面やUWPアプリが開かない問題発生

Windows 10/11でスタート画面やUWPアプリが開かない問題発生

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、1月22日週を中心に公開された主なニュースを一気にチェックしましょう! AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

アジア地域でAI が大きな成果を挙げている5 つの分野をMicrosoftが発表した。 「障害のある人にAIができること」 MicrosoftとGoogleのアクセシビリティ最前線

「障害のある人にAIができること」 MicrosoftとGoogleのアクセシビリティ最前線

Microsoftの「Build 2018」、Googleの「Google I/O 2018」――2社の年次開発者会議が続いた1週間。両社とも障害のある人を支援するAI活用の発表が印象に残りました。 マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

日本マイクロソフトは、AIの開発と活用において重視すべき6つの倫理的用件を発表した。 人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

シンギュラリティによってAIが人類を支配する世界がやって来るかどうかはさておき、現時点では人間がAIを悪用するリスクの方が怖そうです。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- ロジクールの「MX MASTER 4」とマウスパッドのセットが1万9400円に (2026年02月06日)

- 宅内ネットワーク環境の10G化に適した「TP-Link DS108X」が13%オフの4万803円に (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- 自宅のどこでも本格サウンドが楽しめる「Bose SoundLink Home Bluetooth Speaker」が3.3万→2.3万円に (2026年02月05日)

- Insta360初ドローン「Antigravity A1」実機レポ 360度カメラが生む“空中を自由に見渡す”没入感とは? (2026年02月06日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)