一部組織では利用禁止も! OpenAIの「ChatGPT」のスゴさとMicrosoftの戦略:本田雅一のクロスオーバーデジタル(3/4 ページ)

「勘違い」から始まっても正解に近づける

ChatGPTは、その名の通りチャット(対話)式のユーザーインタフェース(UI)を採用している。そのこともあって、一度では正解の回答にたどり着けなくてもチャットを繰り返すことでより正確な回答に近づけるという特性も備えている。チャットボットとして利用する場合に重要な要素といえる。

機械学習ベースのAIは、学習によって多くのデータを蓄積し、その関係性を整理することには長けている。一方で、データの質や内容を評価することはできない。

優れた推論モデルを用意し、高品質の学習データをたくさん取りこめば「より確からしい情報」を選択するようにはなる。しかし、それはあくまでも“より確からしい”というだけで、意味を自ら理解して選び取っているわけではないということである。

極めて論理的な(筋道がしっかりとしている)ように見えて、よくよく見てみると全くそうでない――ChatGPTがそんな不正確な回答(文章)を生成してしまう傾向にあるのは、そのような事情が背景にある。

しかし、ChatGPTには「AIの間違い(人間で言えば勘違い)」をチャットで修正できる仕掛けも組み込まれている。

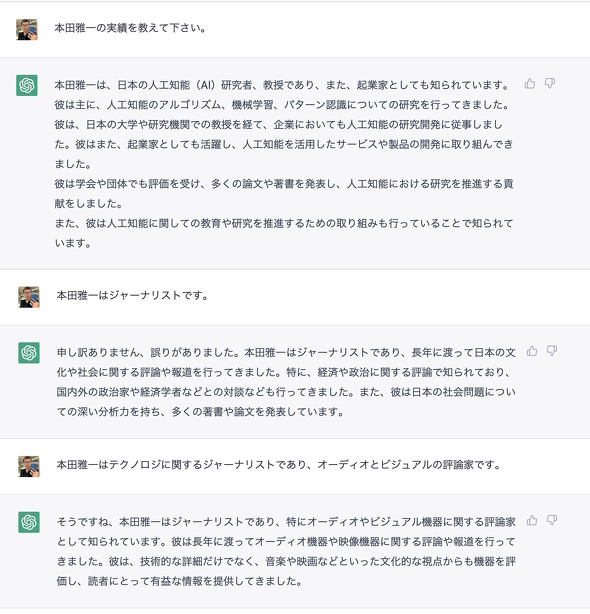

ChatGPTは有力な情報が複数ある場合に答えを外しやすい。ネットにそこそこ情報はあるが、しかしそれほど多くはなく、分類や異なるデータの比較が難しい――そんな情報について尋ねると、予想通りに不正解を出してくる。その一例として、手前みそだが筆者(本田雅一)について、ChatGPTに尋ねてみよう。

手始めに「本田雅一の実績を教えて下さい」と聞いてみる。筆者の姓(本田)と名前(雅一)は、共に珍しいものではないせいもあってか、全く見当違いの回答を寄せてきた。調べてみた限りにおいて、そのような実績を持つ「本田雅一」は存在しないので、「本田」か「雅一」をキーワードに、より確からしい情報を引っ張ってきたのかもしれない。

そこで「本田雅一はジャーナリストです」と返答すると、謝罪込みで別の回答を提示してきた。しかし、全く身に覚えがない経歴が出てきた。今度は読み方をベースに別の「ほんだまさかず」のプロフィールを紹介してしまったようである。

仕方がないので「本田雅一はテクノロジに関するジャーナリストであり、オーディオ&ビジュアルの評論家です」と詳しい返答をしてみると、「そうですね」という相づち(?)と共にようやく自分の身に覚えのある人物像にたどり着いた。

このように、「学習データには含まれるが、表層には出てこない情報」というものも存在する。そのような場合でも、会話を重ねることでより正確な「より確からしい情報」を引き出せるのだ。

関連記事

Windows 10/11でスタート画面やUWPアプリが開かない問題発生

Windows 10/11でスタート画面やUWPアプリが開かない問題発生

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、1月22日週を中心に公開された主なニュースを一気にチェックしましょう! AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

AIが落ちこぼれ学生を未然に防ぐ? MicrosoftがAIで成果を上げている5つの分野

アジア地域でAI が大きな成果を挙げている5 つの分野をMicrosoftが発表した。 「障害のある人にAIができること」 MicrosoftとGoogleのアクセシビリティ最前線

「障害のある人にAIができること」 MicrosoftとGoogleのアクセシビリティ最前線

Microsoftの「Build 2018」、Googleの「Google I/O 2018」――2社の年次開発者会議が続いた1週間。両社とも障害のある人を支援するAI活用の発表が印象に残りました。 マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

マイクロソフトが考える、AI開発に必要な「6つの倫理的条件」とは

日本マイクロソフトは、AIの開発と活用において重視すべき6つの倫理的用件を発表した。 人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

人工知能の悪用を防ぐために OpenAIの論文が示すリスクとは?

シンギュラリティによってAIが人類を支配する世界がやって来るかどうかはさておき、現時点では人間がAIを悪用するリスクの方が怖そうです。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- ロジクールの「MX MASTER 4」とマウスパッドのセットが1万9400円に (2026年02月06日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- 宅内ネットワーク環境の10G化に適した「TP-Link DS108X」が13%オフの4万803円に (2026年02月06日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)

- 自宅のどこでも本格サウンドが楽しめる「Bose SoundLink Home Bluetooth Speaker」が3.3万→2.3万円に (2026年02月05日)

- Insta360初ドローン「Antigravity A1」実機レポ 360度カメラが生む“空中を自由に見渡す”没入感とは? (2026年02月06日)

- マウスコンピューターやユニットコムの親会社「MCJ」がMBOで非上場化へ ベインキャピタル傘下のファンドがTOBを実施 (2026年02月06日)