M4 Mac miniで「gpt-oss」は動く? 動作が確認できたローカルLLMは……:“超”初心者向けローカルAI「gpt-oss」導入ガイド(5)(3/5 ページ)

M4 Mac mini 16GBモデルでgpt-oss-20bを読み込んでみたが……?

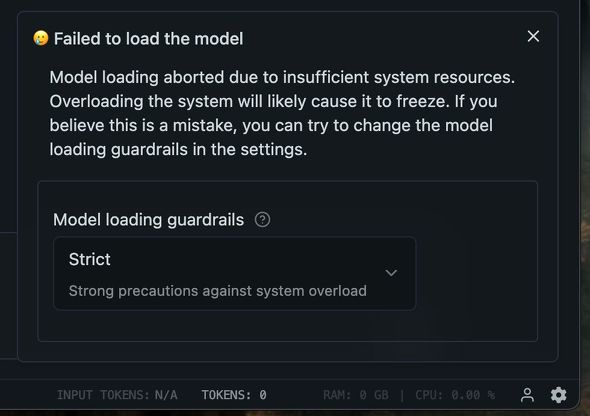

準備も整ったのでいざgpt-oss-20bを読み込んでみたのだが、どうもうまくいかずエラーが発生してしまった。

どうやらgpt-oss-20bを読み込むと、過負荷によりフリーズしてしまう恐れがあり、LM Studioがモデルの読み込みをストップしたようだ。この機能を「Model loading guardrails(ガードレール)」と呼び、デフォルト設定値では「Strict(厳格モード)」で設定されている。

ガードレール設定はそれぞれ「Strict(厳格)」「Relaxed(緩和)」「Off(無効)」の3種類が用意されているのだが、M4 Mac mini 16GBモデルの場合、「Relaxed(緩和)」でもgpt-oss-20bが読み込めなかった。

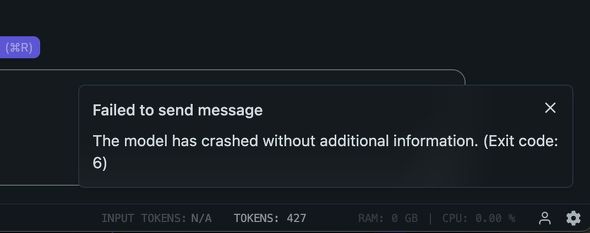

メモリの消費量的におそらく動くだろうと踏んでガードレール設定を「Off(無効)」に設定したところ、gpt-oss-20bの読み込みが完了した。

続いて意気揚々とチャットインタフェースを使って、gpt-oss-20bを利用しようとしたところ、gpt-oss-20bがクラッシュしてしまい、プロンプトの生成が強制終了してしまった。

この状態で再度gpt-oss-20bを読み込み、再度チャットメッセージを送信したところ、OS自体がクラッシュしてしまった。M4 Mac miniのユニファイドメモリは、CPUとGPUで共有して利用する関係上、LM Studioのメモリ消費量が限界値近くなると、OSの動作自体が不安定になってしまうようだ。

実行前は「スワップを利用すれば動作するのでは……?」と踏んでいたが、残念ながら思惑通りにはならなかった。もし、gpt-oss-20bをmacOSで利用する場合、ユニファイドメモリは24GB以上搭載するのが無難なようだ。

関連記事

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 手のひらサイズの小型PCがお得に! GEEKOMが「冬セール」を開催中 (2026年02月12日)

- ワコムが安い? 驚きの2025年を振り返り メモリ高騰におびえる2026年の「自作PC冬眠」と「次世代CPU」への期待 (2026年02月12日)

- カラー電子ペーパーで好きな画像を飾れる「SwitchBot AIアートキャンバス」が楽しい 13.3型の迫力と魅力 (2026年02月13日)

- キンタロー。も驚くほぼ「入力ゼロ」の“次世代”確定申告 2026年の弥生は3つのAI活用とデスクトップ製品強化を両輪に (2026年02月12日)

- PC値上げの波はVAIOにも? 糸岡社長が明かす「マウスエフェクト」への対応とブランド価値の向上 (2026年02月13日)

- 新ARグラス「XREAL 1S」を試す 解像度と輝度が向上、BOSEサウンドで没入感アップ “3D変換”も大きな魅力 (2026年02月10日)

- アイ・オー、拡張ドック機能を備えたType-C接続対応の27型4K液晶ディスプレイ (2026年02月12日)

- 元Appleのジョナサン・アイブが手掛けるフェラーリ初EVの内装デザイン公開 物理ボタンとデジタルの融合 (2026年02月10日)

- 「雲」から降りてきたAIは「パーソナル」な存在になれるのか――開催から1カ月経過した「CES 2026」を振り返る (2026年02月12日)